更新日時:

2013年04月07日 1:05 pm

画像処理について (2007.07.08)(2013.4.3更新)

■ 画像処理とは(Image Data Processing)

粒子を撮影した画像から粒径と頻度を自動的に求める。

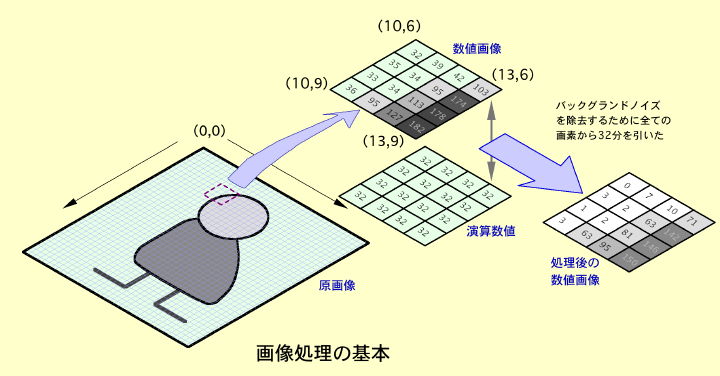

画像処理では基本的な処理方法。

画像処理とは、カメラやスキャナーなどから得た画像を加工して、欲しい画像情報を抽出する手法を言う。

画像に含まれる興味ある情報を抽出するために、興味のない画像を排除することが画像処理の基本的な手法である。

画像処理の簡単な方法は、得られた画像を手で書き写す方法がある。

欲しい画像だけを書き留めるだけでよい。

銀塩フィルムの場合は、現像や焼き込みを通して欲しい画像を得ることがある。これらの手法はアナログ手法である。

デジタル画像処理は、画像を「画素」(Pixel = Picture Element)と呼ぶ単位に区分けすることから始まる。

この言葉は、1965年に公になった言葉で、米国NASAが火星に探査衛星を送り込み、衛星から地球に送って来た画像に対して使い出したようである 。

(詳細は、「最初の画像処理 - 米国NASAによる火星探査 」を参照。)

画像を点画のように分解してコンピュータにかけて処理したのはNASAが初めてだったようである。

デジタル画像の根本単位は、画素 = Pixel だけかと言うとそうでもなく、1967年に米国マサチューセッツ工科大学のWilliam F. Schreiberは、「Pel」(= Picture element)が良いと学会で発表した。

しかし、これは一般的ににならなかった。時代は、Pixelを選んだようである。

昨今のデジタルカメラは、画素単位で画像を保存しているので、デジタル画像になっている。

画素単位で濃度処理をすることがデジタル画像処理の基本である。

【画素と濃度】

デジタル画像処理の第一歩は、画像を画素という情報単位に区分けすることから始まる。画像を構成する画素数は、基本的に多ければ細かな画像処理ができる。

画素は、画像の基本単位であり、画像の位置情報と濃度情報を持っている。

つまり、デジタル画像は、

(Xi、Yj、Dij) ・・・(IDP1)

Xi: X方向の画素の位置

Yj: Y方向の画素の位置

Dij: X,Yの交点の濃度情報

で示される座標情報と濃度情報で構築されたデジタル情報となる。

画像が、X = 640、Y = 480、D = 256という範囲で区分けされている場合、つまり、横方向640画素、縦方向480画素、濃度8ビット256階調である場合、その画像は、

640 x 480 =307,200画素 ・・・(IDP2)

で構成され、それぞれの画素に256階調(8ビット)の濃度情報が当てられる。

画像がカラーである場合は、濃度情報がさらにRBG(赤、青、緑)の三原色に輝度が割り振られるので、以下の情報量となる。

(Xi、Yj、DRij、DGij、DBij) ・・・(IDP3)

Xi: X方向の画素の位置

Yj: Y方向の画素の位置

DRij: X,Yの交点の赤色濃度情報

DGij: X,Yの交点の緑色濃度情報

DBij: X,Yの交点の青色濃度情報

さらに、映画カメラや計測カメラ、高速度カメラのようにたくさんの画像を取得して動画像を得る場合、画像に時間情報が加わるので、

(Xi、Yj、DRij、DGij、DBij、Tn) ・・・(IDP4)

Xi: X方向の画素の位置

Yj: Y方向の画素の位置

DRij: X,Yの交点の赤色濃度情報

DGij: X,Yの交点の緑色濃度情報

DBij: X,Yの交点の青色濃度情報

Tn: 時間情報 = フレーム番号/撮影速度

5つの次元情報を持つことになる。

【画像の情報量】

従って、640 x 480画素、カラー24ビットの画像は、1枚あたり921.6KB( = キロバイト)の情報量を持つ。

640画素 x 480画素 x 3バイト@RGB/画素 = 921.6KB ・・・(IDP5)

KB: キロバイト =1000バイトを示す。1000バイトは8000ビットに相当する。

この容量は、1990年代までのパソコンの一般的な記録媒体(3.5型フロッピーディスク、1.4MB)の1枚分に匹敵するもので、画像を扱うことがどれほど大変なことかがこの容量を見ただけで理解できる。

2000年頃まで使われていた3.5型マイクロフロッピーディスクは、

1セクタ=512Bを約45ミリ秒かけてアクセスするので、

921.6KBのデータは、

45E-3秒 x 921,600バイト /512バイト = 81 秒 ・・・(IDP6)

となり、81秒(1分21秒)をかけて1枚の画像を読み出すことになる。

(実際にはセクターをアクセスしなければならないのでシークタイムがかかり、これより長くなる。)

このことからみても、1990年代の画像処理は(というより画像を扱うことは)時間のかかることであったことが理解できる。

1秒間に30枚の割合で撮影を行うVGA(640x480画素)ビデオカメラは、1秒間当たり27.65MBのデータ量となる。

これが1分では1.66GBとなり、1時間では99.5GBのデータ量となる。

このような動画像をまともにデジタル録画すると、4.7GB容量のDVDを使っても、3分弱の録画しかできない計算になる。

このため、デジタル画像処理の進んでいなかった2000年までは、映像と言えばテレビ放送で使われているアナログビデオ信号(NTSC、RS170信号)が主流であった。

当時は、アナログ映像機器の方が種類が豊富で安価に入手できたのである。

デジタル映像は、コンピュータの処理能力の向上にともなって、さらにRAM、CD、DVDなどの記録媒体の高速化大容量化や画像の圧縮技術の確立によって花開いた。

1990年代以降にそうした動きが出始め、2000年より急速に普及した。

2011年7月からはテレビ放送がデジタル放送となった。

現在(2011年)にあっては、大容量の画像データをまともに扱うことはない。

ほとんどの場合、画像の圧縮を行っている。画像の圧縮も一種の画像処理手法である。

しかし、本Webでは、画像の圧縮は主催者の意図するところではないので(圧縮は計測手段としてではなく、画像通信、画像保存の観点から進化してきたので)、あまり深くは触れない。

画像圧縮は、ともすると原画像に大幅な手が加えられ、解析上にとっては好ましくないことがある。

例をとれば、MPEGという圧縮技術である。

これは動画に対する圧縮技術である。原理を簡単に説明すると、正常な画像は飛び飛びにしか与えられておらず、その間の画像は補間という形で画像が作られる。

例えるならば、1秒間に30枚を再生する動画像があるとすると、この30枚の内1/10だけをまともな一枚の画像(キーフレーム)として、残りの9/10の画像はキーフレームからの変化分だけを情報している。

JPEG画像などが画像の細かい所を間引く空間圧縮であるのに対し、MPEGは時間方向を圧縮する時間圧縮である。

この方式の動画では、細かな動きは捨てられてしまう可能性がある。

従って、このような手法による画像は、静止画を隅から隅まで見る画像解析では支障が出る場合がある。

コンピュータが発達していなかった1980年までは、画像処理を行うのに専用の処理装置が用いられていたが、2000年以後、コンピュータの処理能力の向上に伴って、専用の画像処理装置を使わずにコンピュータそのもので処理できるようになった。

2000年以前のパソコンでは到底不可能と言われながら、現在では普通の技術となった画像技術に以下のものがある。

・インターネットによる動画配信(MPEG)。

・1000画素x1000画素の画像のインターネット配信(MPEG)。

・640画素x480画素の動画(30コマ/秒)を直接コンピュータに録画(MPEG)。

・インターネットによるテレビ会議(Skype、FaceTime)。

・ギガイーサネットを使った画像通信、及びイーサネットカメラによるコンピュータへの直接録画(GigE)。

これらの技術は、ハードウェアの高速化・大容量化もさることながら、画像を軽くするという圧縮技術の発達も見逃すことができない。

画像圧縮技術の恩恵なくして、インターネットの映像配信も、DVD映画も、デジタル地上放送の確立もあり得なかった。

【画像の基本処理】

計測用として使われる画像処理の最も代表的なものは、二値化処理である。

二値化処理は、画像を白と黒だけの情報にして、形状をシンプルな線画(二値化画像)に置き換えて画像処理をする手法である。

二値化画像から物体の形状や大きさ、数などを求めていた。この処理は、粒子計測や流体計測、物体の形状認識に使われた。

二値化処理を行うのは、処理装置に対する負荷が軽減でき処理時間を短縮できるためであった。

最近では処理装置の性能が上がったので、濃度階調をそのまま保持して処理することが一般的になった。

一般に濃度情報が大きいほど計測精度が向上する。

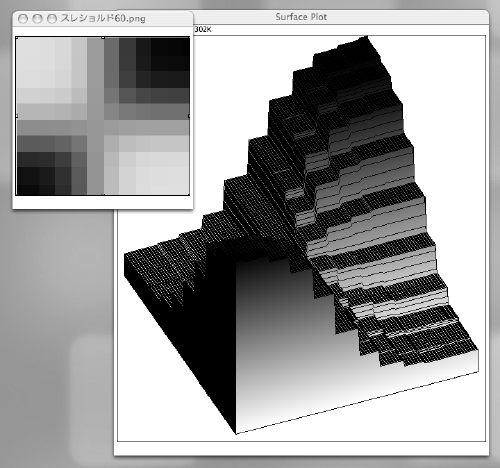

二値化画像処理のサンプル。

左図は原画像。

下図は、原画像を二値化処理したもの。

使用した画像処理ソフトウェアは、ImageJ。

原画像は、8ビット(0〜255階調)の濃度を持っている。

二値化処理は、任意の階調で黒と白の二つに分けて白か黒かの1ビット画像にする。

二値化画像は、画像を極端な濃淡像で識別化してしまうため、画像形状がわかりやすくなる反面、詳細な画像の情報(ディテール)がなくなる。反面、処理は楽になる。

ImageJでは、二値化処理を行う場合、左のような操作パネルが表れる。

この操作パネルは、二値化処理だけでなく、コントラストや明るさ調整もできる。

「Thresh」というボタンを押すことにより、二値化処理となる。

操作パネル上部のヒストグラム図が元画像の濃淡像の分布図であり、縦の直線が二値化を行うしきい値である。しきい値はカーソルで変更することができる。

【画像処理の代表例】

画像処理の代表的なものを以下に挙げる。

白黒濃淡画像に色をつける処理。Pseudoカラー(疑似カラーと呼ばれる。)

斜め投影撮影画像(上)を変換処理した画像(下)

使用ソフトウェア: GraphicConverter ver.5.9

・画像に色をつける - 画像の濃度に応じて色をつけ、濃淡の差違を

判別しやすくする。

海面の温度差を色をつけて表示し、温度分布

を見る。

密度の変化を濃度変化として撮影し、これに 色をつける。 ・画像パターンの認識をする - テンプレート画像(原画像)と対象 画像を重ね合わせ、その差違を検出する。 電子基板の回路パターンの不具合を見つける。 液晶プロジェクタの画素欠陥を見つける。 製品の仕上がり形状を検査する。部品のバリ、 寸法の差違の検査を行う。 ・歪んだ形状を正しく直す - 斜めから撮影した画像を正しい投影像 に変換する。 レンズの歪みを補正する。 ・地球表面を調べる(リモートセンシング) - 衛星からの画像や航 空写真を使って地表面の資源、海上面の温度、 建造物の識別を行う。植物の生態を調べる。 露天鉱物を調べる。海の汚染を調べる。 ・地図を作成する - 航空写真から地形を作成する。 ・発光物体の計測をする - 恒星の温度を波長の違う画像から求める。 太陽の温度をいくつかの異なった波長画像から 求める。高温の金属温度を計測する。 ・流れの可視化 - 特殊な光源(レーザライトシート、シュリーレン) やトレーサを使って流体の速度や方向を解析す る。 ・機構研究 - 機構部品の動きを解析する。部品の間接部にターゲッ トマークを貼付し、マークを自動的に読み込ん で(トラッキングして)変位や角度、速度など を求める。

・粒子解析 - 粒子の大きさと頻度を画像から求める。

・噴霧解析 - 高速で噴出する噴霧の到達距離、噴霧角度、噴霧密

度、噴霧粒径などを画像から求める。

・寸法測定 - テレセントリックレンズを用いて被写体の寸法を画像

から測定する。

・運動解析 - スポーツ選手の運動を計測カメラを使って解析する。

・競技判定 - F1レース、100m走、水泳競技、競馬などの着順を画

像によって判定する。

・安全評価試験 - 自動車衝突試験、エアバッグ展開試験、ロケット

発射安全試験、

チャイルドシート、ブレーキ挙動試験など各種

安全試験の解析。

【最初の画像処理 - 米国NASAによる火星探査】 (2007.07.16)(2008.10.20追記)(2012.08.24追記)

世界で最初に大々的にデジタル画像処理を行ったのは、米国NASA(JPL)である。

以下、当時行われた画像処理プロジェクトを紹介したい。

画像処理プロジェクトは、火星地表面の撮影とその画像処理から始まる。

● デジタル画像

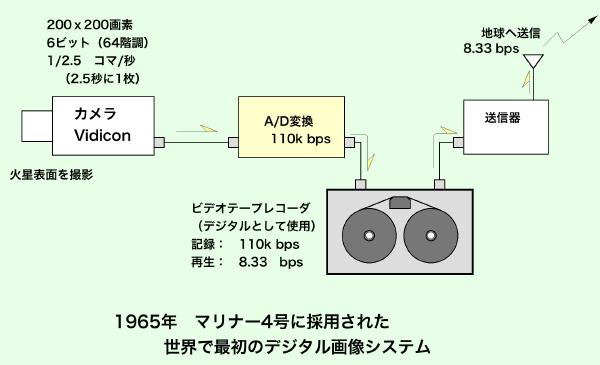

デジタル画像処理を最初に開発したのは、米国JPLであり、1965年のことである。

JPLは、正式名称を Jet Propulsion Laboratory (= ジェット・プロパルジョン・ラボラトリー)と言い、NASAの研究組織として惑星の探査研究を受け持っている。

2012年8月に火星探査機「Curiosity(キュリオシティ)」が火星に無事着陸し、この研究所の名前と関心が高まった。

この研究所は、カルフォルニア工科大学が中心となって研究運営がなされている。

当時、デジタル画像処理を担当した開発責任者は、クレイトン・ラボー(Clayton LaBaw、1935年〜、当時30歳)氏であった。

クレイトン氏は、マリナー4号(Mariner 4)のデジタル映像転送システムの設計にもたずさわり、カメラの運用責任者でもあった。

● 3億キロ彼方からの画像伝送

NASAでは、1962年11月に火星に探査船を送るプロジェクトを立ち上げた。「マリナー4号プロジェクト」と呼ばれたものである。総予算は、1億2500万ドル(当時の円レートで450億円)であった。

当時、全米では火星に生物が存在すると深く信じられていて、大統領はじめ全米が火星の様子を探るこのプロジェクトに大きな関心を寄せていた。

マリナー4号は、1964年11月に打ち上げられて、翌年、1965年7月に火星軌道に入り、地上高16,900kmから地表面を200x200画素の解像力で撮影を行い、合計22枚の画像を地球に送ってきた。

この画像は、火星表面の1%にあたるものであった。

200x200画素の画像は、1画素あたり3kmに相当する600km x 600kmの範囲の画像であったが、地球から撮影して得た画像よりも数桁も良好な分解能を持っていた。

このプロジェクトの技術的チャレンジは、

(1)火星地表を鮮明な画像を撮影することと、

( 2)得られた画像をデジタル信号に変換して遠く離れた地球に送り届けること

であった。遠く離れた宇宙空間で画像データを送受信する通信技術は、これに先立つ1962年、金星に送り込んだマリナー2号のデータ通信で採用され実証された「Phase - Locked Loop = PLL」という通信方式で目途が立っていた。

PLLは、宇宙通信史上画期的な技術発明であった。これは、送り手と受け手の両方が原子時計のような非常に正確な時計を持って同期をとり、同期に合わせて「0」と「1」のデータ情報を送るものであった。

二つの信号しか送らない、まさにデジタル通信であった。

この技術をラボー氏らは画像通信に応用した。ラボー氏の最初の仕事は、このプロジェクトを遂行するにはデジタル通信システムが絶対必要であることを、NASAのトップの人たちに認識させることだった。

普通のアナログ・ビデオシステムは、すでに探査機「レンジャー」に乗って月に飛び、あるいは「タイロス」衛星に乗って地球軌道を回っていた。

普通に考えればアナログ方式で問題ないと考えるのが当然だった。

しかし今回は、地球周回や月などと違って桁外れの距離である。地球と火星の距離は太陽を挟んで反対側に位置すると3億キロに達する。光の速度でも17分かかる距離である。テクノロジーのスケールをそのまま相似的に当てはめるわけにはいかなかった。

デジタルのシステムこそが画像データの超遠距離伝送を高い忠実度で実現してくれる唯一のシステムであると考えざるを得なかった。

【ルナ3号 Luna 3】

宇宙から画像を送る試みは、マリナー4号が初めてではない。

ソビエト連邦(USSR)が1959年10月4日に打ち上げたルナ3号は、月面の裏側を撮影して地球に画像を送ってきた最初の出来事である。

マリナ−4号より6年も前のことである。

このミッションでは、35mmフィルムカメラで撮影が行われ、衛星に積み込んだ現像機で自動現像を行った。

そして、仕上がった銀塩画像をファクシミリのような機械(スキャナー)で読み取って衛星(ルナ3号)が月の表側に出てきたときに地球に送った。

ルナ3号は、29枚の写真撮影を行ったうちの17枚の画像を送ってきた。人類が初めて見た月の裏側であった。

当時は、デジタル信号の送信技術が確立していなかったので、フィルム画像を読み込むスキャナーの電気信号をそのまま増幅して地球に送信した。

1画像を1000本の走査線で読み取ったと言われている。

ルナ3号は、地球から月へ向かう軌道に乗って月の南極側から裏側に回り込み、40分かけて北極側を縦断する形ですり抜けて、月の裏側の70%相当を29枚の写真に収めた。これを地球へ向かう軌道途上で現像して地球に送信した。

画像データは、衛星が地球に遠い距離にあっては、極めて低いデータ送信量で送信し、地球に近づくにつれてデータ通信速度を上げたと言われている。

ルナ3号は、月と地球の周回軌道を回りながら地球に近づいた時に写真を送るという作業をしていたようで、最終的に17枚の画像を送ってきた。

10月8日に撮影された月の裏側写真は、10月18日までの10日間に渡って送信作業が行われたが、10月22日に交信が途絶えた。

交信が途絶えたルナ3号は、そのまま周回軌道を重ね、1960年4月頃まで生き延びてその後大気圏に落ちたと言われている。

17枚の画像はアナログ信号であったので画質がひどく悪く、ノイズが多かったと言われている。

ソビエトの科学者は、これを画像処理によってなんとかものになる画像にした。

1960年当時、電子回路は真空管の時代であった。トランジスタは1960年代にアメリカで発達する。

従ってソビエトではトランジスタの技術はないため、衛星に積み込まれた電子機器は真空管であった。

● 画像をデジタル信号に変換する仕組み

火星探査衛星マリナー4号に搭載されたカメラは、フィルムカメラではなく、現像を行わない直接撮像のテレビカメラであった。

カメラは、当時のテレビ局が最新のスタジオカメラ用として採用していた「ビジコン管」(Vidicon tube、撮像管、真空管)である。

もちろん、白黒テレビであった。

当時、CCDなどの固体撮像素子もなかった。

テレビ放送は、NTSC(アメリカと日本などが採用したテレビ放送規格。2011年までアナログ放送として使われた)と呼ばれるアナログ送信技術が規格化されていて、電子映像装置はすべてNTSC規格に準拠していた。

従って、ビジコン管は走査線525本の性能を持っていた。しかし、宇宙通信ではアナログ通信が行えないため、データの通信が確実におこなえるデジタル信号に置き換えなければならない。

当時のデジタル通信では、525本の情報は多すぎて送信することができなかったので、ビジコン管の走査線を変更して200本と低くした。

画像を形作る走査線は、光の強弱を電圧の強弱に変えたアナログ電気信号であるため、マリナー4号ではこのアナログ信号をA/D変換器(Analog Digital Converter)を使ってデジタル信号に変換した。

A/D変換器は、トランジスタとコンデンサで組み合わせた電子回路で、弁当箱程度の大きさであった。

この装置を使って、カメラ画像を200x200画素、6ビット(64階調)濃度に変換した。

ビジコンカメラがとらえた画像は、1枚あたり240kビット(30kB)のデータ容量を持つデジタル画像となった。

このデジタル画像を1枚作るのに2.5秒かかった。

A/D変換されたデジタル信号は、一旦、デジタル・テープレコーダに記録された。

これの意味するところは、当時、たったこれだけのデータ情報を記録する電子メモリ(ICメモリ)がなかったことである。

それ以上に、200x200画素、それも64階調とお世辞にも高画質といえないデジタル画像を、2.5秒かけてしか作れない当時のデジタル技術のレベルを見落としてはならないであろう。

デジタル画像は、まだ産声を上げたばかりであった。

当時は、デジタル技術を支える半導体製造技術が成熟していなかったのである。

デジタル・テープレコーダが使われたのは、ビジコン管画像の撮像スピード(110Kbps相当)に対応できる通信速度が確保できなかった(当時のデジタル通信は8.33bpsが限界であった)ことと、火星の裏側に回り込んだ際に地球にデータが送信できない問題があり、データは一旦テープで保存して後でゆっくり送信する必要があったためであった。

宇宙通信データも、当時は1秒間に8ビットを送るのが精いっぱいであった。

200x200画素のデータを地球に送るのに8時間もかかった。

● 火星から送られるデータを解析して火星の姿を推測

火星から送られてきた画像データを画像処理する担当者は、ブルース・マーレー氏(Bruce Murray、1931年〜、当時34歳、のちカリフォルニア工科大学名誉教授・JPL = ジェット推進研究所所長)であった。

火星から送られてきた数値データは、ブラウン管上に明暗の輝点として画像変換する「フィルムレコーダー」によって写真を作った。

これに要した時間は、8時間(8.33bps換算)であった。

小型の白黒モニタに1回に一本ずつ白い線が浮き出て、それの繰り返しによって画像を作っていった。

最初に受信した画像は、真っ白な紙のようなものだった。要するに何も写っていないのと同じ画像であった。

当時、全米は火星の写真を今か今かと待ちわびていたのでマスコミの取材攻勢が強かった。

彼らはマスコミの追求を避けるため、研究所の最上階に隠れて分析の仕事を行った。

部屋の外にはマスコミを近寄らせないよう、武装したガードマンが見張った。

ドアには警報機さえついていた。

そうした環境下で、三日三晩不眠不休で火星から送られてきた画像データの解明が行われた。

● 画像処理

研究チームは、火星から送られてきた画像データが真っ白な画像だったので、数値データでマッピングをすることを思いつき、画素一個一個の濃淡を数字として印字し、紙を走査線一本ごとに切り分けて数字の並んだ細長いテープを床に並べてつなげた。

床の上では作業がしずらいので、テープの集合をカーテンのように壁に掛けた。

1枚の絵は200本の走査線でできているから切り分けられた紙テープは200本になった。

こうして出来上がった数字のマップを眺め回して、基準記号に相当する数値を見つけ出した。

これは画像の歪みを補正するための記号で、いったんこれを見つけてこれを基準にして見ていくと、次第に画像全体の様子がつかめてきた。

緩やかな丸みを帯びた領域らしきものを見て、彼らはこの画像が惑星の端の地平線を写したものではないかと気づいた。

その想像が正しければ、惑星の外側には宇宙空間が広がっているはずであり、そこは明度でいえば暗闇であるはずだと考えた。

暗闇ならばその数値は「0」のはずであったが、送られてきた数値は「24」だった。

彼らにとって、暗闇が「24」の数字で表されているという発見こそが、苦悩と焦燥の三日間の中で最も光明を感じた瞬間だったに違いない。

「24」は画像で言うところのバックグランドノイズであった。

彼らはこれを手がかりに、4万個のデータ(200x200画素)全てに渡って「24」を引く手計算を行い、濃度データを0から39までとした。

カメラは、もともとは6ビットの64階調で設計されていたので、64階調のうちノイズ成分の24を引くと40階調、すなわち0〜39階調となる。

5ビット程度の濃度階調ではとて暗い画像となるめ、コントラストを上げるためにこれらに1.6を掛けた。

これら一連の作業がまさしく画像処理であった。

彼らは、米国大統領を始め全米、全世界の人々の期待を背負いながらそのプレッシャーと闘い、不眠不休でデジタル画像処理を開発して行ったと言える。

● 処理コンピュータ

光明が見えだした手作業による作業手順は、直ちにコンピュータのプログラムに作り直されることになった。

マリナー4号のグループが利用していたコンピュータは、米国DEC社(Digital Equipment Corporation、1957年創設、1998年Compaqに買収→2002年HPに買収)が製造した「PDP-4」(Programmable Data Processor 4型機)というミニコンピュータであった。

このコンピュータは、学術計算用コンピュータとしては最高級に属するものであった。

彼らは、最初これを利用して計算を行おうとしたが、当時の高性能コンピュータでさえ40,000個もの数字データ(240kビット)を扱う計算には荷が重すぎた。

そのコンピュータに積まれたメモリは4000語(18ビットで4kwords = 9kB )しかなく、今回の処理に最低限必要な記憶容量の 10分の1にも満たないものであった。

そこで彼らは、画像データの数値を磁気テープに全て移して、別棟にあるIBM科学計算用コンピュータ「7094」で処理しようと考え、マスコミの目を避けつつ密かにデータを運び込んだ。

IBM「7094」は、1962年に開発された最新鋭のコンピュータで当時300万ドル(日本円で11億円)相当のものであった。

このコンピュータは、SAGE(Semi Automatic Ground Environment: 半自動防空システム)開発のために作られた核分裂計算用スーパーコンピュータ「ストレッチ」の後継機であり、後に世界を席巻するIBM「システム360」のパイロットともいうべきコンピュータであった。

当時、このコンピュータは最大級の大型コンピュータであり、大きな一次記憶装置を備えていた。しかも、アセンブリ言語という機械本位のプログラム言語しか使えない「PDP-4」と違って、当時、科学技術分野で広く使われていたFORTRANという人間が使う日常語に近いプログラム言語を使うこともできた。

ラボー氏が見つけた画像処理法は、瞬く間にFORTRANを使った「7094」コンピュータで走るプログラムに書き直された。画像処理のプログラムはIBM「7094」に転写され、マリナー4号からのデータが入力され解析処理された。

IBM 7094が当時最高性能だったとは言え、コンピュータは磁気テープによって起動するもの(今のようなハードディスクドライブではない)であり、データを入れるのも磁気テープを使った。これでも当時のパンチカード方式(max. 12ビットx80 = 960ビット/枚、読み取り速度10枚/秒)に比べれば、格段に大容量で超高速であった。しかし、高性能と言っても、今のパソコンに比べてさえも、その処理能力は「うさぎと亀」に等しいものであった。

● 火星の全貌の解明

最初の写真がやっと良い画質になったとき、彼らが目を凝らして見ていた画像は火星の先端(地平線)であったことがはっきりした。マリナー4号からは画像が次々と送られてきていた。最初の三枚を受信してから三日後に報道関係者に火星の画像を公開した。ある画像には月面にそっくりなクレータが写っていた。大昔にできたクレータが現在まで現存するということは、火星にはそれを風化させたり浸食させたりする水も気体もなかったということを物語っていた。それこそが世紀の大発見であった。

注意しなければならないのは、マリナー4号が送ってきた写真は、火星の表面のほんの一部分だけをカバーしたただけで、火星の全容を写しだしたものではないことである。

後の1971年〜72年には、改良の進んだ高性能カメラ搭載の観測機が火星の軌道に乗り、それまでとは全く違った火星表面を撮影し送ってきた。

それは、月の表面とは全く異なった地表であった。太陽系の中で最も大きな火山の発見もした。

また、太古の洪水で切り開かれた海峡らしき地形も発見し、極地では何百万年にもわたる気候の変化を暗示するような堆積層も発見した。

- 参考文献: 「新・電子立国 6巻 コンピュータ地球網」 相沢 洋、矢吹 寿秀、1997.3.20初版、日本放送協会

画像処理の基本。元画像のバックグランドにノイズが多いとき、バックグランドの平均値を全画素に渡って差し引く。1965年に、JPL(NASA研究機関)が最初に行った画像処理がこの処理であった。彼らはまた、バックグランドを差し引いたあと、コントラストを上げるために全画素に渡って1.6を乗じている。

このように、画像処理は、画素単位での数値演算処理が基本となる。二値化も色つけも、スムージングも、エッジエンハンスもすべて上記の手法(画像演算処理)が基本的な流れとなる。

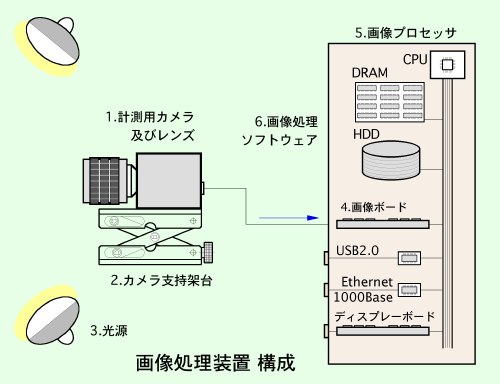

■ 画像処理の流れと構成

▲ 機器構成 :

画像処理を前提とした画像計測システムは、以下の構成品で成り立っている。

1. 計測カメラ及びレンズ(高速度カメラ、

高精度カメラ、 顕微鏡、テレセントリ

ックレンズ、等)

計測カメラは、一般のデジタルカメラでも使用することができる。しかし、そうしたカメラから計測データを抽出する場合には、誤差の出ないようにカメラとレンズの性能を十分に考慮しなければならない。例えば、カメラは計測に耐えるだけの濃度情報を持つものが必要であるとか、露出時間が正しく制御できるものであるとか、タイミング良く画像が得られる機能を持つものであるとか、レンズの歪みが十分にとれているか等を知っておく必要がある。

(参考URL 光と光の記録 - 記録編 )

2. カメラ支持架台(三脚、ジャイロ、

3軸ステージ)

カメラを固定する台座は、しっかりとして強固なものでなければならない。振動などでカメラが揺動すると計測に影響する。

拡大撮影では倍率が高くなるので撮影画像の揺れが特に大きくなる。

必要に応じてカメラ位置を微調整する光学微動ステージが使われる。

3. 光源(太陽光、LED、キセノンストロボ、レーザ、等)

光源は、短時間露光での撮影にパルス光源を使用したり、高輝度光源を使用する。

また、ライトシートによる流れの可視化撮影を行う場合にはレーザ光を使う。

光源は、画像計測の役割が大きい大切な計測装置の要素である。

(参考URL 光と光の記録 - 光編 )

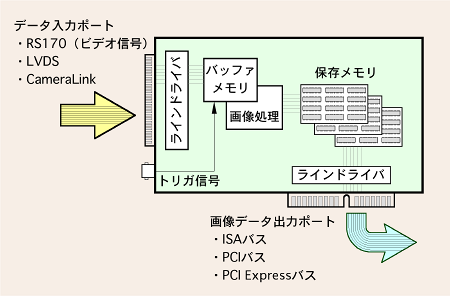

4. 画像取り込み装置(画像ボード、Image Capture Board)

画像ボードは、計測カメラから送られてくる画像データをコンピュータに取り込む仲立ちをするためのもの、すなわちインターフェースである。

画像ボードは、通常デスクトップの拡張ボードに差し込んで使われる。

ノートパソコンを使う場合は、PCMCIAカード型のボードを差し込んで使う。

ノートパソコンはコンパクトで使い勝手が良い反面、バスの転送能力が低くボード(カード)の種類が少ない。

最近は、コンピュータ標準のインターフェース、例えば、イーサネットやUSB2.0、IEE1394などを介してカメラからの画像データを取り込む方式も増えている。この場合、画像ボードは必要とせずコンピュータのイーサネットやUSB2.0に直接接続する。

一般のデジタルカメラ、ムービーカメラはこの方式に属している。

カメラ画像データは、高速かつ大容量であるので、2000年頃までは一般のコンピュータインタフェース(RS232Cやプリンタボート、10Baseイーサネットなど)を使って取り込むことはできなかった。

従って、この時代までは画像ボードの働きは非常に大切で、カメラ画像データはこのボードを介して取り込まれていた。

デジタル画像がコンピュータに取り込めなかった時代は、アナログ信号をデジタル画像ファイルに変換する画像ボードが使われた。

画像ボードの利点は、大容量の画像データを効率よくパソコンに取り込めることである。

例えば640x480画素、30コマ/秒の画像データは、基本的に73.73Mビット/秒のデータである。

カラー画像の場合は、3倍の221.2Mビット/秒となる。

このように普通の映像データでさえも非常に大量のデータ転送を要求する。

これを逐次処理して画像フォーマットとしてコンピュータに保存するためには、CPU、コンピュータバス、圧縮画像フォーマットなどの各要素に高速化のための技術革新を必要とした。

画像ボードは、大量に送られてくる画像データのコンピュータ中枢部への橋渡しをする介在役を果たしている。

その橋渡しとしては、画像データを画像ボードで圧縮してJPEG画像に変換したり、メモリを搭載して一時的に画像を蓄える機能も含まれる。

上の図に、画像ボードの基本的機能を示す。この図は、外部から画像データ信号を取り入れて内部で必要な処理を行いコンピュータバスにデータを出力する流れを示している。

画像の入力は、1940年代から使われているアナログ信号(RS170信号)であったり、1994年に規格化された高速データ通信ができる低電圧差動信号(LVDS)であったりする。2000年以降カメラ専用のカメラリンク信号(CameraLink)も使われている。

入力信号の違いは時代を反映したもので、高速通信に伴いいろいろなデータ通信規格が決められてきた。

・RS170信号: アナログビデオ信号。640x480画素相当、30フレーム/秒(29.97フレーム/秒)の画像を扱う。

・LVDS信号: デジタル信号。ツイストペアの信号線で、電圧が0.3V程度と低い信号。

消費電力が少なく高速通信が可能。655Mビット/秒の転送速度を持つ。

・CameraLink: デジタル信号。LVDSをカメラデータ用に規格したパラレル信号。1.93Gビット/秒の転送速度を持つ。

カメラから送られてくる画像データ信号は、画像ボードによって画像ファイルに整える処理変換を行う。

多くの場合、ボードにはバッファメモリが搭載されていて、外部からのトリガ信号が入ると一枚の画像分を整えて出力することができる。

この機能は、現象とのタイミング、例えばストロボ光源との同期や、欲しいタイミングで一枚の画像を得るのに便利であった。

トリガ機能のないボードは、コンピュータ内部の指令信号、もしくは垂れ流しで画像をコンピュータ上位部(RAM領域)に作ることになるので、画像の取得タイミングが正確でなくなる。

従って、時間精度の良い画像データの取得は期待できない。画像ボードによっては、メモリ搭載のないものもあり、こうしたボードでは画像データをバッファとして蓄える機能がないので、直接コンピュータバスに画像ファイルを渡すことになる。

必然的に、データの転送性能はコンピュータに依存することになり、コンピュータバスの性能、コンピュータのCPUクロック、DRAMの性能、HDDの性能に左右されることになる。

画像ボードによっては、ボード上で二値化処理や形状の判断処理を行う画像処理機能を搭載したインテリジェントボードもある。

画像ボードによって整えられた画像データは、コンピュータバスを介して画像処理ソフトウェアが待つコンピュータRAMに伝送されたり、保存のためにHDDに転送される。

コンピュータバスも画像ボードの性能を左右する大きな規格であった。この規格もパソコンの初期のISAバスからPCI Expressバスまで進化した。

・ISAバス(Industrial Standard Architecture bus):

1984年、米国IBM社がPC/ATと呼ばれる業界標準のパーソナルコンピュータを発表した。

その時のコンピュータバスの規格であった。この標準バスは、2001年頃に使命を終えた。

ISAバスは、転送速度が8Mバイト/秒と低く、画像を扱うには遅すぎた。

・PCIバス(Peripheral Components Interconnect bus):

ISAバスのデータ通信に限界がでてきたために、インテル社が中心となって開発した

コンピュータバス規格である。1992年に制定された。

転送速度は、133Mバイト/秒(32ビット)、266Mバイト/秒(64ビット)であり、

ISAバスと比べて16倍〜32倍の高速通信が可能になった。長らくパソコンの標準バス規格となった。

・PCI Express(PCIe)バス:

2002年にPCI SIG(Industrial Standard Architecture Special Interest Group、

インテル、IBM、マイクロソフト、AMD、NVDIA、他900社)によって策定された高速コンピュータバス。

2005年頃よりこの規格をサポートするコンピュータが出始めて普及するようになった。

このバスを必要としたのは、高速で高画素の画像表示を行うビデオ表示ボードであった。

また、ギガイーサネットやUSB2.0、IEE1394などの高速通信ポートが出現し、コンピュータバスにも

高速バスに対する要求が高まった。

このボードは、転送速度は5Gbps(5Gビット/秒)で、従来のPCIバスの3倍〜4倍の速度を確保できる。

5. 画像処理装置(Windows/Macintosh)

取り込んだ画像を保存し、再生、変換保存、画像処理を行う処理装置である。

従来は、専用の処理装置が使われていたが、コンピュータの性能向上と共に扱いやすいパーソナルコンピュータでの使用が増え、Windows、Macintoshなどが使われている。

UNIXが得意なユーザでは、Linuxなどのコンピュータを使って画像処理システムを構築するケースもある。

6. 画像処理ソフトウェア

画像演算を行うソフトウェア。代表的なものを別にあらためて紹介 する。

▲ 画像ファイル:

計測カメラを使って取り込む画像(動画像)は、一般的なソフトトウェアで読み出せるファイルフォーマットでなければならない。

画像のデジタル化は、1980年代後半から盛んになった。

それ以前は、写真による保管が主流であり、フィルムや紙焼き、マイクロフィルムなどで保管していた。

当時の画像解析は、写真を拡大してそれにスケールを当てて位置情報を読み込んでいた。

宇宙開発やリモートセンシング分野では、1960年代から画像をコンピュータに保存する技術が進められ、専用のスキャナーで画像を読み込み大型ワークステーションでデータを保存していた。

この時の画像データファイルは、独自のものであった。独自と言っても画素の番地と濃度情報をそのまま記述していくRAWファイル(RAWは「生」が原義)であった。

ビデオ画像は、1970年代から2000年までの30年間は放送で使われているNTSCと呼ばれるアナログビデオ信号が主流であった。

デジタル画像は、1980年終わり頃から使われるようになり、デジタル画像フォーマットが確立されるようになって画像データの保管と受け渡しが楽になった。

1990年代は、フィルム画像をデジタル画像に変換するフィルムスキャナーが発達した。

TIFFと呼ばれる画像ファイルはスキャナーの画像ファイルとして作られた。

2000年以降デジタルカメラが普及しフィルムスキャナーの需要は下火になっていく。

画像ファイルは、いろいろのフォーマットが考案されてきたが、淘汰により現在では、JPEG、PNG、TIFF、BMP、AVIなどが計測分野でよく使われる画像フォーマットとなっている。

これらデジタル画像は、2000年あたりから一般的になって広く使われるようになった。

これは、2000年あたりよりデータ通信速度が向上し、記録メディア容量が飛躍的に向上し、さらにコンピュータの処理能力も向上してデジタル処理が楽になったからである。

画像ファイルの詳細は、

光と光の記録 - 記録編 ■画像の保存(http://www.anfoworld.com/Recordings.html#fileformat) に譲ることにし、ここでは最も一般的な画像フォーマットの紹介にとどめることにする。

【静止画像】

■ BMP /DIB(びぃえむぴぃ・でぃあいびぃ、Bit Map File/ Device Independent Bitmap)

マイクロソフト社が開発した最も基本的な画像フォーマットである。

ビットマップピクチャの略。

MS-DOSの時代(1980年中盤)以降から使われ出した。

味も素っ気もないシンプルなフォーマットであるが、OSがサポートしているのでシンプルな画像処理を行うのには都合が良く現在でも使われている。

ただし、画像ファイルは画素分と色情報分がそのままデータ量になるので大きなファイル量となる。例えば、1024x1024画素でカラーの場合 、

1024x1024x3 = 3.15MB

3.15MBのファイル容量となる。1.4MBのFDD(フロッピーディスク)が標準だった頃の1990年代中頃までは、このようなデータは扱うことが困難であったため、当時の多くは640x480画素(VGA) = 921KB以下の画像を使っていた。

■ TIFF(てぃふ、Tagged Image File Format)

汎用性が高くて使い勝手がよく、MS-DOSに標準サポートをするようになったので画像ファイルの標準となった。

TIFFは、1986年に開発された。

TIFFは、スキャナーから読み取られる画像の保存フォーマットとして開発された。

開発当時は多くの方言があり、互換性の問題があったが現在では解決をみて互換性の高いファイルフォーマットになっている。

TIFFは、画像にデータ(カメラデータ、日時、計測データなど)が埋め込めるため、また16ビット濃度にも対応していたため、計測用と画像ファイルとして重宝されている。

また、一連のTIFF画像を一つのファイルとしてまとめる機能もあり(concatenated TIFF)、計測分野で使われた。

TIFFは、圧縮フォーマットも開発されたが、基本的には非圧縮なのでBMPファイルファイル容量は変わらない。

■ JPEG(じぇいぺぐ、Joint Photographic Experts Group)

上記の画像ファイルが大容量になるので、圧縮を用いた画像ファイルが提唱された。

JPEGと呼ばれる非可逆圧縮フォーマットは、写真画像を圧縮保存するために開発された。

JPEGを開発した組織は、非営利団体組織で1986年に作られた。

6年の制定準備期間を経て1992年にJPEGフォーマットが作られた。

現在、多くのデジタルカメラの標準フォーマットとして採用され、インターネットの画像としても多く利用されている。

JPEGの利点は、写真などのような細かい情報の圧縮に効果が高いことである。

欠点は、非可逆圧縮であるため圧縮率を高くした画質の悪い画像ファイルを元に戻すことが不可能であることや、図形などの線画に対してノイズ(モスキートノイズ)が出やすいことである。

■ PNG(ぴぃえぬじぃ、ぴんぐ、Portable Network Graphics)

PNGフォーマットは、1994年に開発された。

JPEGの非可逆圧縮と異なり可逆圧縮なので画質の劣化がない。

その分圧縮率が悪く、写真画像などではJPEGの方が圧縮に対する画質効果が高い。

しかし、図形や単純な写真、文字画像などはJPEGよりははるかに圧縮が高く画質も綺麗である。

JPEG画像は原理的に原画像の1/64の圧縮が限界であるが、PNGはそれ以下で圧縮することができる。

この画像ファイルは、1987年に開発され一斉を風靡したGIFファイルの後継フォーマットである。

GIFファイルが著作権があったので、自由に使えるフォーマットを策定し1994年に制定した。

それがPNGファイルである。

Bayerフォーマットは、カラー画像の原画像フォーマットである。

通常のカラー画像は、RGBの三色に分かれてそれぞれ8ビットの濃度を持っているので、画像サイズが白黒画像の3倍になる。

Bayerフォーマットでは、一枚の画像だけを使ってそこにRGBの市松状のパターンを配置し、色情報を近傍の画素から拾い上げて構築するという方式をとっている。

この方式によって、デジタルカメラも1枚の固体撮像素子でカラー画像が得られるようになる。

RGB別々の素子で撮影してRGBで記録する方式の方が画質的には最もすぐれたものとなるが、Bayer方式の方が簡便である。

米国コダック研究所のBayer博士が開発したのでこの名前がある。

コダックの特許が切れた1993年にデジタルカメラメーカーがこぞって採用するようになり一般的なフォーマットとなった。

生データの画像ファイルである。

多くの場合、デジタルカラーカメラからの画像情報をそのまま保存することを言う。

デジタルカメラがBayerフォーマットの撮像素子で作られているのでBayerフォーマットと言えなくもない 。

海外のメーカーは、Bayerという言葉を使うのにあまり抵抗がないが、日本のメーカーはBayerという言葉を使うのに神経質で、強いて使おうとしない。

特許が絡むことは避けたいとする必要以上の神経質な体質があるのであろうか。

それはさておき、RAWデータはBayerフォーマットの画像にカメラデータを入れ込んだものである。

デジタル一眼レフカメラでは、RAWファイルとJPEGファイルのいずれかで画像保存できるようになっている。

RAWファイルで保存した場合、これを再生するにはメーカが作った専用のビュアが必要になる。

専用のビュアを使って再生し、必要に応じて別の画像ファイルフォーマットに変換保存できるようになっている。

RAWフォーマットは、JPEGフォーマットに比べファイル容量は大きい。

TIFFファイルなどに比べれば1/3以下ではあるものの、なぜ容量の大きいRAWデータが使われているかというと、

プロカメラマンは、画像をポストプロセッシング(後処理)したい要求が強くあるからである。

JPEGは非可逆圧縮なので一度保存した二度と元には戻らない。

また、多くの一眼レフデジタルカメラは、各色12ビットのデータを持っている。

これをJPEGに変換してしまうのは惜しいという理由でRAWを選ぶことが多い。

プロカメラマンは、RAWファイルを「未現像」画像と言っている。

画像処理のことを「現像」という。フィルムカメラを愛用してきた人たちならではの表現である。

【動画像】 (2012.10.21追記)

■ AVI(えいぶいあい、Audio Video Interleaved Format)

AVIは、マイクロソフト社がWindowsOS用に開発した初期の動画ファイルフォーマットである。

BMP静止画ファイルを連番付け(ストリーミング)してそれに音声を加えた(インターリーブ)フォーマットがAVIである。

このフォーマットは、1992年に開発されたものの、5年後の1997年にサポートを中止してしまった。

従って、かなり古い規格フォーマットということになる。

古い規格でありながら、2012年の時点でも計測分野ではよく使われている。

なぜ現在も使われているのかと言えば、このフォーマットが非常に簡単でありしかも使いやすいからである。

多くのユーザが動画を入れる箱のように使っている。

箱にはいろいろな圧縮のコーディング(coding)が組み込まれファイル容量を少なくすることができる。

古い規格であるため、2GB以上の容量をもつものは再生ができない。

【AVIとWindows7】

計測分野では良く使われるAVI動画ファイルではあるものの、一般的には死滅したものであり一般的にはほとんど使われることはなくなった。

AVIは、64ビットWinodws7では見ることも作成することもできなくなった。

ただ、OSに組み込まれているMediaPlayerでは旧来のAVI動画ファイルを再生することができる。

その理由はMediaPlayerの中にAVIを再生するためのドライバーが組み込まれているからである。

しかし、64ビット対応のdll(Dynamic Link Library)ドライバーが開発されていないため、64ビットWindows7では解析ソフトでこのファイルに対応することは不可能である。

計測カメラ用の操作ソフトウェアや解析ソフトウェアでは64ビットWindows7でAVIファイルを扱うことはできなくなった。

従って、今後、計測用として動画ファイルを扱う場合は、AVIを使わない方向に向かうものと思われる。

その代替えファイルは、連番によるPNGファイル、連番によるJPEGファイルである。

MPEGファイルを採用する場合には、解析時に保存したMPEGファイルを解析できるように連番のTIFFファイルかPNGファイルに中間ファイルを作成する必要がある。

MPEGをそのまま解析することは困難である。困難である理由は下記のMPEGの項目で触れる。

【AVIとコーデック】

AVIはほとんどの場合、圧縮のためのコーデック(Codec)を使用している。

このコーデックがあるために、 2012年にあっても計測分野でAVIが使われていると言っても過言ではない。

コーデックは、CompressionDecompressionの意味で圧縮・解凍の意味である。

AVIは、構造がシンプルで入れ子の意味合いを持つ。その入れ子の中に様々な圧縮コーデックを入れた。

コーデックにはIndeoR5が最もよく使われた。

Indeoが有料になって圧縮効率も思うほど期待できなくなってからは、マイクロソフト社のVCM9が使われることが多くなった。

圧縮効率が良いコーデックはすべてMPEG技術を採用している。

MPEGそのものが解析に不適当であるのに、AVIのMPEGコーデックがなぜ問題がないのかと言えば、AVIのファイルを開けるときにすべての内容をRAM領域もしくはHDD領域に展開して、その画像を読み出して再生しているためである。

このためシステムのファイルメモリ限界である2GB以上のAVIファイルは読み出せない不具合が生じることになるのであるが、再生と解析では確実な方法である。

MPEG画像は2時間の動画を保存し、それを連続して再生することが主目的であるため、ファイルを開くときすべてをメモリ領域に展開することはしない。

■ WMV(だぶりゅえむぶい、Windows Media Video)

マイクロソフト社がAVIの後継として採用している動画像フォーマットである。

2GB以上のファイルを扱えることや、MPEGの圧縮技術を使えるメリットがある。

WindowsのOSが正式にサポートしているため、Windows MediaPlayerでは標準のファイルフォーマットである。

しかし、計測分野ではあまり用いられていない。

WMVファイルは、マイクロソフト社が独自に開発した専用のMPEG(画像補間方式の圧縮技術

= 一枚一枚静止画として画像を保存していない)ファイルフォーマットである。

一般的に、MPEG動画像はスロー再生や逆転再生、1コマ送りや逆送りすることが難しい。

1コマ毎の画像計測を行う場合、連続した静止画像を持たないMPEG画像は計測が不安定に

なりやすいため、画像計測では敬遠される画像フォーマットである。

■ MPEG(えむぺぐ、Motion Picture Expert Group)

高画質で圧縮率が高いことから、映画用の動画フォーマットやインターネットの動画配信用のファイルフォーマットして普及している。

計測用としては、まだ十分に認知されていない。

その理由は、この動画フォーマットが全ての画像にわたり情報を記録するタイプではなく、画像の間引きを行い、間引いた画像は前後の画像で補間する方式をとっているためである。

また、AVIのように、すべての画像を一旦RAMメモリはハードディスクに展開して再生を行う方法を取っていないために、

都度一定の枚数を解凍して再生する方式なので逆転再生や、コマ送り再生が苦手である。

MPEGは、ファイルの圧縮が高く映画などをDVDに変換保存するのに都合がよい反面、計測用画像処理には不向きである。

不向きである理由は、計測画像処理では画像を一枚一枚吟味したり、認知のフレームを停止させたり逆転再生させることが多いのに MPEG画像ではそのような使われ方を想定していないためである。

画像処理用として採用するには慎重な吟味が必要である。

アップル社が開発した統合ファイルフォーマットである。拡張子は、.movもしくは、.qt。

静止画も扱えるが動画像ファイルフォーマットや音楽ファイルとしての位置づけが強い。

2000年以降、アップル社の開発したiPod、iPadの成功で、QuickTimeの知名度が向上した。

QuickTime 7では、マイクロソフト社の開発したAVIファイル、WMVファイルが再生できたり、

有料(3,400円程度)で購入するQuickTime7を使うと、TIFFファイルやJPEGの連番ファイルに変換保存することができる。

マッキントッシュが強い生物分野、広告分野、映画分野でよく使われている。

インターネットの動画配信においてもストリーミング技術が優れ画質も良いので良く使われる。

現在のQuickTime(2005年でQuickTime7)は、MPEG4に加えH.264/AVCを標準フォーマットにしているため互換性が高い。

MPEG4で保存したQuickTime画像は、MPEG画像同様解析には注意が必要である。

■ 代表的な画像処理ソフトウェア(Image Data Processing Software)

以下に示すソフトウェアは、計測分野で使われている代表的な画像処理ソフトウェアである。

これらのソフトウェアは、基本的に専用画像ボードや専用のカメラ、画像プロセッサを必要としない一般的な画像ファイルを処理するものである。 画像処理ソフトウェアは、以下に挙げたもの以外に非常にたくさんの種類が開発されている。

計測分野以外にも、広告宣伝分野に使われているものや、映画製作で使われるレタッチソフトやレンダリングソフトもたくさんある。 時間があればそれらのソフトウェアにも触れて行きたいと考えている。

■ 一般的なレタッチソフト - Photoshop(フォトショップ) (Macintosh/Windows) (2011.11.04追記)

フォトショップのロゴ。

左側が初期の頃のロゴで、右側がPhotoShop CSになってからのもの。

「PhotoShop」は、米国Adobe社が開発を続けている画像レタッチソフトウェアである。

左のロゴは、ver.6までのものであるが、PhotoShop CSとなってからは右側のものになった。

PhotoShopは、2003年からPhotoShop CSという名前になった。CSはCreative Suitesの略である。

2003年のPhotoShop CS ver.1は、PhotoShop ver.8に相当する。

2010年には、PhotoShop CS5(Photoshop ver.12.0)となった。

【歴史】

「PhotoShop」は、1990年にマッキントッシュ用としてバージョン1.0がリリースされ、2007年現在、バージョン10になった。

フォトショップは、写真撮影を生業とするスタジオや広告制作業界に圧倒的支持を得て、マッキントッシュのキラーソフトとなった。

フォトショップは、1987年、米国ミシガン大学の博士課程の学生だったThomas Knollが書き上げたコードが母体となっている。

彼は、自分の持っていたMacintosh Plusで白黒画像を表示させるためにコードを書き上げた。

当時、コンピュータの画面表示は文字の羅列が一般的であり、現在のように図や写真、動画などを表示する機能は標準で装備されていなかった。

当時は、Macintoshがいち早く画像表示ができるパソコンを発売していた。Thomas Knollは、マッキントッシュのビットマップ表示ができるグラフィック描画に着目して画像を表示するソフトを完成させたのである。そのソフトは、「Display」と名づけられた。

このソフトを見た弟のJohn Knoll(1962 〜)は、その出来具合に注目した。彼は、当時ILM社 = Industrial Light and Magic に勤務していた。ILM社は、映画「Star Wars」で有名になったジョージ・ルーカスが設立したデジタル効果処理の会社で、1990年代のスター・ウォーズ作品を多く手がけたことで有名である。彼もデジタル画像を扱う世界で働いていたのである。彼は、兄の作ったソフトを母体として、いろいろなファイルを扱ったり画像処理ができるサブソフトウェアを追加し、それらを母体に関連づけてつり下げるという手法を考え出した。これが「Plug-In」と呼ばれるソフトモジュールである。

その中にアップル社とアドビ社があった。

アドビ社は、このソフトウェアを大いに気に入り1988年に販売契約をKnoll兄弟と結んだ。

【特徴 - 操作性】

PhotoShopの特徴は、操作性の容易さであった。

操作性の容易さはマッキントッシュの大きな特徴であったが、PhotoShopはその性能をいかんなく発揮して使いやすい画像処理ソフトを構築した。

右に示す操作メニューは、すべてアイコン方式として操作者が何を行いたいかが直感的にわかるようになっている。

この操作アイコンは、1990年の開発当初から20年が経った今日まで大きく変わっていない。

【特徴 - プラグイン機能とレイヤー機能】

フォトショップの大きな特徴は、プラグイン機能とレイヤー機能である。

プラグイン機能は、先にも紹介したが周辺機器とフォトショップを橋渡しするソフトウェアのサブモジュールである。

例えば、あるデジタルカメラをコンピュータで使う場合、フォトショップのプラグインフォルダにカメラのドライバー(プライグイン)を入れておけば、フォトショップとそのデジタルカメラは関連づけられてフォトショップからデジタルカメラを操作できるようになっていた。

もちろん、スキャナーもプラグインによってフォトショップと連動し、スキャナーで取り込んだ画像はフォトショップで表示され、明るさやコントラスト、色補正、シャープネス補正などをその場で処理できた。

Photoshopが世界的に認知される大きな転機はバージョン3で表れる。

このバージョンになって初めて「レイヤー機能」が登場した。レイヤー機能とは、画像を何枚も重ね合わせる機能である。

この機能を使えば、カラー画像の4色分解や、源画像の上に文字を重ね合わせたり別の画像を重ね合わせることも簡単にできるようになる。

この機能によってフォトショップの名声は高まり不動の地位を築いていくことになる。

【Photoshopの機能】

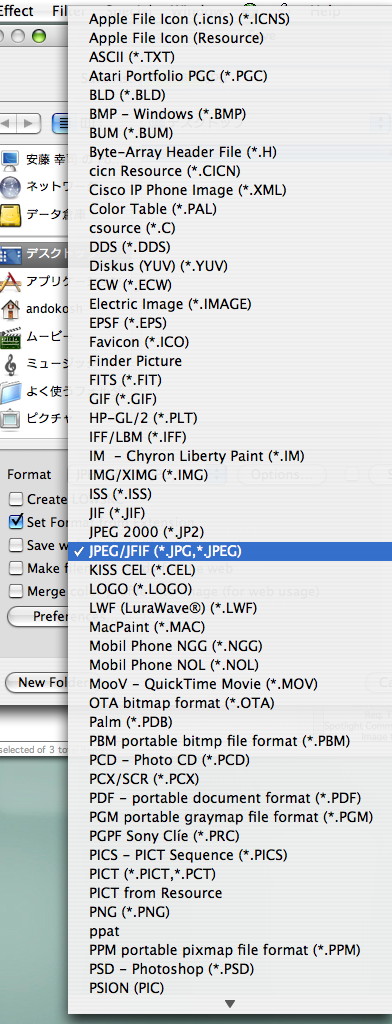

■ 画像フォーマット変換

PhotoShopが重宝された特徴の一つに、ほとんどの画像フォーマットに対応して画像を開くことができ、必要に応じて他の画像ファイルフォーマットに変換保存できる機能があった。

■ 画像サイズ変換

PhotoShopでは、画像サイズを任意の大きさに変換することができた。

■ レタッチ

レタッチとは、1画素単位で色を変更することができる機能である。

■ 歪み補正

■ 無料レタッチソフト - Paint(ペイント) (Windows)

無料であるためその機能は必要最低限となっている。 すなわち、Paintができる機能は基本的な画像フォーマットファイルを読み込むことであり、その他に画像を切り出したり、 別のフォーマットに変換保存することができる。

Windowsに組み込まれているので、世の中で一番使われている画像処理ソフトウェアと思われる。

このソフトの使われ方は、以下の通りである。

・一般的な画像の読み出し。

・画像の拡大、縮小表示。

・画像の切り出し。

・画像ファイルの変換保存。

(BMP、TIFF、JPEG、GIF、PNG)

・画像の修復 = レタッチ。画素単位で色を加筆修正することが可能。

・注釈文字の入れ込みが可能。 ・不必要な画像のマスキングが可能。

フォトショップに比べると機能は、非常に限定されている。

■ 最もよく使われている汎用画像処理ソフト - Image Pro Plus(イメージプロプラス) (Windows/Macintosh)

多くの競合製品があった中で、2007年現在まで続いてきた強力なソフトウェアである。

2011年現在、バージョンは7である。 PhotoShopが、画像の仕上げをするのに使われるのに対し、Image Pro Plusは学術研究用途に使われ、粒子計測や顕微鏡画像の濃度処理、色合成、電気泳動の解析、X線スライス画像の立体構築、噴霧計測などに利用されてきた。 主な機能は以下の通り。(フォトショップとは異なる機能を列挙)

▲ 画像濃度: 16ビット濃度(65,000階調)を持つ画像を扱える。(カラーは16ビット x 3 = 48ビット) フォトショップは、8ビット(256階調)のみ。(カラーは8x3 = 24ビット) ▲ 扱える画像ファイル: TIFF、IPW(Image Pro Plus Workspace形式)、JPEG、JPEG2000、GIF、TGA、BMP、

PhotoCD、PICT、CUT、PCX、GEL、PCT、IPS、RAW、FITS、Flat(ユーザ定義バイナリ形式)、

EPS(ポストスクリプト形式)、ICS(ニコンC1画像)、STK(メタモーフスタック)、

LSM(ツァイス共焦点画像)、LEI(ライカ共焦点画像)。

AVI(動画像)、SEQ(Image Pro Plusの動画像)。

▲ シーケンス画像: 動画像の読み込み、再生、作成、編集

▲ 疑似カラー表示: 濃度に応じた色づけができる。連番の画像を動画として表示できる。動画ファイル(AVIファイル)を解析できる。

▲ プロファイル: ラインプロファイル、ヒストグラム表示ができる。

▲ 高速フーリエ変換: 周波数の高い(低い)画像のフィルタリング処理が可能。

▲ 濃度処理: 二値化処理。

▲ 粒子計測: 粒子の大きさ、頻度を計測できる。

▲ 寸法計測: 長さ計測、原点設定、角度計測ができる。

▲ 面積計測: 濃度に応じた面積計算。

▲ データ出力: エクセル出力。

▲ 3Dイメージング: 顕微鏡画像、CT画像のZ軸方向のスタック画像処理。

■ 高度なフリーウェア画像処理ソフト - ImageJ(イメージジェイ) (Macintosh/Windows)

ImageJは、計測用に作られたフリーウェアの画像処理ソフトウェアである。 医学研究用の画像処理ソフト、特に顕微鏡で撮影した画像の処理を行うことを目的として作られた。

ImageJの前身は、NIH Image というフリーウェアの画像処理ソフトウェアである。

NIHは、 米国 National Institutes of Health(アメリカ国立衛生研究所)の略で、この医療機関に勤めている Wayne Rasband 氏がマッキントッシュを使って医療用の画像処理ソフトを開発したのでこの名前がついている。

最初のバージョンがいつリリースされたのかは定かでないが、私がマッキントッシュを使い出した頃にはすでに登場していたから、1993年頃と思われる。 このソフトウェアは、医学関係に大いに普及した。また、インターネットの普及で工学分野にも認められるようになり多くの研究者が恩恵にあずかっている。

このソフトウェアは、1999年、米国の画像ボードメーカScion社がWindows用にコーディングしなおして、フリーウェア「Scion Image」としてインターネットで紹介した。以後、Windows用にも広く普及するようになる。

ImageJは、上記のNIH ImageのJavaスクリプト版で1997年にリリースされた。Javaでソフトを作ることにより、使用するコンピュータのOSを気にすることなくほぼ同じ環境で使用できるようになった。 またボランティアによって取扱説明書が作られたり、プラグインソフトが作られてインターネット上で紹介されるようになり根強い人気を持っている。

学術用には優れた機能を持っており、さまざまな分野がこのソフトウェアの恩恵にあずかっている。

私が知るカメラメーカでは、カメラのシェーディング検査や温度特性検査にこのソフトを使っている。

生物関係の大学研究室でも有名なソフトで、学生達が研究の一環としてこのソフトを使いこなす勉強会を開いている。

これらの事例は、このソフトが何よりもフリーウェアだからということである。

ソフトウェア自体のバグ修正や追加ソフトのリクエストには十分な対応が計れないにしても、このソフトを母体としていろいろなモジュールを開発している大学研究機関も多い。

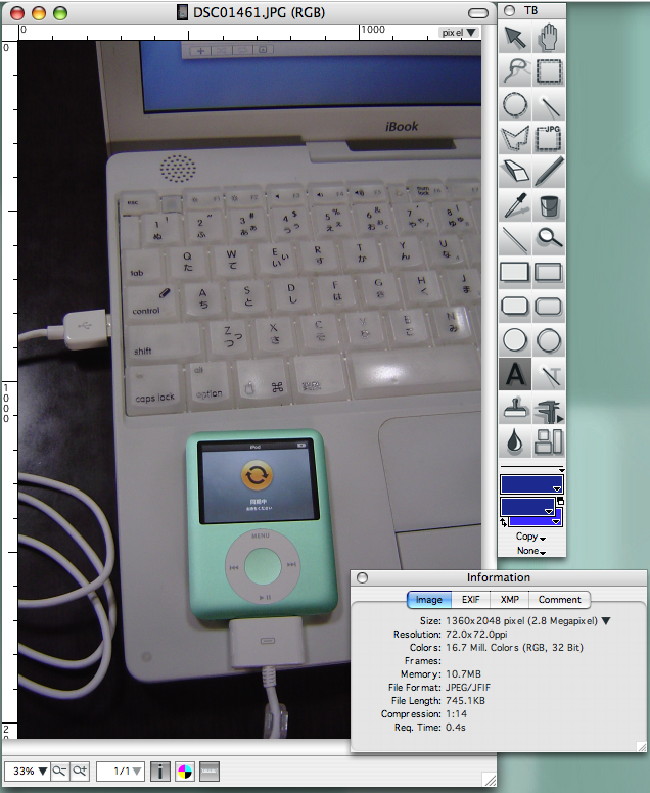

■ ファイル変換ソフト(シェアウェア) - GraphicConverter(グラフィックコンバータ) (Macintosh) (2007.09.17追記)(2011.11.04追記)

GraphicConverterのロゴ

ver7.0(2011年)から右のロゴに変わった。

GraphicConverterは、ドイツ人Thorsten Lemke氏がマッキントッシュ用に開発を続けている画像変換ソフトウェアである。

価格は、4,000円程度と安価である。PhotoShop CSが10万円程度するので、これに手が届かないユーザにはありがたいソフトウェアである。

このソフトウェアの大きな特徴は、さまざまな画像ファイルの閲覧とファイルの保存管理である。

ほとんどすべての画像ファイルを開けることができ、開けた画像ファイルを任意の画像ファイルフォーマットに変換して保存することができる。 たくさんある画像を一覧する(ブラウズする)機能も充実している。

このソフトが開発されたのは、1992年。

当時、Lemke氏は、パソコンをAtariからMacintoshに買い換えた矢先で、それまで保存していたAtariの画像をMacに移植する必要に迫られた。

しかし、画像を変換するソフトウェアが無かったので、独自に画像変換ソフトを開発したという。 以後、2007年までの15年に渡り、150万本以上のソフトの供給を続けてきた。

バージョンは2011年現在でver.7.4。

GraphicConverterは、200種の画像フォーマットをサポートする。

画像変換のみならず、レタッチ処理、画像回転、画像縮小、動画付けができる。

デジタルカメラフォーマットにも対応し、デジタルカメラの撮影データ情報も読み出すことができる。

私自身、画像を扱うときには最も重宝して多用しているソフトウェアである。

私がこのソフトウェアに最初に出会って、Lemke氏にFAXで購入申し込みをしたのは1997年だったと記憶する。以来10年間愛用し続けている。

ver.7.0からは、Macintosh OSX 10.6(Snow Leopard)以降の対応となった。

GraphicConverterの特徴は以下の通り。

▲ 豊富な画像変換ツール:

特にデジカメの画像ファイルのサポートが充実していて、多くの画像とその情報を閲覧することができる。

使いやすいツールボックスを使って画像の拡大・縮小、画像の切り取り、画像サイズの設定(リサイズ)などができる。

QuickTimeやアニメGIFが使え動画を作ることができる。QuickTimeにAVIやFlash Video(.flv)のコーデックが入っていれば、これを利用してこれらの動画ファイルを見ることができる。

▲ 使いやすい「ブラウザ」画面 。

画像フォルダーの中身を一気に閲覧することができる。

▲ 充実した「スライドショー」

フォルダー内の画像を指定する大きさと時間間隔でスライド表示する。スライド表示された画像のファイル名とパス名も表示できる。

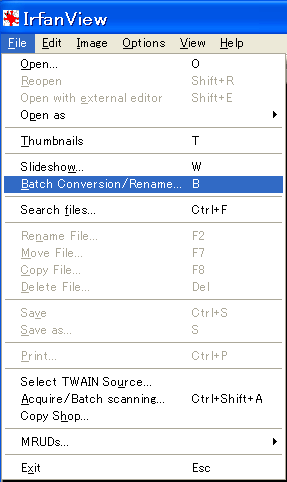

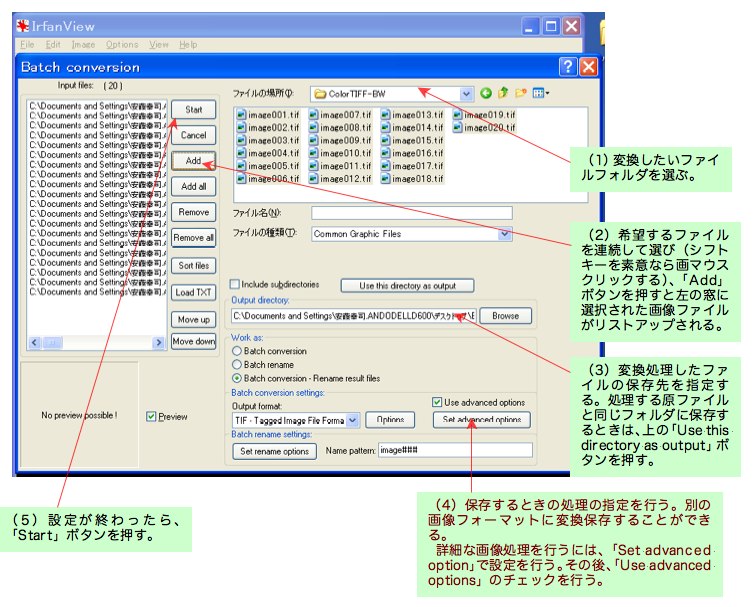

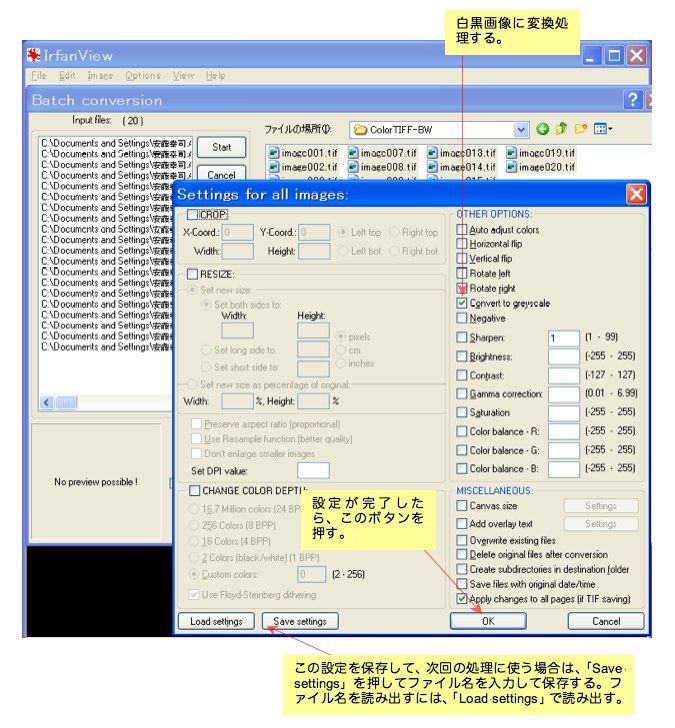

▲ 使いやすい一括変換機能(バッチ処理) 。

フォルダー内に納められた一連のBMPファイルをJPEGファイルに一括変換するというようなバッチ処理が可能。

▲ フォトショップに肉薄する画像効果処理 。

フォトショップには及ばないが、私が使う範囲の画像処理機能は十分に備えている。

レタッチ機能 - 画像で色が潰れた部分やゴミが付着した部分を修正することができる。

ガンマ補正 - 濃度階調の「硬さ」を調整する機能。 シャープ機能 - 画像強調機能。 ぼかし機能 - ガウス処理などのぼかし機能。 白補正 - ホワイトバランスが取れていないカラー画像の「白」補正機能。 赤目補正 - デジカメのストロボを使って人物を撮影すると瞳が赤く撮影されることがある。その赤目を画像処理によって修復する機能。 グリッド発生機能 - 画像内にグリッドを発生させて画面の傾きや構成のチェックを行うことができる。 画像フィルタ機能

画像回転・ミラー反転・斜め補正 明るさ・コントラスト機能

解像力変換 - 2000x2000画素相当で撮った画像を400x400画素相当に変換する機能。書類作成でそれほど解像度を要求しない画像を貼付する場合に使う。 アルファチャンネル機能 - 文字などを埋め込んだときに透明度を選択して重ね合わせ処理ができる。

■ メニュー (2007.09.17追記) グラフィックコンバータでは、以下に示すような オープンメニューが現れる。

このメニューでは、フォルダーの中にどんなタイプの画像が入っているかをサムネールメニュー(中央部のメニューエリア)で表示してくれるので、どのような画像が入っているかを一目で見ることができる。

サムネールメニューから希望する画像をクリックすると、右メニューエリアに詳細画像と詳細な画像情報が表示される。

上部のアイコンメニューは、指定した画像を正式に開けたり(Open)、ブラウザ画面(右エリア)の画像を回転させたり、指定したフォルダーの画像を連続して再生表示したりすることができる。

■ ターゲット自動読み取りソフトウェア - ViewPoint(ビュウポイント) (Windows) (2007.07.08) (2011.11.07追記)

「ViewPoint」は、対象物に貼り付けられたターゲットマークを動画像全般にわたって自動的に追尾(Tracking)し、追尾した移動情報から対象物の変位を計測する動画像ソフトウェアである。

このソフトウェアが使われている分野は、以下のとおりである。

・ 機械部品のキャリアの動き、金型部品の移動解析、携帯電話や

電動ドリルなどの落下安全試験。

・ 自動車安全試験(シート、ダッシュボード、ステアリング、

バンパー、サスペンション、ブレーキメカニズム、実車テスト、

エアバッグテスト)。

・ ロケット開発(衛星分離、機器の切り離し)。

・ 半導体製造プロセス(ハードディスクのアクセス挙動、

パーツインサータ、落下試験)。

・ スポーツ分野(バイオメカニクス)

陸上競技、球技(野球、サッカー)、格闘技(柔道、剣道、相撲)

運動選手の運動解析。

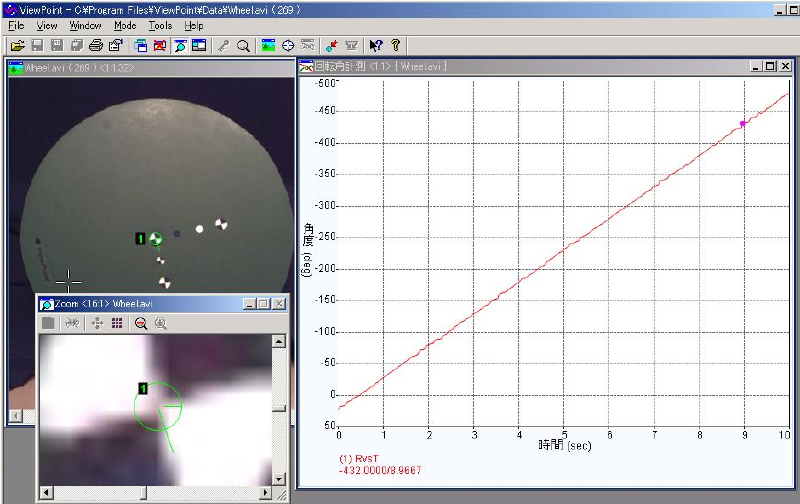

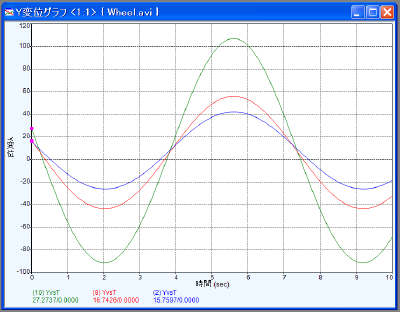

ViewPointの解析画面

左: 解析対象動画像、右: ターゲットポイントのグラフ

左下: ターゲットポイント1の拡大ウィンドウ

ViewPointは、特徴ポイント(ターゲットマーク)を自動検出して、検出位置をグラフ表示する。

グラフは動画像と同期して再生することが可能。

ViewPointは、米国Glenallan Technology社が2007年に開発した動画像自動トラッキングソフトウェアである。

このソフトウェアは、一枚の画像にスケールを当てて変位や角度を求める処理と違って、100枚から1,000枚以上にわたる映像(動画像、もしくは一連の静止画画像)の中の、興味ある物体の移動位置を自動的に追いかけるソフトウェアである。

このソフトウェアでは、トラッキングした情報から、物体の移動距離や、速度、機構部品の角度変化、角速度、振動数などを求めることができる。

トラッキングの条件が良いと、加速度成分まで抽出できるが、変位(トラッキングしたデータ)を2回微分することになるので、誤差成分を慎重に扱う必要がある。

【ターゲットマークトラッキングの歴史】

動画像のトラッキングソフトウェアの歴史は、1970年代前半に始まる。

当時、動画像を計測に使う研究分野は、限られていた。

1970年代の映画カメラや映画フィルムを使う高速度カメラは、何よりも撮影画像を見て判断するという「定性解析」が中心で、変位などの量を測る画像の「定量解析」は十分に行われていなかった。

■ フィルム画像によるトラッキング

フィルム画像を使って物体の変位を計測する手法は、地図作成などの写真測量で発展を見ていた。

映画撮影で得られた動画像を使って定量解析を行う写真計測を用いた計測分野は、ハイウェイ時代を迎えた自動車安全実験や、スポーツ解析分野(バイオメカニクス = Biomechanics)、それに軍需と宇宙開発分野で中心に行われていた。

軍用の研究では、第二次世界大戦以後、写真計測の役割(弾道研究、火器の性能試験)が急速に高まり、写真に写された物体の特徴点をターゲットとして拾い出し、これから位置情報を得て被写体の運動解析を行っていた。

こうしたターゲット抽出作業は、解析作業者の忍耐を要求し、ともすれば、忍耐の持続が続かず想定以上の測定誤差となった。

私にもこの経験がある。当時(1970年代後半)の動画像(映画フィルム)解析は、16mmフィルム画像を23倍にスクリーンに拡大投影して(スクリーン上で 230mm x 170mmの大きさに拡大)、映し出された画像にカーソルを当てて、ターゲットの位置情報を読み出していた。

一枚目の画像のポイント入力が終わると、フィルムを1コマ送って再び画像のポイントを抽出した。

非常に根気のいる作業であったことを思い出す。

人の眼の分解能と根気を考えると、どんなに頑張っても、23倍に拡大されたスクリーン上のターゲットを0.5mmの精度で追うのがやっとだった。いい加減な人がやると、1mm程度になるであろう。

■ 人間の眼によるトラッキング計測

スクリーン上の0.5mm間隔は、撮影倍率とスクリーン倍率の関係から考えてみると、

例えば、撮影した被写体の大きさが2500mmあったとして、これがフィルム上に5mmの像として記録されるとすると、23倍に投影されるフィルム像は115mmとなる。

この時、スクリーンの0.5mmの間隔は逆算していくと被写体上で11mmに相当する。

被写体での計測分解能11mmは、500コマ/秒の撮影速度を使った画像では5.5m/sの速度誤差となる。

時速40km/h(11.1m/s)の被写体を追いかける計測では、49.5%の誤差を覚悟しなければならない。

50%の誤差は、とてもがまんできる値ではないので、この撮影条件では速度成分は求められないことになる。

したがって、1枚単位での速度を求めるのではなくて、平均速度を求めるのであれば、20枚程度の平均で、すなわち20枚 x 1/500 = 2/50秒の平均速度として11mmの計測分解能を考慮するのであれば、0.28m/sの速度誤差となる。

この誤差であるならば、時速40km/h(11.1m/s)の場合、2.4%の誤差となり実用範囲内となる。

フィルム画像を手入力によってポイント計測する場合は、この誤差の他に、解析用映写機のフレームレジストレーション精度、レンズの性能(歪曲収差)、カメラの性能(撮影速度精度)などが加味されるため、誤差はさらに増大する。

この観点から見ても、手入力によるフィルム画像からの速度計測は極めて難しい作業であることがわかる。

これは、私が痛いほど経験したことである。

この経験を通して、「ViewPoint」のような高精度(0.2画素精度)の画像トラッキングソフトウェアに触れたとき、その解析結果に驚いた。

画像解析では、速度成分は出せないと思っていたのに、かなりの高精度で速度成分を求めることができたのである。

▲ 1970年代の画像自動読み取り装置

写真計測を重要な計測手段と考えていた上記の研究分野では、計測カメラで撮影した被写体(主にロケットやミサイル)の追跡測定に、手動ではなく自動的に行うシステムが強く要望されていた。

こうした要求に応えるべく、フィルム画像のターゲットポイントを自動で読み取る装置が1970年前半に米国で開発された。

当時は、フィルムカメラが主流であったので、現像から上がったフィルムを解析用映写機にかけて、フィルム像を計測用ビデオカメラ(イメージディセクタチューブ = Image dissector tube)で読み込んでいた。

解析用ビデオカメラとして1931年に開発された古いタイプのイメージダイセクタを採用したのは、このカメラが非蓄積管であるため撮像範囲を任意にスキャニングすることができてターゲットを追いかけやすいからであった。

▲ 1980年代の画像自動読み取り装置

1980年代後半には、自動車安全実験分野の解析においても人手による計測に代えて、機械が自動的にトラッキング処理を行いたいとするフィルム画像自動読み取りシステムの要求が増えてきた。

自動車安全実験では、10台以上の16mmフィルム高速度カメラが使われ、1台のカメラで撮影されたフィルム動画像の内の200枚程度(0.4秒の現象に相当)を計測していた。

1枚の画像で10ポイントの計測を行うと仮定して、一台のカメラで得られた撮影枚数200枚を行うには、2,000ポイントの計測作業となる。

10台のカメラでは20,000ポイントの作業量となる。

スクリーンに映し出されたフィルム画像を操作者が1ポイントずつカーソルを使ってデジタイジングしていくのに、およそ2.5秒/ポイントかかった。20,000ポイントでは14時間である。

2人でほぼ1日がかりの仕事になる。

この作業を人手に頼っていたのではとても効率が悪いために、自動読み取りシステムの要望が上がったのである。その要望に応えようとして、自動読み取りシステムの開発がなされた。

このシステムは、ハイスピードカメラで得られた16mmフィルム画像を解析用映写機にかけ、フィルム像を読み取る高解像度カメラ(カルニコン撮像管、解像力は水平800本x垂直525本)を使って対象物に貼付したターゲットマークをコンピュータで読み込むものであった。

システムは、コンピュータで連動する解析用の16mm映写機を特別に設計して、コマ毎の画像をコンピュータに送った。

このシステムは高価であり、システム総額で1億円程度であった。

高額であったにも関わらず、トラッキング精度はそれほどよくなく、当時のシステムの目標は、人の読み取り精度に追いつくことであった。

処理時間も、4〜5時間かかっていたと記憶する。

従って、撮影して現像から上がってきた16mmフィルムを解析用映写機にかけるのは夕方に行い、解析作業は夜中に無人で稼働させた。翌朝出社すると解析結果が出ているという案配であった。

▲ 1990年代の画像自動読み取り装置

1990年に入ると、計測カメラ(高速度カメラ)にもデジタルカメラが登場し、TIFF、BMP、Bayerフォーマットで動画像(ファイルが連番で保存された独立した静止画像)を扱えるようになった。

この時期は、フィルム式高速度カメラが終焉を迎えつつあり、デジタル高速度カメラが注目されるようになっていた。

自動読み取り装置も、デジタルカメラで撮影した動画像を直接コンピュータに読み込んで、ターゲットマークをデジタイジングするトラッキングソフトウェアが開発された。フィルム画像からデジタル画像の時代になった。

しかし、この時代は、コンピュータの性能が非力であり、データ通信もGP-IB (米国HP社が開発した計測データ通信インタフェース)が主流であり、SCSI (磁気ディスクドライブのデータ転送に開発された高速データ通信インタフェース)が軌道に乗ったばかりであった。イーサネット の本格稼働は、1990年代後半からである。

当時、高速度カメラで得られる大容量のデジタル画像データを直接コンピュータに送信するには時間がかかりすぎた。デジタルで画像を取り込むのは、640x480画素で2枚/秒程度が精いっぱいであった。

その点、NTSCに代表されるアナログ映像信号は30枚/秒と速かったので、カメラで取り込んだ動画像をアナログ画像信号に変換して、これを転送しビデオキャプチャーボードでTIFFファイル(もしくはTARGAファイル)に変換し保存していた。

当時の高速度カメラの画像は、水平方向が230本程度であったので、これで十分満足できるシステムの流れであった。

ただし、この時代はカラー画像をまともに保存していたので、640x480画素をもつ画像は、一枚当たり921.6kBのファイル容量になり、200枚の画像では184MBの容量になった。

400MBのハードディスクが10万円程度の時代では、すべてをデジタルに保存することは困難だったので、この時代は、VHSテープを使ってデータを保存する方法が主流であった。真のデジタル時代はまだ遠かったのである。

この時代のターゲット自動読み取りシステムの価格は、1000万円程度であった。

この頃になると、一般の研究にも画像処理ソフトが安価に出回るようになった。

当時の多くの画像処理ソフトウェアは、画像処理ボードの附属のような形でバンドルされていて、コンピュータの性能が上がってくると、ハードウェアを廃してソフトウェアで処理するようになって行った。

▲ 2000年代の画像自動読み取り装置

2000年を越えたあたりから、デジタル画像データを直接送受信する手法が確立し、高速でデータ通信が行えるようになった(ギガイーサネット、USB2.0、IEEE1394)。

また、コンピュータの性能が年々向上し、複雑なアルゴリズムを持つソフトウェアでも、通常のパソコンでなんとか高速処理できるようになり、膨大なデータ処理を必要とするターゲット自動読み取り装置もソフトウェア単体で動くようになった。

ViewPointは、こうした自動トラッキング解析の流れを汲む最新のソフトウェアである。

価格も1/4以下に下がった。

【トラッキングの基本的な考え方】

これらのソフトウェアのトラッキング手法は、基本的には同じであると考える。

▲ パッチサイズ/サーチエリア

右図にトラッキングの基本的な考え方を示す。解析したい動画像を開いて、対象物に貼付されたターゲットマークを選択する。

マウスを使ってターゲットマークをポイントすると、ターゲットマークにはパッチサイズとサーチエリアが定義される。

パッチサイズとは、ターゲットマークの大きさであり、サーチエリアは、パッチサイズで決められたターゲットマークをサーチする範囲である。

サーチエリアは、ターゲットマークをトラッキングするときの範囲を限定するためのもので、この範囲が大きすぎると処理時間に時間がかかったり、同じサーチエリアに同じ形状のものがあった場合に誤検知してしまう。逆にサーチエリアが小さいと、ターゲットマークが指定範囲からはみ出てしまい、トラッキングができなくなってしまう。従って、サーチエリアは、ターゲットマークが移動してもそれを十分にカバーできる範囲としておく必要がある。

解析を効率よく行うために、撮影の際に解析のことをを考えた十分な配慮をしておくと随分と助かる場合がある。

配慮の最も効果的なものは、ターゲットマークがゆっくりと移動するような撮影速度で画像を得ることである。一般的な指標として、1フレームでの移動を10画素以内に抑えるようにするとよい。洗練された自動トラッキングソフトウェアは、動きの先読みをするため、ターゲットが過去どのような動きをしてきたかを記憶して次のフレームでどの方向に動いていくかを先読みしている。従って、次のフレームでターゲットマークがどこに移動するかを予測してサーチエリアの網をかけることができる。

つまり、ソフトウエアは、ターゲットを10画素/フレームの速度成分で追いかけると言うよりも、10画素/フレーム2 の加速度成分でトラッキングできる。したがって、優れたトラッキングソフトウェアを使えば、フレーム間で20画素や40画素移動したとしても、15x15画素程度のサーチエリアでも十分にサーチエリア内で網を張ってターゲットを捕獲することができる。

▲ スレッショルド(トラッキングマークの確からしさ)

トラッキングソフトウェアでは、ターゲットマークを指定したときに、初期設定のターゲットマーク形状と全く同じ形状でテンプレートを作ると、フレーム間でマークが少しでも変化した場合にターゲットマークを読み込まなくなる。従って、テンプレートと被測定物は、ある程度あいまいにしておかないとうまくトラッキングができなくなる。このあいまいさを示す指標を、スレッショルド(threshold)と言い、0.10〜1.00の間で設定する。1.00はテンプレートと完全に一致する対象物を指定し、あいまい画像に対しては0.70程度に設定する。通常の設定は0.96程度である。設定を低くするとぼやけた対象物でも追うようになる反面、中心を特定する精度が甘くなる。従って、スレッショルドの値は、通常0.96に設定しておき、ターゲットマークの画素数が少なくて形状が不安定な場合や、ボケて撮影してしまった場合、または、圧縮をかけすぎて原型から外れてしまった場合には低い設定値を与えるようにしている。

▲ ターゲットマークの特定

ターゲットマークのトラッキングで大事な点は、ターゲットポイントを手際よくとらえてスムーズにトラッキングを行っていくことである。自動トラッキングソフトウェアの中には、ターゲットを特定するのにまごついたり、うまくターゲットをとらえられずに外れてしまうものがある。外れてしまったターゲットマークは、修復プログラム(トラッキングの修正を行うサブルーチンプログラム)で再度読み取りを行う。この作業は、手動でポイントをデジタイジングしていくのと同様に骨が折れる。従って、できるだけターゲットポイントを外さずに、自動読み取りを行わなければならない。

コンピュータがトラッキングをスムーズに行う場合に、十分に考慮しておかなければならない問題点が少なからずある。

トラッキングがスムーズに行えない問題点としては、以下のようなものが考えられる 。

1. トラッキングするターゲットの画質が悪い。

(小さくて数画素しかない。ピントが外れてボケている、画像に圧縮をかけすぎて原形をとどめない)

2. ターゲットが画像によって回転する。

3. ターゲットが画像によって歪む(楕円になる)。

4. ターゲットが画像によって薄くなったり陰にかくれて欠けたりする。

5. サーチエリア内に同じようなターゲットマークが複数入ってしまう。

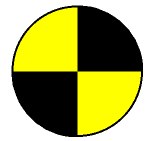

上の5種類のターゲットマークは、すべて同じカテゴリの中に含まれ、同じターゲットの種類とみなされる。

人の眼はこうした識別に長け、おおよその中心点を指摘することができる。

また、人の目によって中心を特定する能力は0.2mm程度であるが、ほぼ間違いなく中心を当てる。

コンピュータは、果たしてこれらすべてを同じ仲間としてその中心点を射当てることができるであろうか。

一番左のものはほぼ完璧なターゲットマークの形状であるが、右にいくしたがってボケている。4番目は中心位置が違う。一番右のマークは回転している。

自動トラッキングソフトウェアは、こうしたターゲットマークを同一のものと見なして自動読み取りを行なうことが宿命であり、この種のソフトウェアのアルゴリズム開発の歴史であった。

上に挙げた問題は、現実問題として絶えずつきまとうものである。ヒトの眼は、こうした問題に関しては要領よくターゲットを抽出するけれども、コンピュータはこうしたことが苦手である。このような問題(時々刻々に変わるターゲットマーク形状の問題)をいかにうまくスマートに対処するかが自動トラッキングソフトウェア開発の腕の見せ所となる。

【ターゲットの種類】 - どれだけの種類があるのか

自動トラッキングを行う場合、もっとも理想的なトラッキングアルゴリズムは次のようになる。

すなわち、

・操作者が、初期設定としてクリックしたポイントをコンピュータが認識し、

・数十枚〜数百枚の画像にわたって、寸部の狂いもなく初期設定したポイント(これをテンプレートと呼ぶ)を追いかける。

しかし、現実にはそれは不可能に近い。なぜかと言えば、画像はフレーム毎に変化するため、一つとして初期画面で設定したテンプレートと同じ物はない。ターゲットマークが移動していけばそれに伴い揺れたり回転しする。また、固体撮像素子上にゴミが付いていればそこに入った画像は惚けてしまう。照明によっても、照らされるターゲットマークの明るさは時々刻々変わる。したがって、トラッキングは、そうしたあいまいさを受け入れる手順を残しながらも、本来あるべきターゲットの形状を教えておいた方が処理が行いやすい。つまり、ソフトウェアにトラッキングのためのヒントを予め与えてやれば、驚くほどしっかりとした仕事をするようになる。すなわち、あらかじめよくわかったターゲットマークの対象物に貼付る方法である。

例えば、四半円形(Quadrant)のターゲットマーク

次によく使われるターゲットマーク形状が白いドット(○)、もしくは黒いドット(●)である。これらのマークは、現場でマジックやホワイトマーカで簡単にドットを描き込むことができるので重宝する。

このほか、◆、■、▲などが考えられるが、上記の部類に入らないので「特徴点」モードとなる。特徴モードは、初期設定でクリックした部位をターゲットマークと認識して、このパターンを損なわないように、パターンマッチングを試みて追跡を行うものである。当然、これらは上記のターゲットマークよりトラッキング精度が悪くなる。

上に示したメニューは、ViewPointで使われているターゲットマークメニューである。希望するマークをクリックして、次に(解析を行う)画像のターゲットマークを指定すると、トラッキングポイントとして認識され、そのマークのテンプレートに従ってポイントが追跡される。

【ターゲットの大きさ】 - どのくらいの大きさが妥当か

例えば、左の画像を見てみる。この図は、上で説明した四半円形(ターゲットマーク)の拡大画像である。この画像は、11x11画素分のものである。自動トラッキングソフトウェアは、実は、これだけの画像サイズで、ターゲットを追いかける大きさとしてしている。これだけしか見ていない。この大きさの画像から、中心位置を割り出し、動画像を渡り歩いてこれと同じパターンを探し出してトラッキングをしている。画像の縦線と横線に表れる暗部と明部の境目を1/10画素程度まで独自のアルゴリズムを使って特定し、X軸、Y軸方向の中心を割り出している。ViewPointは、11x11画素のターゲットを仮想的に110x110分割にして、中心位置を計算によって求めている。自動トラッキングソフトウェアにとっては、ターゲットマークの画質が良ければ11x11画素は十分な大きさと言える。

左の画像は、良好なターゲットの部類に入る。ターゲットの大きさが4画素しかないとすると、その画像から中心を求めるのは極めて困難である。4画素では中心を求めようにも判断ができない。よほど綺麗な画像でも、1画素分の精度しか得られない。ターゲットの中心を精度よく特定するには、ある程度の大きさが必要である。

以上述べたことから、ターゲットの大きさは、画像上で11x11画素〜20x20画素もあれば十分なことが理解できる。通常カメラの1枚あたりの画像は、640x480画素〜1280x1280画素でできている。この画素数の中で20x20画素のターゲットマークの占める割合を求めると、画像の1/24〜1/64程度で良いことになる。むやみに大きなターゲットマークを作って貼る必要はない。

1枚の画像の大きさ

撮影範囲

(水平方向)(mm)

推奨ターゲットマークサイズ

(被写体上)

640x480画素

1000

32mm

2000

63mm

5000

156mm

800x600画素

1000

25mm

2000

50mm

5000

125mm

1280x1024画素

1000

16mm

2000

31mm

5000

78mm

ターゲットマークの大きさ。

撮影エリアと使用するカメラの撮像素子サイズ(画像素子数)で

ターゲットマークの大きさは決まる。

画素数の多いカメラを使えば、同じ撮影範囲でも小さいターゲットマークを

使用することができる。

【トラッキング精度】 - どくらいの細かさまでターゲットを特定できるのか

■ 四半円ターゲットマーク

自動トラッキングソフトウェア(ViewPoint)は、どのくらいのトラッキング精度をもっているのであろうか。

先に、四半円形(Quadrant)のターゲットマーク

他のターゲットマークではこれほど精度よく中心を求めることはできない。その精度は1/10ピクセルに達している。

ターゲットマーク(四半円形)の中心部の濃度を立体的に示したもの。

ターゲットの中心は、濃度的には谷底になっている。

谷底のさらにその底部(中心)を求めるために山の傾斜を調べながら

中心部をサブピクセル(1画素の1/10)まで求めている。

上図の立体プロファイルの作成には、ImageJ を使った。

■ ドットマークのトラッキング精度

4種類の代表的な黒丸。

一番左が真円。隣が45度回転した真円。左の真円とは外縁のギザギザのでき方が違う。その隣が楕円。一番右が45度傾いた楕円。

右図は黒ドットである。我々の目からすると、これらはすべて黒い丸と判断できる。しかし、コンピュータにこれを同じ物だと判断させるためには高度な知識を入れ込む必要がある。

ドットマークをトラッキングする場合、円の中心を求めるアルゴリズムを使う。多くの場合、円の中心を求める手法として重心を求める計算式を当てはめる。しかし、重心計算を当てはめた場合、たとえばマークが欠けた時や、照明などで黒丸の濃度ムラができた時に重心位置がずれてしまう。従って、ドットをトラッキングしていくアルゴリズムでは、外縁の形状もデータとして考慮し、黒丸の弧を外装 して中心点を考慮するトラッキングが行われている。

外縁の円弧を数式に乗せて中心点を求める場合には、円弧が数式に乗るに足るだけの情報量を持っていなくてはならない。その観点からすると円の大きさが大きいほど中心を求める精度は高くなる。しかし、現実問題として、あまり大きなドットは被写体に貼り付けられないので、20ピクセル〜30ピクセルが妥当な大きさと言える。

黒丸をテンプレートとするトラッキングの精度は、1画素の半分、つまり1/2画素程度となる。四半円ターゲットに比べるとトラッキング精度は落ちる。

■ 回転角トラッキング

ViewPointの特徴に、四半円ターゲットマークの回転を検出する機能がある。

以下の図が、回転中心に貼られた四半円ターゲットマークの回転トラッキングを行ったサンプルである。このモードでは、四半円ターゲットマークの暗部と明部の境を角度情報として検出し、初期フレームの回転角からどのくらいの角変化があったのかを求めている。

この機能を用いた解析は、プリンタのドラム回転研究や、ドリルやスピナーなど各種機構装置に組み込まれた回転体の研究、ギアのバックラッシュ研究、ブレーキディスク、ベルトなどの巻き取り機構の研究分野に重宝されている。1つのターゲットマークで、マークの中心位置移動と回転角が同時に計測できるのでとても魅力的である。

回転円板の中心に四半円ターゲットマークを貼付し撮影。

ViewPointで回転角トラッキングで回転角を検出。

左下の画面は中心部の拡大図。アイコンは回転角のアイコン。

結果をグラフ(右)に表示。

グラフは横軸が時間で縦軸が回転角(degree)表示。

このグラフから、回転円板は10秒間で500°の回転をしていて、

等角速度運動である(つまり一定のスピードで回転している)ことがわかる。

【トラッキングの実際】

■ トラッキングの実行

トラッキングを行うプロセスを説明する。

下に示した画面で使用した動画像は、512x512画素、30コマ/秒で10秒間の撮影(300枚撮影)をしたAVI画像である。

ViewPointで動画像を指定すると、下の画面が表れる。新しく動画像を開いた場合は、ターゲットマークを示す緑のポイントマーカと数字は表示されない。

下に示した緑のポイントマーカと数字は、トラッキングモードの手順を経て表示される。

トラッキングモードでは、希望するターゲットマークを選び、画像内のターゲットポイントを指定していく。

下の図では、3ポイント(ポイント1、ポイント2、ポイント3)が選択されている。下画面にある右側ウィンドウは、拡大ウィンドウであり希望するポイントを拡大表示することができる。

この例では、画面はポイント(3)の拡大像が表示されている。拡大倍率は、18倍である(画面の青色帯部に18:1の表示がある)。

左のウィンドウが全体像を表し、右のウィンドウが局所を拡大表示している。拡大画面は、トラッキングを行っている最中でもトラッキングポイントに固定(Lock)して表示することができる(これをLock Zoom Window 機能と言う)。

この機能により、トラッキングが十分に行われているかをこの画面で随時確認することができ、また、トラッキングを終えた後も、トラッキングが正常に行えたかをこの画面でチェックすることができる。

回転するターゲットのトラッキング。

右がトラッキングするターゲットの拡大図 。

■ トラッキングポイントの出力

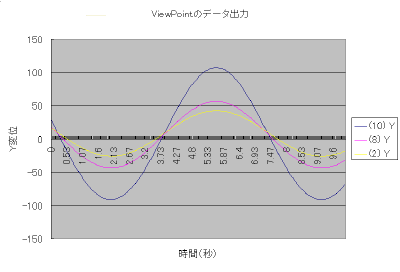

トラッキングが終わると、トラッキングしたターゲットポイントデータのグラフ出力ができるようになる。下の画面は、トラッキングしたターゲットポイントのグラフを表示している。グラフは、横軸に時間、縦軸にY方向の変位を示している。時間情報は、撮影速度から求められる。この画像は30コマ/秒で撮った画像なので、フレーム間隔が1/30秒となる。つまり、画像30フ枚分で1秒となる。

原点は、初期設定では画像の中心部を原点としている。原点は画面にヘアカーソルが現れる。下の画像にも原点を示すカーソルが現れている。回転円板の中心は画像中心より左側に少しずれている。原点は、マウスのドラッグによって任意に変更でき、左下にもってくることも任意のターゲットポイントに吸着させることもできる。ターゲットポイントに吸着した原点はフレーム毎に変動するので、移動体の中の対象物の運動、例えば車に乗せられたダミーの相対的な動きを見るときに使用する。

サンプル画像を使った解析で得られたトラッキングのグラフ結果は良好なもので、きれいなプロット図を得ている。

プロットされているターゲットポイントは、

(6)青ライン

(3)橙色ライン

(2)灰色ライン

(4)緑色ライン

(5)赤色ライン

である。(6)と(3)、そして(2)(4)(5)は、画像上で同じ放射方向に配列されたものなので変位の位相がそろっている。ターゲットマークは、(6)(3)(2)が四半円ターゲットマークであり(4)と(5)がドットマークである。(5)のマークは、黒色マークであり、背景とコントラストがつきにくいものであったにもかかわらず、よく読み込んでいる(下の左下ウィンドウ参照)。しかし、(5)のターゲットポイントは背景とのコントラストが芳しくないために、トラッキング精度に影響していると思われる。これは、速度成分をグラフに描かせると顕著に表れる。

トラッキングしたターゲットのプロット図。

横軸は撮影速度から割り出される時間軸。

縦軸は、各ターゲットのY軸(上下振動)変位。

■ トラッキングポイントの出力 - 速度成分

上の変位グラフのプロットでは、良好なグラフが描けたので、次に速度成分をグラフにしてみる。

速度成分は、ポイントの変位を時間で割った値であり、ターゲットポイントがどれくらいの速度で移動しているかを知ることができる。

また、速度成分は変位の微分処理なので、変位の差分を顕著に見ることができる。即ち誤差が出やすくなる。

この動画像は、1フレームが1/30秒に相当しているので、フレーム間のポイント移動変化をこの時間で割れば速度成分を求めることができる。

こうして得られた下の画面のグラフを見ると、(5)の黒色ドットの速度成分(赤色ライン)が他のデータに比べて誤差成分が大きいことが一目瞭然にわかる。つまり、(5)のトラッキングは十分な精度で行なわれていなかったことを示している。ポイント(5)のトラッキングはドット形状でおこなった。しかも暗い黒丸であったために、背景とのコントラストがつきにくく、形状を正確に判断することが難しかったと考えられ、これが速度成分の正確さを欠いたと考えられる。他のポイントについては、ほぼ良好な曲線が得られていて、トラッキングがかなりの精度で行われたことがわかる。

このグラフを使って、ViewPointがどのくらいのトラッキング精度を持っているかを調べることにする。

グラフで示されているプロット線の中で、赤い線(ポイント5 = ドット形状認識によるトラッキングで得られた速度成分)に注目して、これの変動平均を読み取ると、15ピクセル/秒〜18ピクセル/秒の誤差があることが読み取れる。この誤差を読み取り誤差として見るために1/30秒を乗じてやると、0.5ピクセル〜0.6ピクセルが得られる。この値、つまり、0.5〜0.6ピクセルが、測定時(トラッキング精度)のバラツキ、つまり測定誤差であることがわかる。

このことは、トラッキング精度が悪いと言われている黒丸ではありながらも、0.5ピクセル程度でトラッキングを行っていることを教えてくれている。

このグラフで滑らかな曲線を示している四半円ターゲットの速度成分曲線(紫、水色、黄色)を見てみると、速度が最高速度から減速に移ったときに誤差と想われる変動が現れていて、その成分は2〜4ピクセル/秒である。これに、1/30秒を乗じてやると0.07〜0.13ピクセルという値になる。これがとりもなおさず、ターゲットマークの読み取り誤差に相当する。

このことから、トラッキングは1/10画素程度で行われていることが理解できる。

トラッキングしたターゲットのプロット図(速度変位)。

横軸は撮影速度から割り出される時間軸。

縦軸は、各ターゲットのY軸(上下振動)速度変位。

速度変位は、フレーム間の移動をフレーム間の移動時間(ΔT)で割ったもの。

【トラッキング処理時間】

いくら精度のよい自動トラッキングができたとしても、トラッキングにかかる時間が遅いようでは使いものにならない。

研究現場では、どのくらいの処理時間であれば有効なツールとして認めてくれるであろうか。

ある研究開発の現場を想像してみる。

その現場は、新製品開発のために新しいコンポーネントの安全性を確かめる試験グループである。

新製品の設計は、コンピュータシミュレーションによって強度計算、機構設計がなされて試作品が出来上がってくる。

その部署は、そうした試作開発品を試験装置を使って希望する設計条件に適合しているか否かの評価を下す。

試験の結果は、レポートにまとめて設計部に還元する。

試験を行ための準備は2時間。試験は5回行う。

破壊強度試験の時は、1回で試作品が壊れるためこの限りではない。

別の試作品についても同じような試験が行われるので、1日3種類から4種類の試験、合計15〜20回のテストが行われる。

試験が終わる毎に、その結果は次の試験までに出しておきたい。前の試験の結果を受けて、次の試験の段取りをするときはなおさらである。

多くの場合、試験には高速度カメラの他に、振動や圧力、加速度、温度、移動距離、接地するまでの時間などを測定するセンサーも装着される。

このようなセンサーは、近年コンピュータと連動して比較的短時間にデータを得ることができる。

従って、できればこのセンサーデータと画像データを付き合わせたい。

これらを総合すると、動画像解析に求められる解析時間は、画像のダウンロードも含めて30分〜60分ということになる。

高速度カメラに目を移す。使用する高速度カメラは2台。撮影速度は2,000コマ/秒(5ms時間分解能)。

計測時間は、0.5秒分の録画をしたいとすると1,000枚のダウンロードとなる。

ダウンロードした画像のうち計測したい枚数は200枚。計測ポイントは1台のカメラにつき7ポイント。合計すると2,800ポイントになる。

高速度カメラのダウンロードは、カメラによって違いがあるものの(株)日本ローパー(2008.01よりIDTジャパン(株))のHG-100K、MotionProなどでは約3分程度である。この時間でAVIファイル(非圧縮)によるダウンロードと保存が行われる。

JPEG画像(200枚の連番画像ファイル)であれば、画像容量が小さいので1分以内でダウンロードされる。

(これはHG-100K高速度カメラを用いた場合。他のカメラでは、JPEGの圧縮処理をパソコンで行うので逆に時間がかかる場合がある。)

ViewPointソフトウェアでデータをトラッキングする場合、ターゲットが良好であれば、そのトラッキングスピードはおよそ10ポイント/秒である。

1つのターゲットポイントを指定して、200コマ分トラッキングさせると約20秒の時間がかかる。それを7回繰り返す。

だいたい1つのポイントを指定してトラッキングを終えるのに1分かかるとして、7ポイントで約10分である。

2台のカメラの場合は2倍になるので20分である。トラッキングが外れて修復を余儀なくされるときは、この限りではない。

この試算より、概ね20分でトラッキングが完了する。

トラッキングが完了すると、希望するデータをグラフに表示させる。

多くの場合、表示するグラフは、時間軸に対する変位と速度である。

時には、外部からセンサーデータを取り込んで、加速度データや圧力データを画像及び画像から抽出したデータとソフト画面上で付き合わせる。

このように考えると、ViewPointに習熟した研究員が解析を行えば、試験後30分ほどで大所のデータが揃うことになる。こうした研究を行っている研究員は、試験結果の体裁よりもまず欲しいデータを即座に抽出して、次への試験の段取りのため参考とするのでスピーディさが何よりも大切だと言い切っている。

体裁の良いレポートは、試験が終わった後で時間を作ってまとめれば良いので、何よりもスピーディで正確なデータが欲しいと言っている。

スロープを下るスライダ(1)がバネのついたダンパー(2)に

当たって往復運動する画像のトラッキング解析結果。

700フレームの画像を55秒間でトラッキングした。(トラッキングスピードは12.67ポイント/秒)

700フレームを人の手で行うのは、根気の問題上限りなく不可能。

それでも1ポイント/秒で手入力すれば12分でできる。 (私自身は、700ポイントを手で入力していく根気はない。)

手入力した場合、上のプロット図のような滑らかなデータ結果を得ることは不可能に近い。

自動トラッキングはターゲットの中心をサブピクセルでトラッキングできるので正確。

上図左は撮影画像を示し、上図右が左の画像中のトラッキングポイント拡大ウィンドウを示す。

上図下のグラフがポイント1のX方向の変位である。23回のバウンドを詳細にトラッキングしている。

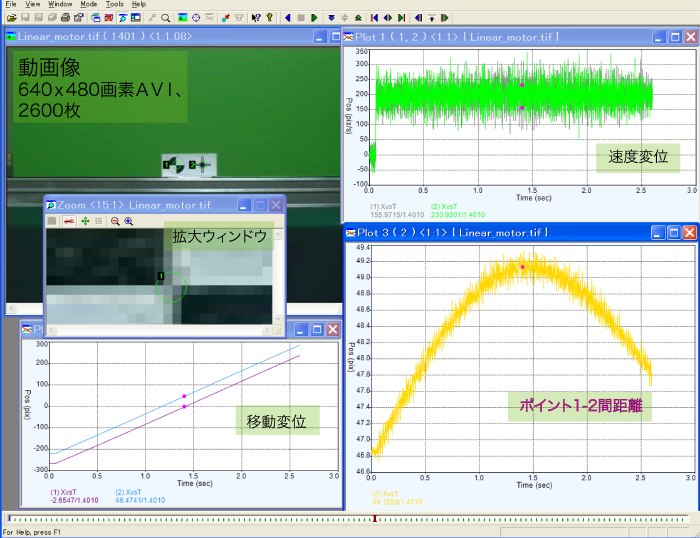

【レンズ歪みの検出】 (2007.07.16)

以下の試験は、対象物の変位を求めたものではなく、計測系の(カメラ位置やレンズ収差による)誤差を発見したものである。使用した動画像は、640x480画素を持つ2600枚のAVI画像で、2.6秒で水平移動するキャリアに四半円形(ターゲットマーク)と黒ドットの2種類のターゲットマークを貼付してこれをViewPointでトラッキングした。

2600枚の画像をトラッキングするのに2分42秒(162秒)かかった。1枚に2ポイントターゲットマークがあるので、この場合のポイントのトラッキング速度は、

2600枚x2ポイント/162秒 = 32.01ポイント/秒

32ポイント/秒となった。1秒間に32ポイントを抽出する作業は、人の手ではとてもできない。

この画像内のターゲットマークは、2600枚の画像間で水平方向に550画素を移動した。したがって、1枚あたり0.21画素しか移動しておらず、画像で動きを見ると実にゆっくりと移動していた。コンピュータがトラッキングを行うにはフレーム間の動きは少ない方が追いやすい。撮影速度は1000コマ/秒であったので、移動速度は210画素/秒となる。これは下の図の速度変位の数値(右上のグラフ)とよく一致する。

速度変位のグラフ(右上のグラフ)が150-250画素/秒で変動しているのは、ViewPointの読み取り誤差と考えられる。1/1000秒のフレーム時間を考慮して読み取り誤差を考えると、1枚の画像で読み取る誤差は0.1画素[= (250-150)/1000]となる。この読み取り誤差でも、時間成分で割ってやるとこの程度の誤差が現れる。

水平に移動するターゲットの追尾とその結果のグラフ。

同じ移動物体に取り付けられた2つのターゲットマークを自動トラッキングし、両者の成分を比較。

移動も速度も両者ともよく検出されている。

右下の「ポイント1-2間距離」のグラフでは、

両者が画面中央と周辺で2画素程度の距離の伸び縮みがあることを表している 。

注目に値するのは、上に示した表示画面の右下の黄色いグラフである。このグラフは、ポイント1 - ポイント2間の距離を示したグラフで、1.4秒地点(すなわちキャリアが中央に来た地点)がもっとも大きい値を示し49.1ピクセルとなっている。ターゲットマークが画面の左端にある時は46.85ピクセルである。両者の差は2.25ピクセルとなる。ポイント1とポイント2は、同じキャリア(物体)に貼り付けられるので同じように動いているはずである。二つのポイント間には伸び縮みする要素は見あたらない。移動変位のグラフ(左下)を見ても、速度変位(右上)を見ても両者は良好な位置関係と速度を持っているように見える。しかし、原点をポイント1にセットしポイント1から見たポイント2の距離を算出して両者の距離の差を調べてみると、画面640画素の中の2画素程度ずれていた。

これは、撮影したレンズの歪みであると考えられる。距離が同じであるはずの物体が、画像の中央と周辺部で伸び縮みがあり、その差違は、

2.25画素/49.1画素 = 0.046 ・・・(IDP6)

となっていて、4.6%もの違いが認められる。この値はそのままレンズの歪みと判断して良さそうである。

この画像は、私が実際に撮影したものではないのでどのような撮影条件で得られたものかはよくわからないが、この結果から見る限り、レンズは樽型で4.5%の歪曲収差を持つものであることがわかる。4.5%の収差はあまり良いレンズではない。広角系のレンズであろうと考える。レンズにマイクロニッコール55mmや、長焦点のレンズを使えば歪曲収差は0.5%以内に抑えられていたと考えられる。

プロットされた黄色いラインを見てみると、フレーム毎に測定値が変動していて、その誤差のためにライン巾が太く見える。その巾は0.2画素程度である。これは、ViewPointの検出できるポイントの誤差が0.1画素であるので、ポイント1とポイント2の読み取り誤差の和として差し支えない。

ViewPointでは、このようにターゲットマークの読み取りを0.1画素程度で読み取れるため、レンズの歪みまでも検出できることが、この例から知ることができる。

【データ出力】

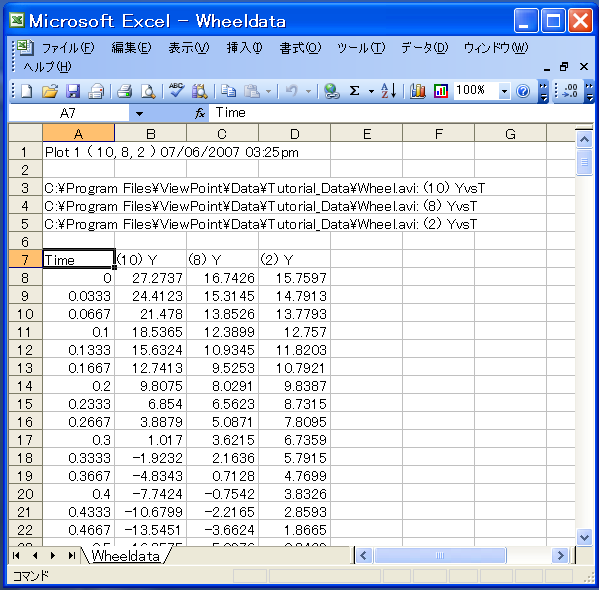

ViewPointによってトラッキングされたデータは、csvフォーマットで別保存できるようになっている。下図の左は、csvファイルをエクセルで開いたものである。csvファイルでは、最初の段から5段までがヘッダ部に当てられ、7段目が数値データのタイトルで8段以降が数値になっている。数値データの左列(A列)が時間値で、右隣(B列〜D列)がそれぞれポイント10のY変位、ポイント8のY変位、ポイント2のY変位となっている。

【ViewPointの主な特徴】

ViewPointの特徴を以下に示す。

■ 扱える画像

ViewPointで扱う動画像ファイルは、

・ BMP(連番ファイル)

・ JPEG(連番ファイル)

・ TIFF(連番ファイル、及び concatenatedファイル = AVIのような連番画像が一つにまとまったTIFFファイル)

・ AVI

・ MPEG(オプション)

である。

■ 扱える動画像の大きさ

ViewPointでは、画像の大きさに指定はない。1280x1024画素、1524x1104画素の動画像も問題なく開けて解析できる。画素数が多いとファイルが大きくなるので、使用に際しては解析できる動作環境(モニタの大きさ、パソコンのRAM容量、HDD容量など)を考慮する必要がある。

■ 扱える動画像の枚数

ViewPointは、動画像の枚数に制限はない。コンピュータが扱える動画像の環境に対応する。AVIファイルは、OS自体の問題で2GBまでしか扱えないので、数千枚の解析をする場合は、JPEGなどの連番で動画像を保存して行うことを薦める。

■ 一度にオープンできる画像

ViewPointではモデルが3種類あり、モデルにより機能が制限されている。最上位モデルは制限がない。最上位モデルでは、モニターに表示できる数だけオープンすることができる。ただし、大きな容量の動画像をたくさん一度に開けておくと、コンピュータのメモリ(RAM)が足りなくなりハードディスクドライブ(HDD)にも負担がかかるので最大でも9画像ぐらいが妥当だと思われる。

開いた動画像は、すべて同期をかけて再生することができる。撮影速度の異なった動画像に関しても、時間軸を合わせて再生することができる。これは、500コマ/秒で撮影された動画像と1,000コマ/秒で撮影した動画像の場合、500コマ/秒の画像が1枚送られると1,000コマ/秒画像は2枚送られて時間軸が合うように再生する機能である。

■ トラッキングできるターゲットマークの種類とポイント数

ViewPointの最上位モデルでは、追跡するターゲットマークの数に制限はない。100ポイント/1画面でも測定が可能である。あまり多くなると、ポイントの追跡管理が大変なので50ポイント程度が現実的だと思う。ポイント番号は任意に設定できるので、測定部位を管理する(例えば、ダミーの頭部を1〜10、腕を10〜19、足部を20〜29、胴体部を30〜39、シート部を40〜49という具合)には便利である。

トラッキングを行うターゲットマークの種類は以下の通り。

1. 固定点

2. 黒点

3. 白点

4. 特徴点

5. 四半円形(ターゲットマーク)

6. 四半円形回転

7. 2点による仮想点

■ トラッキング速度

トラッキングを行うスピードは、使用するコンピュータの性能に左右される。

PentiumよりはPentium4がトラッキングを完了する時間が短くなる。Intel iCoreの方がより速い。

また、CPUのクロック速度が高いほど速い。一般的に、最新のコンピュータで、かつ、デスクトップの方が性能が良いので速くトラッキングを行える。

私の持っている7年前(2004年)のノートパソコン(Dell Lattitude D600、モバイルPentium1.6GHz)では、およそ12ポイント/秒の速度が出せる。

最 近、テストしたデスクトップ(インテルCoreDuo)ではそれよりも40%程度速くトラッキングできた。

総じて、12ポイント/秒以上の性能を確保できると思う。

このことは、1画面5ポイントで100枚程度のトラッキングを行うのに、42秒程度で行えることを意味する。十分に納得できるトラッキング速度だと思う。

■ センサーデータのインポート

ViewPointでは、加速度センサーや圧力センサーなどのセンサーデータをエクセルファイルから直接読み込むことができる。

自動車の安全実験や各種研究開発では、さまざまな計測装置が使われる。モータの試験などではモータにかかる電圧や電流値を測定している。

こうしたセンサーデータを画像再生時に組み込んで同期表示すると有効な判断材料となる。

■ PIV画像処理ソフトウェア - Provision(プロビジョン) (Windows)

■ 多目的画像編集・ビュアソフトウェア - PixelRunner(ピクセルランナー) (Windows)

■ 火炎温度画像処理ソフトウェア - 二色法ソフト(TCMA) (Windows)

トップに戻る

ImageJは、計測用に作られたフリーウェアの画像処理ソフトウェアである。

ImageJは、計測用に作られたフリーウェアの画像処理ソフトウェアである。

IrfanTest-005.tif

IrfanTest-005.tif

ターゲットをコンピュータが読み込んでいく場合、どのくらいの大きさが適当であろうか。

ターゲットをコンピュータが読み込んでいく場合、どのくらいの大きさが適当であろうか。