|

||||

|

||||

| ���Υ���ƥ�Ĥϡ�Dreamweaver CS6������Ƥ��ޤ��� | ||||

��

��

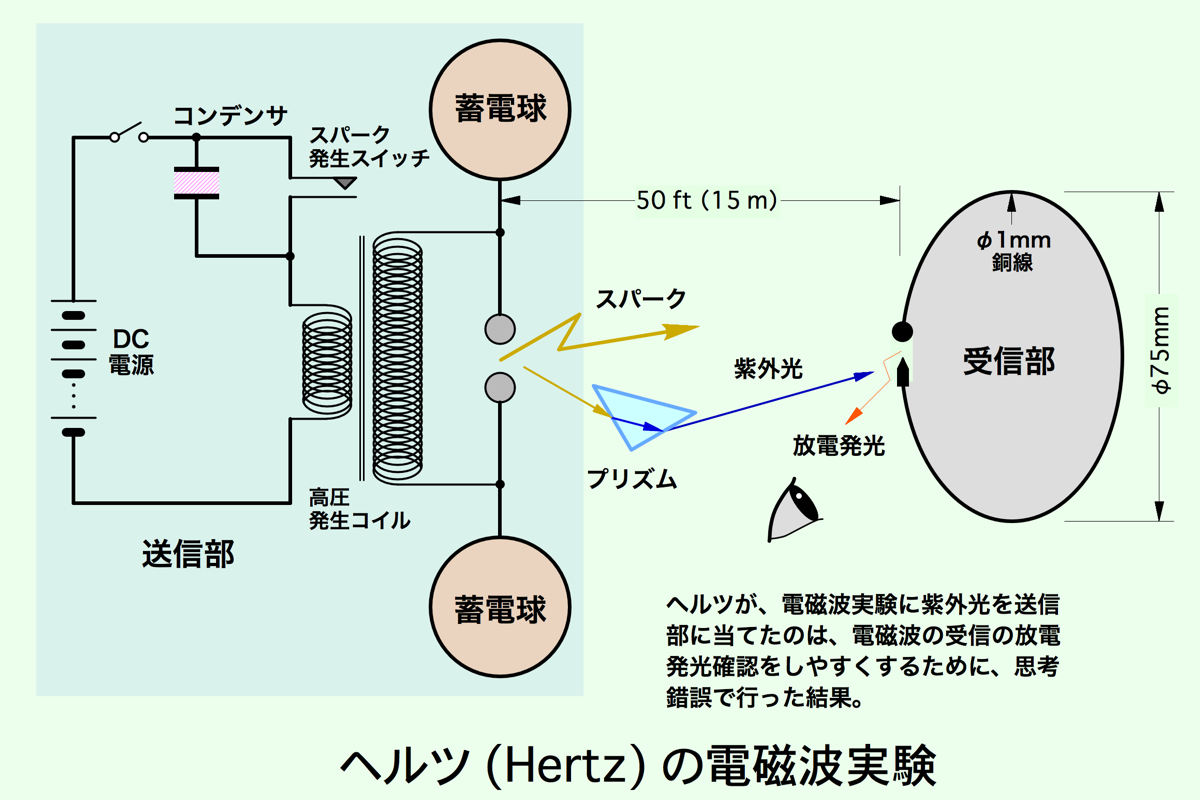

��ϡ��ɻ�¸������ť���åפ�Ȥä����Ť����ʲ����ȡˡ������15��ȥ�Υ�줿���֤˥�����Ǻ�ä���������֤������Ŵѻ���ԤäƤ��ޤ����������Ť����Ƽ����������Ť��������ȡ��������Υ���å����֤����Ť�������Τǡ�������ǧ���Ƥ����ˡ�

��ϡ��ɻ�¸������ť���åפ�Ȥä����Ť����ʲ����ȡˡ������15��ȥ�Υ�줿���֤˥�����Ǻ�ä���������֤������Ŵѻ���ԤäƤ��ޤ����������Ť����Ƽ����������Ť��������ȡ��������Υ���å����֤����Ť�������Τǡ�������ǧ���Ƥ����ˡ�

�� ��

��

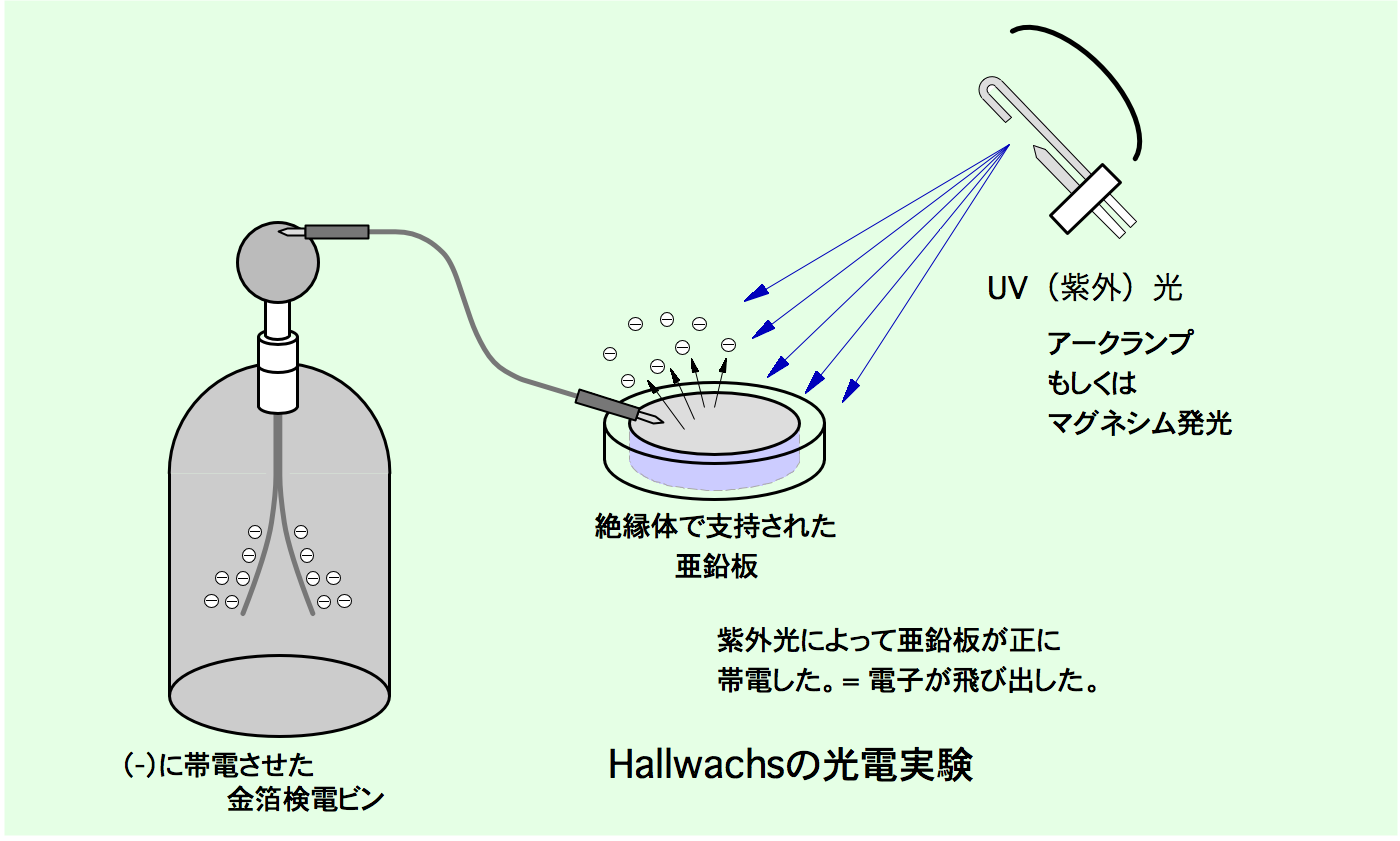

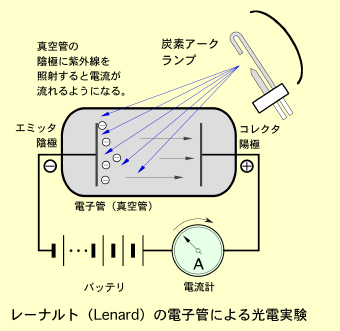

����ˡ�20ǯ���1902ǯ��Ʊ��Υե���åס��졼�ʥ�ȡ�Philipp Eduard Anton von Lenard��1862 - 1947���إ�Ĥ���ҡ�1905ǯ�Ρ��٥�ʪ���ؾ��ޡˤˤ�äơ���������=�Ż����ˤȸ��˴ؤ��뤵��ʤ붽̣�����������̤������ޤ����ʾ屦���ȡˡ�

����ˡ�20ǯ���1902ǯ��Ʊ��Υե���åס��졼�ʥ�ȡ�Philipp Eduard Anton von Lenard��1862 - 1947���إ�Ĥ���ҡ�1905ǯ�Ρ��٥�ʪ���ؾ��ޡˤˤ�äơ���������=�Ż����ˤȸ��˴ؤ��뤵��ʤ붽̣�����������̤������ޤ����ʾ屦���ȡˡ�

�������̻���ι��ۤˤ����ơ����ȥ����Wilhelm Konrad Roentgen��1845-1923����1895ǯ��ȯ������X���ϡ�����¿��ʤ�ҥ�Ȥ�Ϳ���ޤ�����

�������̻���ι��ۤˤ����ơ����ȥ����Wilhelm Konrad Roentgen��1845-1923����1895ǯ��ȯ������X���ϡ�����¿��ʤ�ҥ�Ȥ�Ϳ���ޤ�����

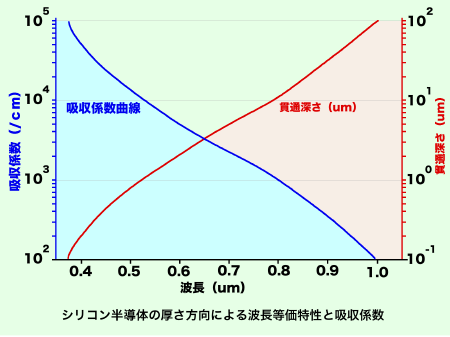

��ϡ�ͻ�������ꥳ���Ȥä���ʬŪ�˹���ٲ�������ˡ����Ѥ��ޤ���

��ϡ�ͻ�������ꥳ���Ȥä���ʬŪ�˹���ٲ�������ˡ����Ѥ��ޤ��� �� ��

�� ��

|

|||||

��

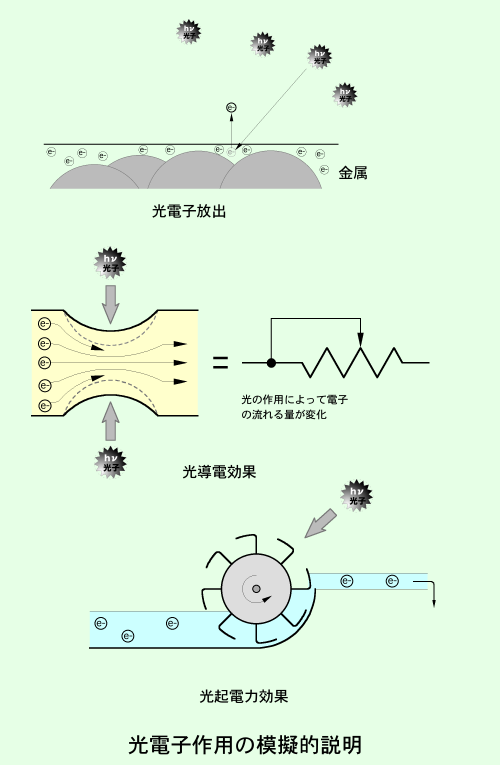

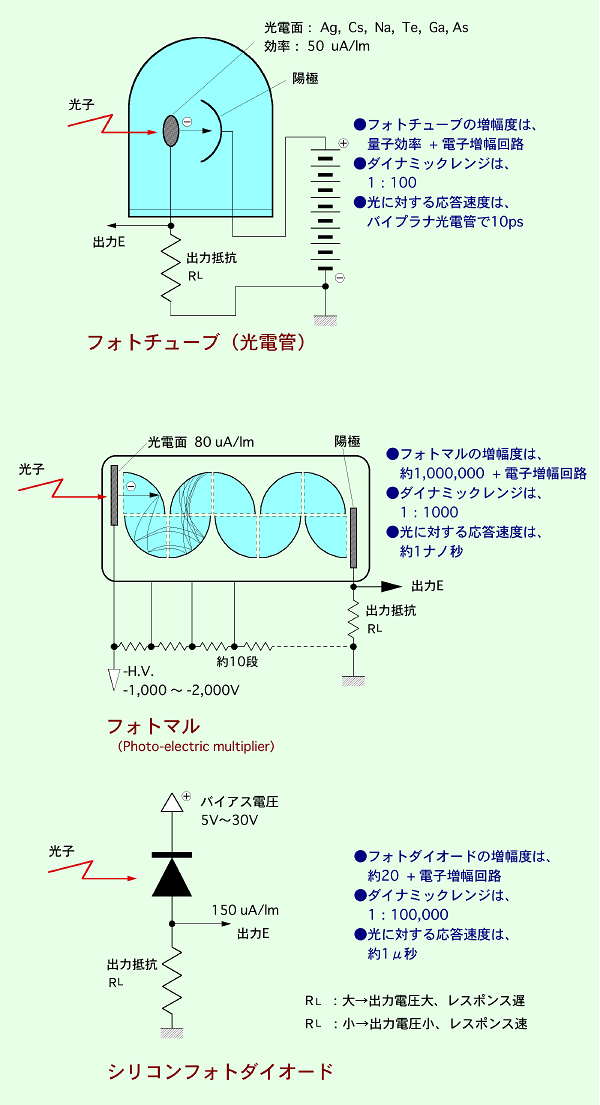

��  �ե��ȥޥ�λȤ��Ƥ�����ɽŪ�ʻ����Ҳ𤷤ޤ���

�ե��ȥޥ�λȤ��Ƥ�����ɽŪ�ʻ����Ҳ𤷤ޤ���

|

|||

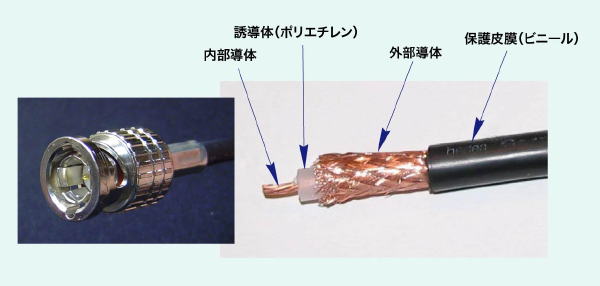

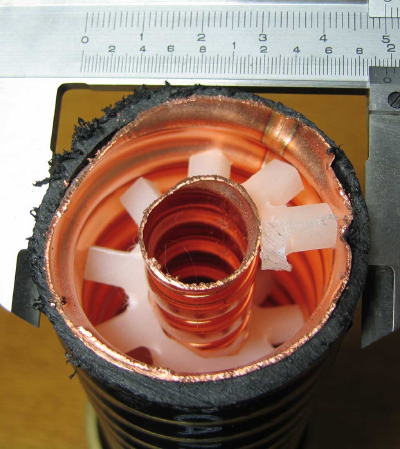

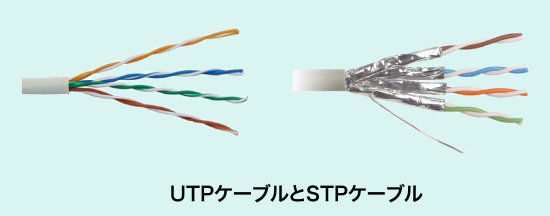

�ե��ȥ��������ɡʻ��͡ˡ� �����Ϥ��������ʥ����פ����롣�̿��Ϻ����γ������α߷������ե��ȥ���������������ü�Ҥ�BNC�ˤʤäƤ��ƻȤ��䤹���� |

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

��

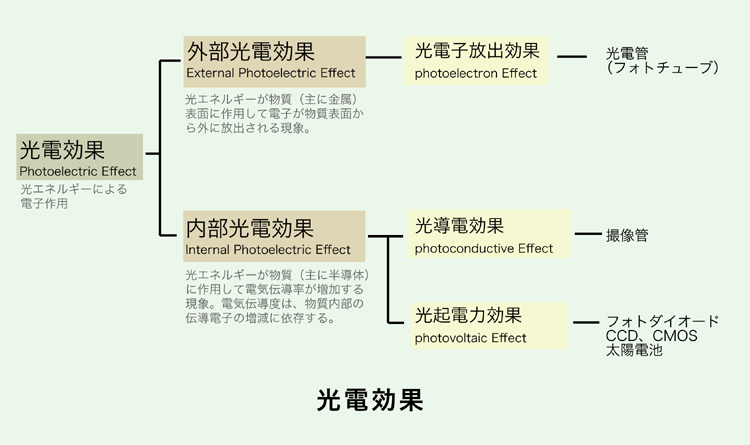

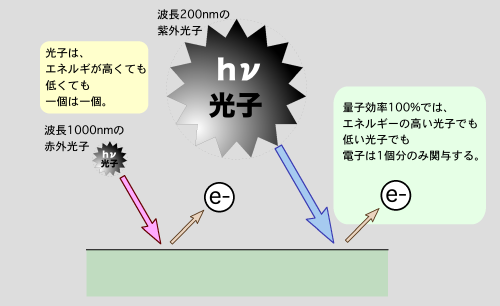

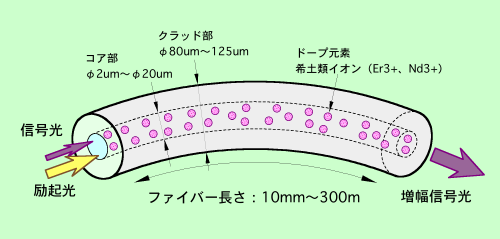

�Ż߲����ˤ����Ƥϡ�����Υե�����������ĤλؿˤǤ�����

�Ż߲����ˤ����Ƥϡ�����Υե�����������ĤλؿˤǤ�����

Ʊ���塢��Ω�����C-MOS�����פλ����ǻҤ���ȯ������β�����ޤ�����

Ʊ���塢��Ω�����C-MOS�����פλ����ǻҤ���ȯ������β�����ޤ����� ������ޤ�����

������ޤ����� �˥ȥ�����Υ����å���ȤäƼ��Ф����ᡢ�����å��Υ�����¿�������줬�����˰��ƶ���Ϳ���ơ�S/N�椬���ޤ��ɤ��ʤ���CCDž����������٤��礭�ʥϥ�ǥ�����åפ�����äƤ��ޤ�����

�˥ȥ�����Υ����å���ȤäƼ��Ф����ᡢ�����å��Υ�����¿�������줬�����˰��ƶ���Ϳ���ơ�S/N�椬���ޤ��ɤ��ʤ���CCDž����������٤��礭�ʥϥ�ǥ�����åפ�����äƤ��ޤ�������

���ȤΥץ��������Ȥȸ����ΤϷäޤ줿�Ķ�����ǰ�Ƥ��ƴ��������Τ��ȡ��伫�ȤϻפäƤ��ޤ�����

���ȤΥץ��������Ȥȸ����ΤϷäޤ줿�Ķ�����ǰ�Ƥ��ƴ��������Τ��ȡ��伫�ȤϻפäƤ��ޤ�����

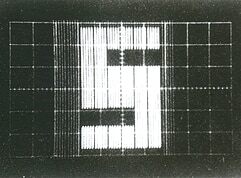

���һ�ϡ������ʸ�����ɤ��CCD�λ����Τꡢ��̣��Ф����ȳؤ�CCD�θ���˼�꤫����ޤ���1970ǯ12��Τ��ȤǤ�����

���һ�ϡ������ʸ�����ɤ��CCD�λ����Τꡢ��̣��Ф����ȳؤ�CCD�θ���˼�꤫����ޤ���1970ǯ12��Τ��ȤǤ����� �����ʾ���48ǯ��1973ǯ�ˤΥ��ˡ��β�һ���ȸ����С����㡼�פ���ȯ����4�ӥåȥޥ�������¢���Żҷ�������ȯŪ�����Ԥ��Τ����������ơ�6ǯ����1967ǯ�ʾ���41ǯ�ˤ˳�ȯ����������ʤȤʤäƤ����ŵ������֥��Хå��� = SOBAX = Solid State Abacus���Żҥ����Х�פ����Ԥ����Ѥä���ߤ�Ǥ��ޤä������Ǥ�����

�����ʾ���48ǯ��1973ǯ�ˤΥ��ˡ��β�һ���ȸ����С����㡼�פ���ȯ����4�ӥåȥޥ�������¢���Żҷ�������ȯŪ�����Ԥ��Τ����������ơ�6ǯ����1967ǯ�ʾ���41ǯ�ˤ˳�ȯ����������ʤȤʤäƤ����ŵ������֥��Хå��� = SOBAX = Solid State Abacus���Żҥ����Х�פ����Ԥ����Ѥä���ߤ�Ǥ��ޤä������Ǥ����� ��Ĺ�δ�ֻ�ϡ����ʤⴰ�����Ƥ��ʤ������������˳�ȯ�Ӿ��CCD�����������ߡ���ʸ���äƤ��ޤ��ޤ�����

��Ĺ�δ�ֻ�ϡ����ʤⴰ�����Ƥ��ʤ������������˳�ȯ�Ӿ��CCD�����������ߡ���ʸ���äƤ��ޤ��ޤ�����

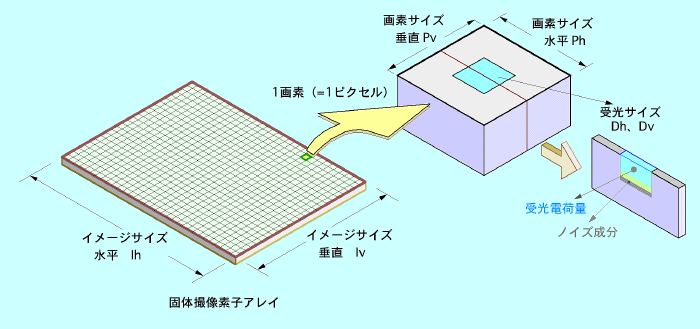

������������ϡ������礭����ɽ����硢����Ū��1���������2/3���������1/2���������1/3��������Ȥ����������ǸƤӡ����θƾΤǤ����������礭�����狼��褦�ˤʤäƤ��ޤ���

������������ϡ������礭����ɽ����硢����Ū��1���������2/3���������1/2���������1/3��������Ȥ����������ǸƤӡ����θƾΤǤ����������礭�����狼��褦�ˤʤäƤ��ޤ���

|

|||||

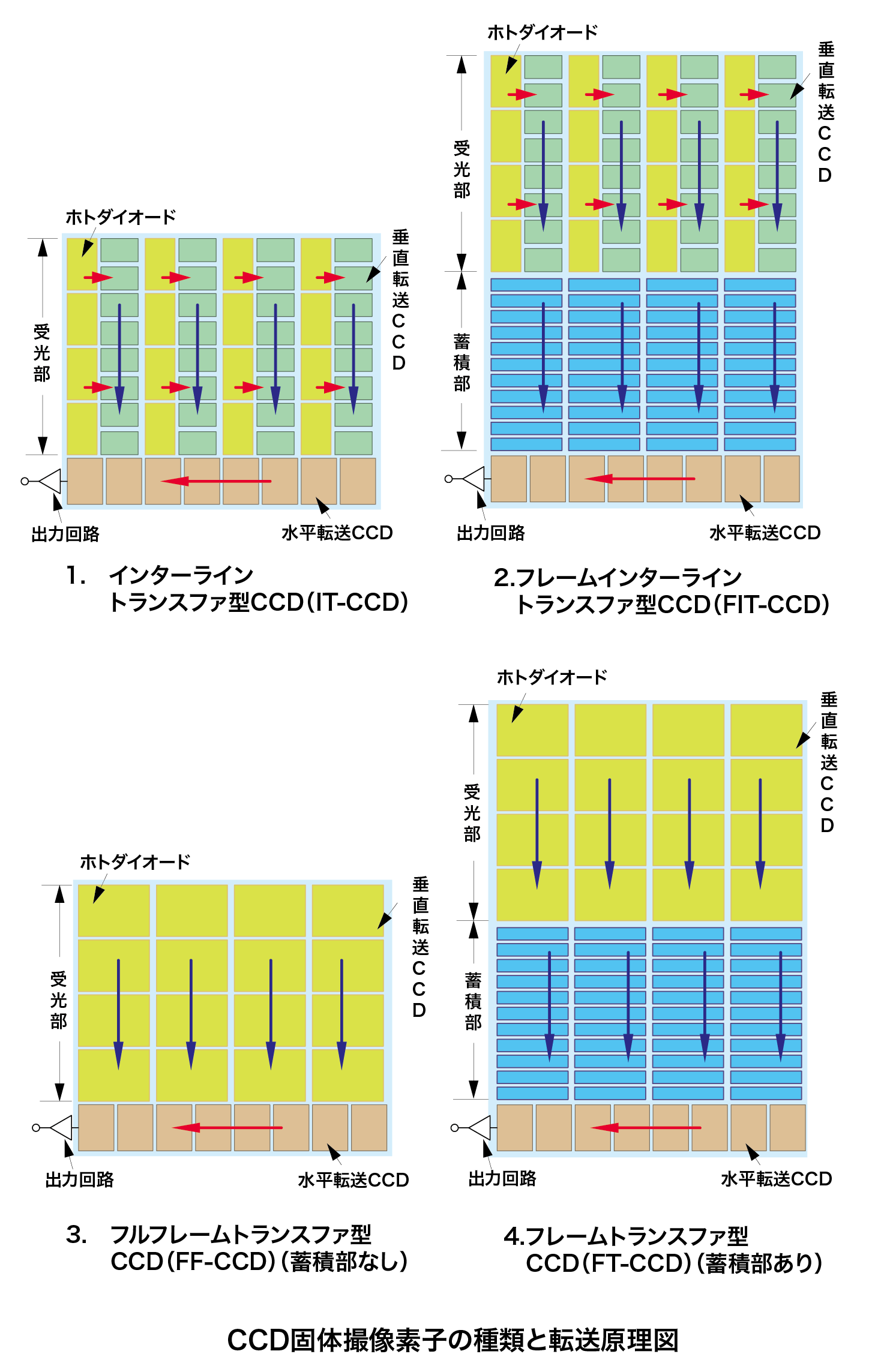

��CCD�����ǻҤμ����

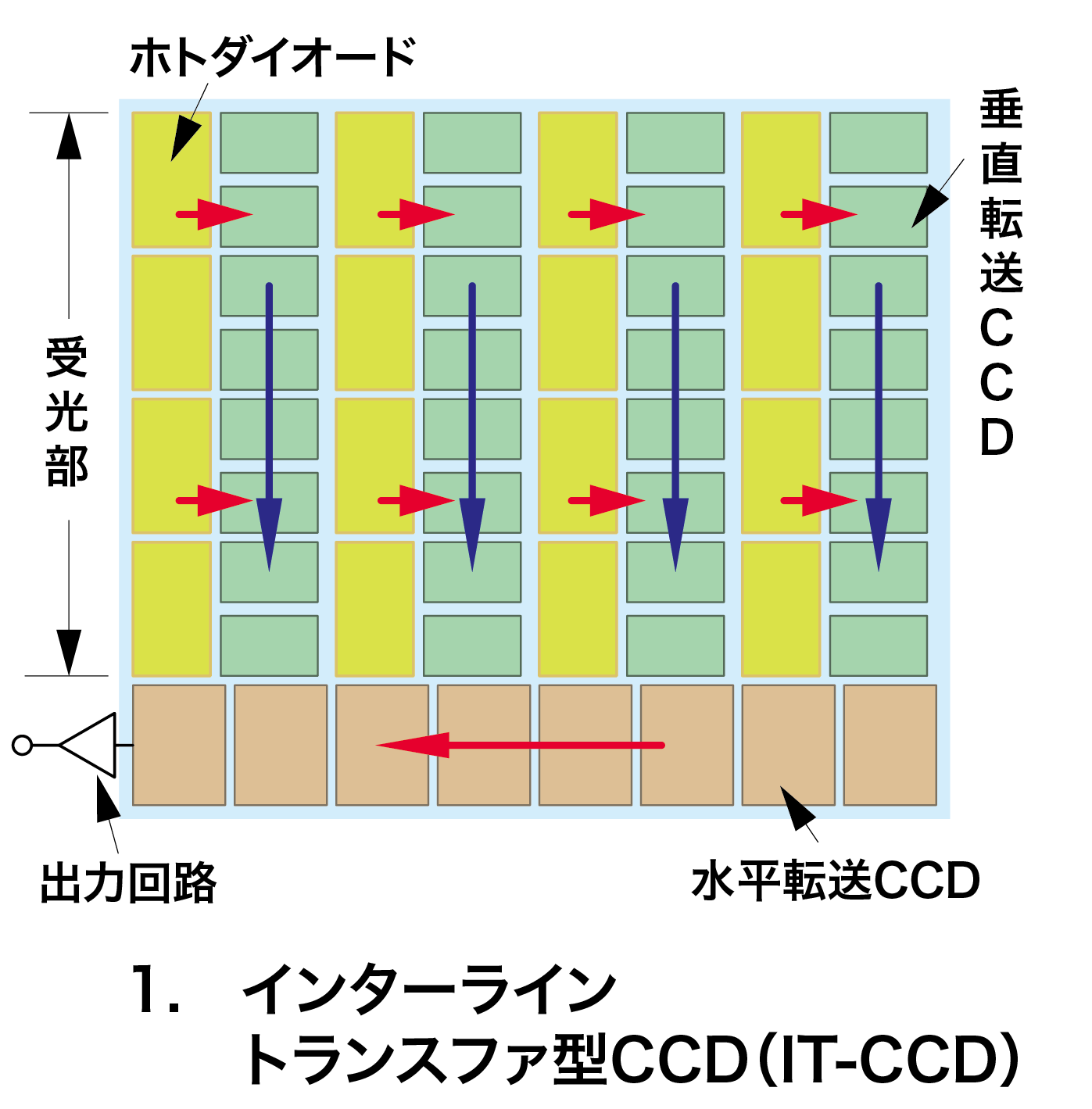

1.�������饤��ȥ�ե�������IT-CCD������-�������ߡ�����Ū�ʤ��

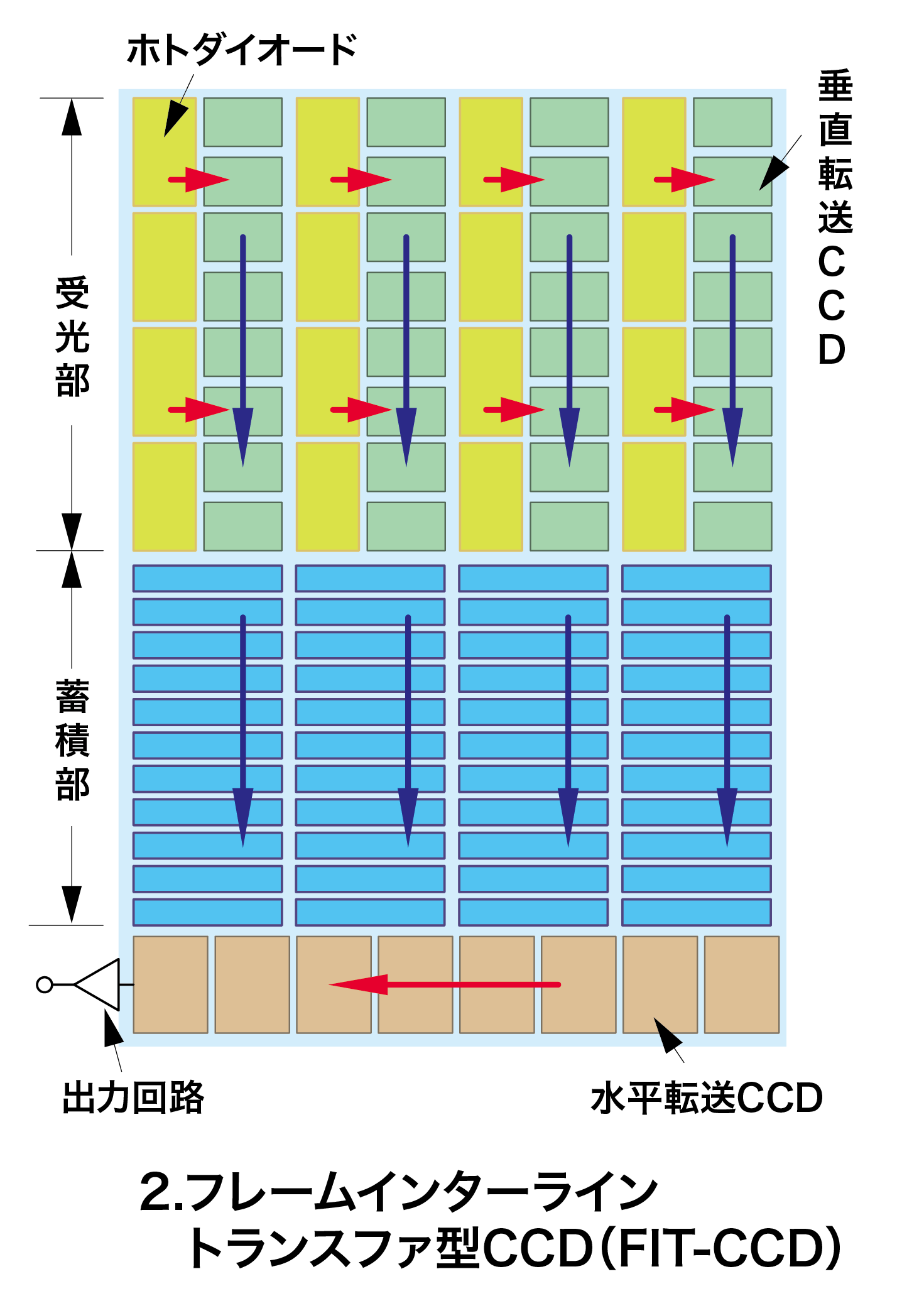

2.���ե졼�।���饤��ȥ�ե�������FIT-CCD����-���������ѤȤ��ƻȤ��Ƥ�����

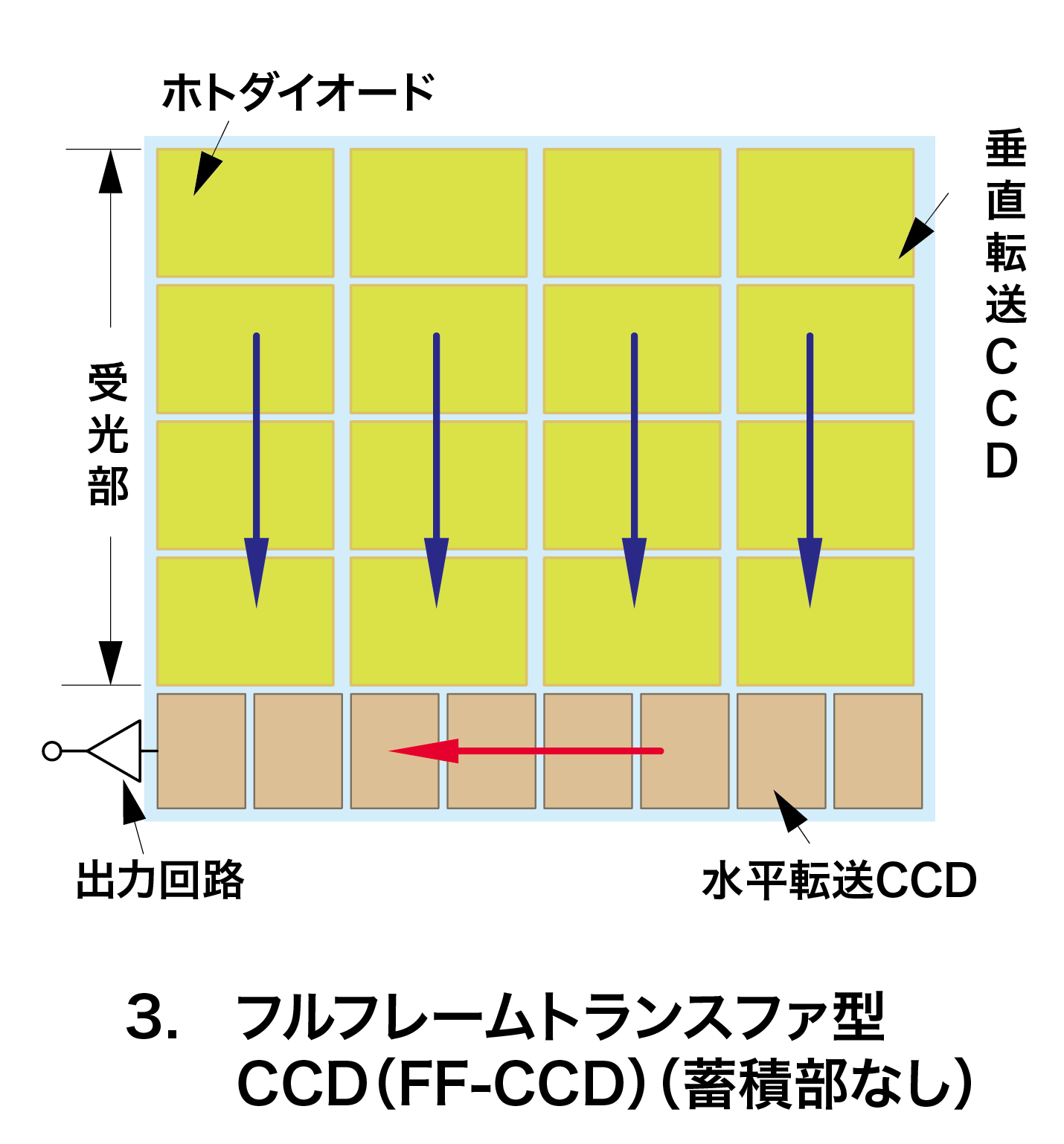

3.���ե�ե졼��ȥ�ե��������������ʤ��ˡ�FF-CCD����-��CCD�ν���Τ��

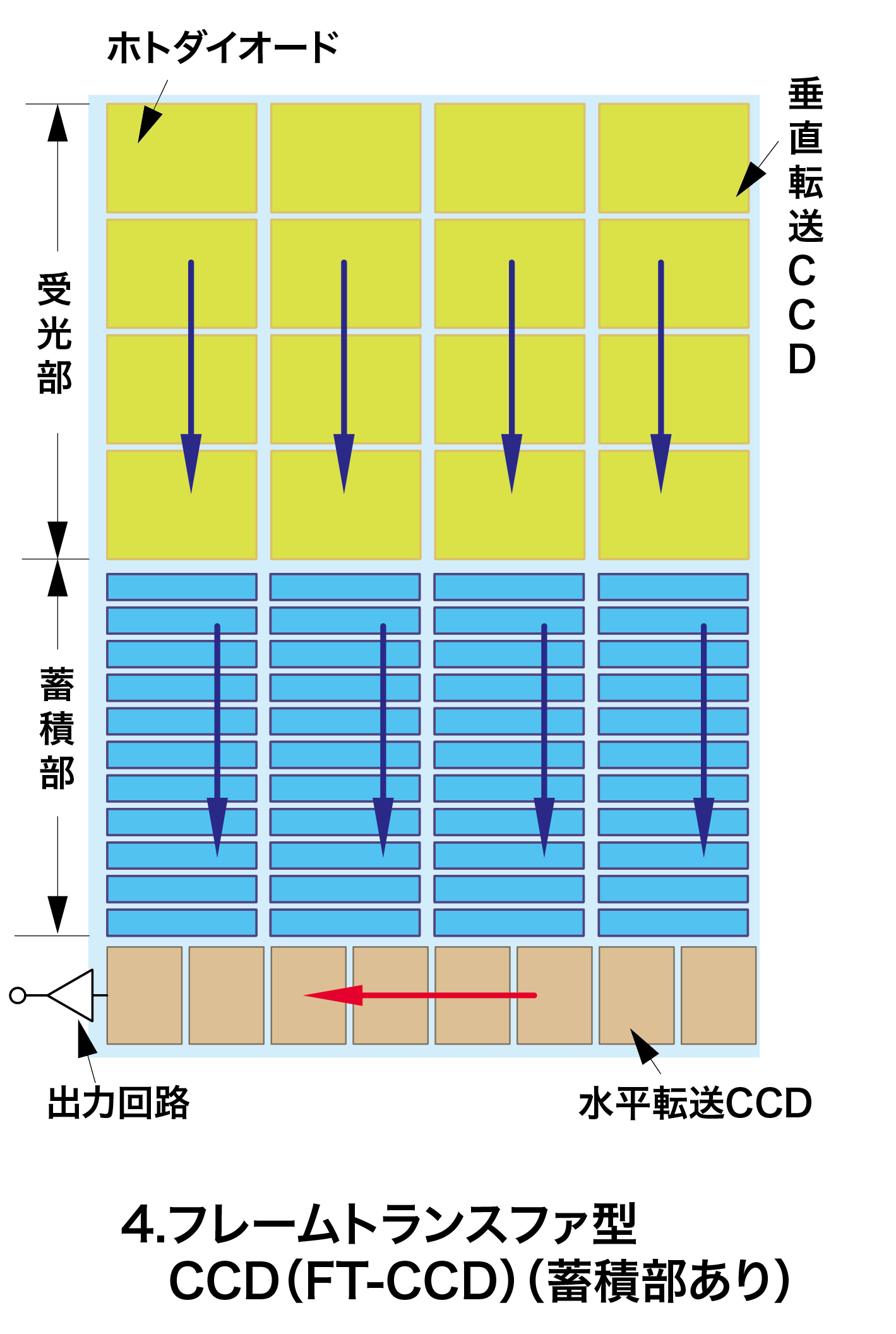

4.���ե졼��ȥ�ե�����������������ˡ�FT-CCD����-���ե졼��ȥ�ե����β�����

5.���������ɤ߽Ф��ʥץ�����å��֥������˷���-�������饤��ȥ�ե��β��ɷ��ʥ����졼����Ԥ�ʤ���Ρ�

��

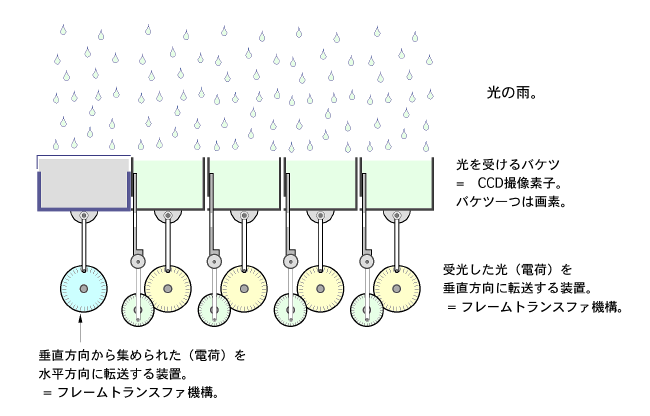

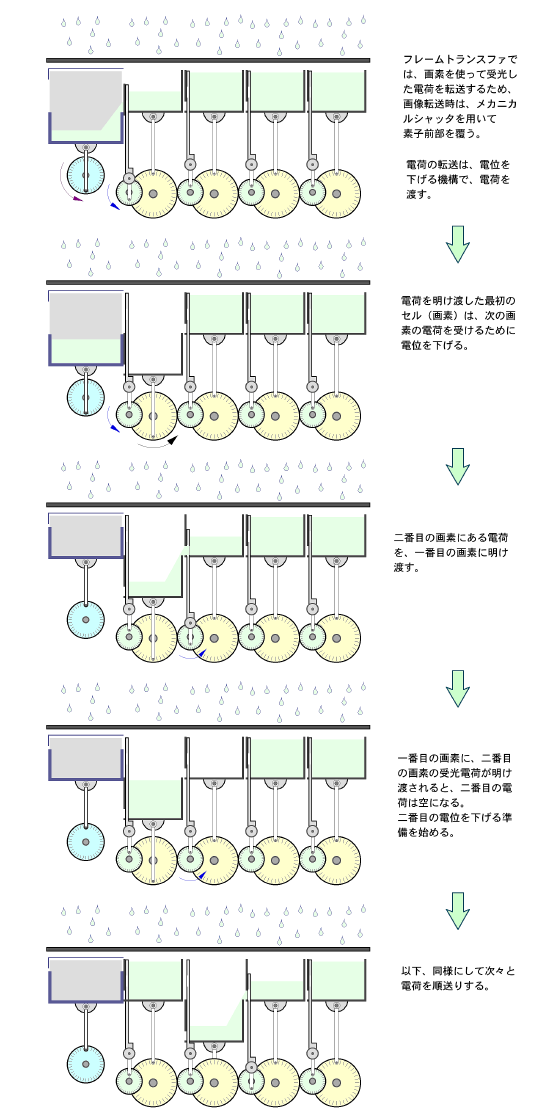

��¤������ץ�ʤΤǡ�CCD�λ��Ȥߤ�����ˤϰ����ɤ������פ��Ȼפ��ޤ���

��¤������ץ�ʤΤǡ�CCD�λ��Ȥߤ�����ˤϰ����ɤ������פ��Ȼפ��ޤ��� ��ž���λ��Ȥߡ�

��ž���λ��Ȥߡ� 1��β������ɤ߽Ф��Τ�2.6�ä����뤳�Ȥˤʤ�ޤ���

1��β������ɤ߽Ф��Τ�2.6�ä����뤳�Ȥˤʤ�ޤ��� 1.�Υ����饤��ȥ�ե�����CCD��IT-CCD�ˤϡ�CCD����̾��Ȥ�ƤФ����ɽŪ�ʤ�ΤǤ���

1.�Υ����饤��ȥ�ե�����CCD��IT-CCD�ˤϡ�CCD����̾��Ȥ�ƤФ����ɽŪ�ʤ�ΤǤ��� II.�Υե졼�।���饤��ȥ�ե�����CCD��FIT-CCD���ϡ������饤�Ǥ���ʤ�������������������CCD�Ǥ��ꡢ����Υ����饤��ꤵ��ʤ����ߥ��ʥ��ᥢ�������ɻߤΤ���˳�ȯ����ޤ�����

II.�Υե졼�।���饤��ȥ�ե�����CCD��FIT-CCD���ϡ������饤�Ǥ���ʤ�������������������CCD�Ǥ��ꡢ����Υ����饤��ꤵ��ʤ����ߥ��ʥ��ᥢ�������ɻߤΤ���˳�ȯ����ޤ�����

CCD�γ�ȯ����ˤ�Ҥ�Ȥ��Ƥߤޤ��ȡ�CCD�����ǻҳ�ȯ�ϥ��ߥ��ȥ֥롼�ߥȤ�Ʈ�����ä��褦�ʵ������ޤ���

CCD�γ�ȯ����ˤ�Ҥ�Ȥ��Ƥߤޤ��ȡ�CCD�����ǻҳ�ȯ�ϥ��ߥ��ȥ֥롼�ߥȤ�Ʈ�����ä��褦�ʵ������ޤ���

1990ǯ��ޤǤη�¬��CCD����������ȡ�CCD����ǽ����˥ե졼�����Ѥȥե���������ѤȤ�����ǽ����Ƥ��ޤ���

1990ǯ��ޤǤη�¬��CCD����������ȡ�CCD����ǽ����˥ե졼�����Ѥȥե���������ѤȤ�����ǽ����Ƥ��ޤ���

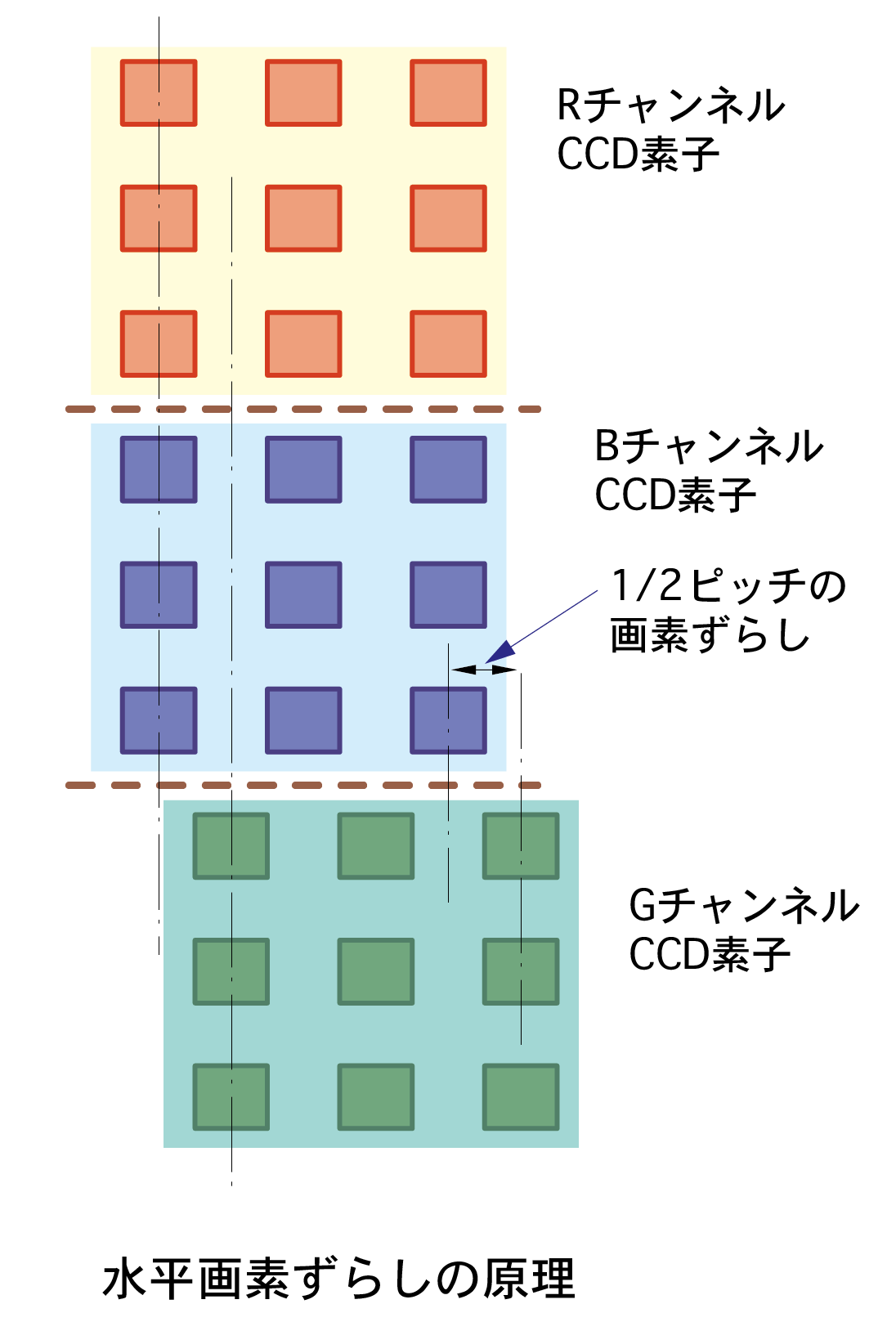

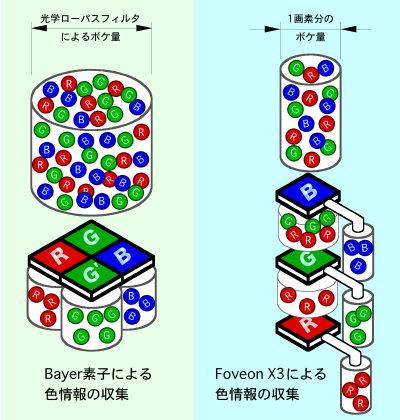

���顼���������Τ褦��2��ʾ�λ����ǻҤ���Ѥ��Ƥ����硢�����ǻҤ��ʿ������1/2����ʬ���餹�ȶ��־�����֤Ǥ��ƿ�ʿ�����٤�夲�뤳�Ȥ��Ǥ��ޤ���

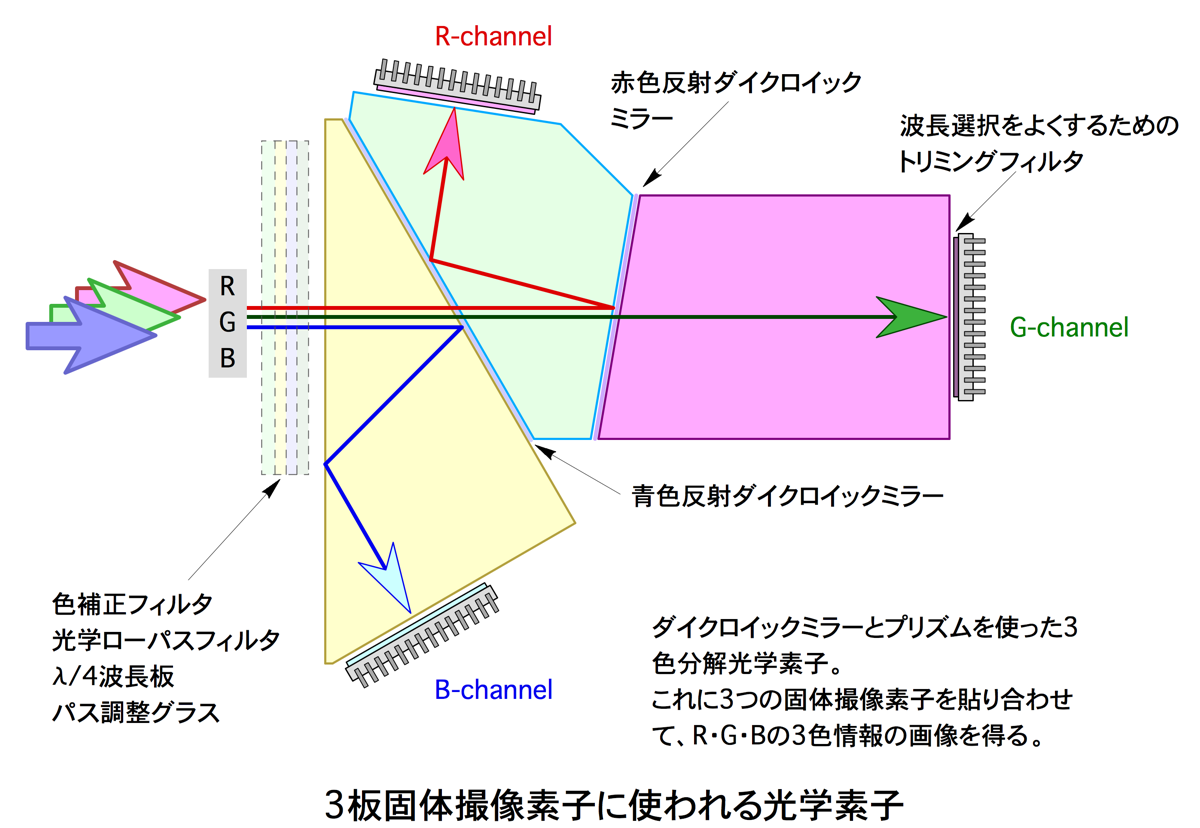

���顼���������Τ褦��2��ʾ�λ����ǻҤ���Ѥ��Ƥ����硢�����ǻҤ��ʿ������1/2����ʬ���餹�ȶ��־�����֤Ǥ��ƿ�ʿ�����٤�夲�뤳�Ȥ��Ǥ��ޤ��� ���Υ쥤�����ȤǤϡ�3�Ĥ�CCD�ǻҤ�Ȥäƥ��顼�����R.G.B.�ˤ����Ƥ��ޤ���

���Υ쥤�����ȤǤϡ�3�Ĥ�CCD�ǻҤ�Ȥäƥ��顼�����R.G.B.�ˤ����Ƥ��ޤ���

���顼�����Υ������ɥå����ʤ�Τϡ���˽Ҥ٤�3��CCD�����Ǥ���

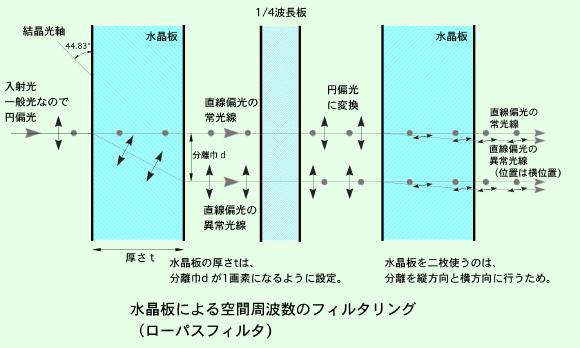

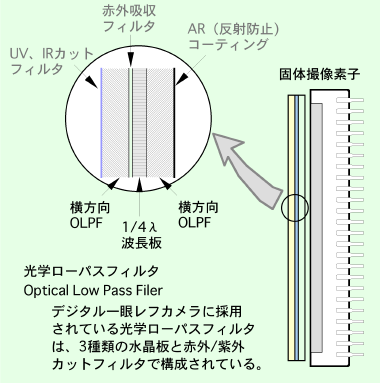

���顼�����Υ������ɥå����ʤ�Τϡ���˽Ҥ٤�3��CCD�����Ǥ��� CCD�ʤɤθ��λ����ǻҤ��Ѥ�����⥢������к��Ǥϡ��徽�ˤ��뾽�ĤǺ��줿�����ѥ��ե��륿��Low Pass Filter�ˤ����ǻ��̤����˼���դ�����ˡ���Ǥ����Ū�Ǥ���

CCD�ʤɤθ��λ����ǻҤ��Ѥ�����⥢������к��Ǥϡ��徽�ˤ��뾽�ĤǺ��줿�����ѥ��ե��륿��Low Pass Filter�ˤ����ǻ��̤����˼���դ�����ˡ���Ǥ����Ū�Ǥ���

|

||||||

|

||||||

|

||||||

| ���͡�Richard F. Lyon, Paul M. Hubel, Foveon, Inc. ,"Eyeing the Camera: into the Next Century", 2003 | Bayer�ǻҤ�ʿ��Ū�˿�������������Τ��Ф���Foveon�Ͽ�ľ�˿������������롣���äơ�Foveon�Ͽ��Τˤ��ߤ��ʤ��� | |||||

����ϥܡ�����Niels Henrik David Bohr��1885.10��1962.11���ǥ�ޡ�����ʪ���ؼԡ�1922ǯ�Ρ��٥�ʪ���ؾ���) ���ͤ��������ǡ��ŻҤϸ��ҳˤβ������ε�ƻ�Dz�ꡢ�������饨�ͥ륮�������Ȱ�ij��ε�ƻ�˰ܤꡢ�ޤ������ͥ륮�������Ф���Ȥ�����¦�ε�ƻ�˰ܤ�Ȥ�����ΤǤ���

����ϥܡ�����Niels Henrik David Bohr��1885.10��1962.11���ǥ�ޡ�����ʪ���ؼԡ�1922ǯ�Ρ��٥�ʪ���ؾ���) ���ͤ��������ǡ��ŻҤϸ��ҳˤβ������ε�ƻ�Dz�ꡢ�������饨�ͥ륮�������Ȱ�ij��ε�ƻ�˰ܤꡢ�ޤ������ͥ륮�������Ф���Ȥ�����¦�ε�ƻ�˰ܤ�Ȥ�����ΤǤ���

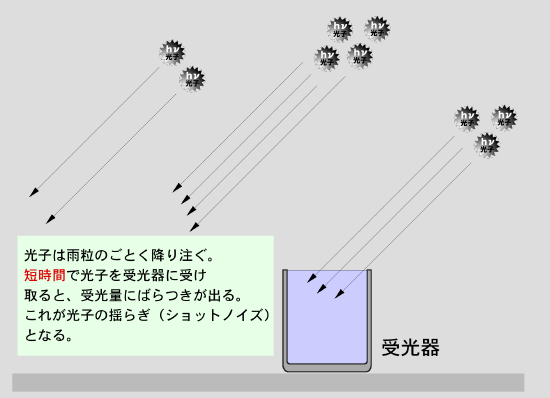

����åȥΥ����ϡ�Ķ�ⴶ�٥�����Ȥäơ����Ūû���֤�Ϫ���Dz�����Ȥ館�������Ω���ޤ����ⴶ�٥����ϡ����Τ�����ҿ������ʤ��ΤǤ����������ݤ������˸���ޤ���

����åȥΥ����ϡ�Ķ�ⴶ�٥�����Ȥäơ����Ūû���֤�Ϫ���Dz�����Ȥ館�������Ω���ޤ����ⴶ�٥����ϡ����Τ�����ҿ������ʤ��ΤǤ����������ݤ������˸���ޤ���

N �� ���Nr2 + Nd2 + Ns2 �ˡ�����������Rec -15��

�����ӥ�˥�Binning)������2008.05.15)

�����ӥ�˥�Binning)������2008.05.15)

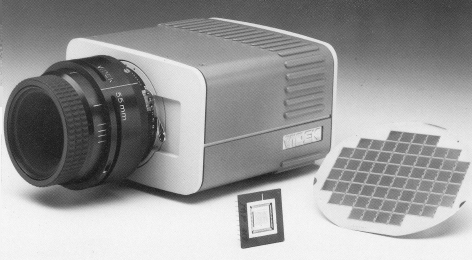

���Υ�����̾���ϡ��ᥬ�ԥ������100�����ǡˤ�ο���������Ȥ������Ȥ���֥ᥬ�ץ饹��Megaplus�ˡפȸƤФ�ޤ�����

���Υ�����̾���ϡ��ᥬ�ԥ������100�����ǡˤ�ο���������Ȥ������Ȥ���֥ᥬ�ץ饹��Megaplus�ˡפȸƤФ�ޤ�����

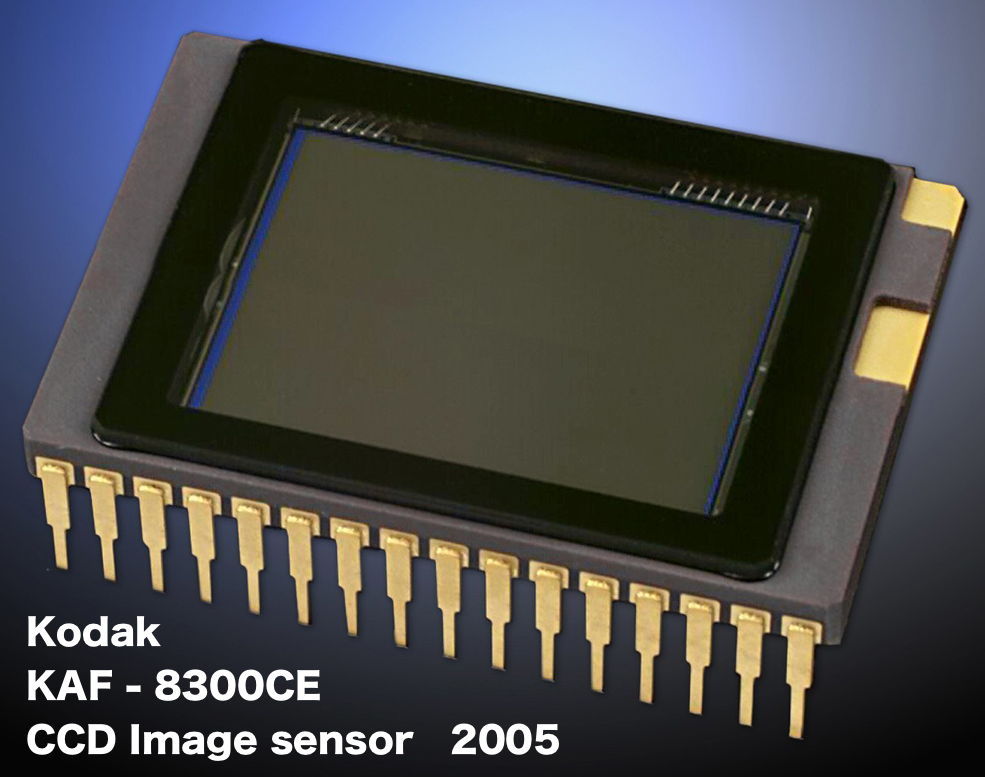

�Х��ǥå��˻Ȥ�줿CCD���ե�ե졼��ȥ�ե���CCD���λ����ǻҤǤ���

�Х��ǥå��˻Ȥ�줿CCD���ե�ե졼��ȥ�ե���CCD���λ����ǻҤǤ���

��¬��CCD�����Ͽʲ���뤲��1990ǯ���Ⱦ�ˤ�4,000x4,000���ǤΥ���餬�о줷�ޤ�����

��¬��CCD�����Ͽʲ���뤲��1990ǯ���Ⱦ�ˤ�4,000x4,000���ǤΥ���餬�о줷�ޤ����� 2005ǯ�ˡ��������CCD�����Ȥ��ơ����˼����褦���Ż���ѷ�����餬���ʲ�����ޤ�����

2005ǯ�ˡ��������CCD�����Ȥ��ơ����˼����褦���Ż���ѷ�����餬���ʲ�����ޤ�����

CCD��ž����100ns��1000��ʬ��1�áˤ��³��ȸ����Ƥ��ޤ����顢�������40�ܤ�®������ʤ��ƤϤʤ�ޤ���

CCD��ž����100ns��1000��ʬ��1�áˤ��³��ȸ����Ƥ��ޤ����顢�������40�ܤ�®������ʤ��ƤϤʤ�ޤ��� �Ȥ�����ħ����äƤ��ޤ�����

�Ȥ�����ħ����äƤ��ޤ����� �̾��CCD���λ����ǻҤȤϼ��ۤˤ������ʳ��Ѥη�¬CCD�ǻҤ����Ƥ��ޤ���

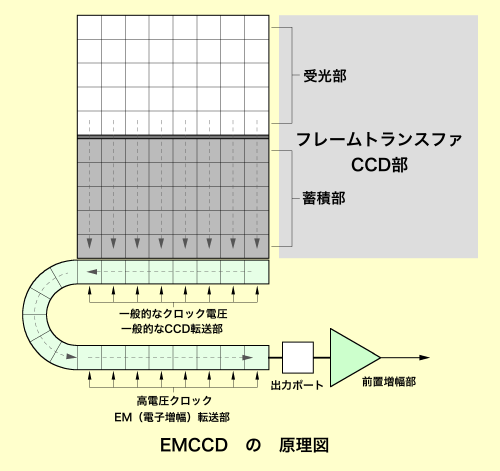

�̾��CCD���λ����ǻҤȤϼ��ۤˤ������ʳ��Ѥη�¬CCD�ǻҤ����Ƥ��ޤ��� EMCCD��Electron Multiplying CCD�ˤȸƤФ����λ����ǻҤϡ�CCD����֤����ꡢ���˴��٤ι⤤�����ǻҤǤ���

EMCCD��Electron Multiplying CCD�ˤȸƤФ����λ����ǻҤϡ�CCD����֤����ꡢ���˴��٤ι⤤�����ǻҤǤ��� |

|||||

|

|

||||

|

|||||

��

��

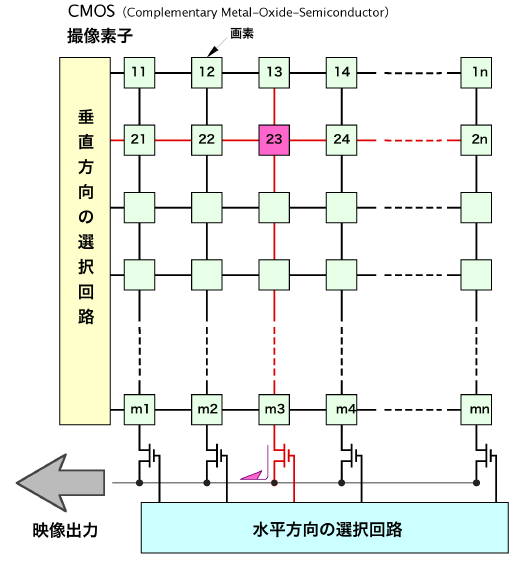

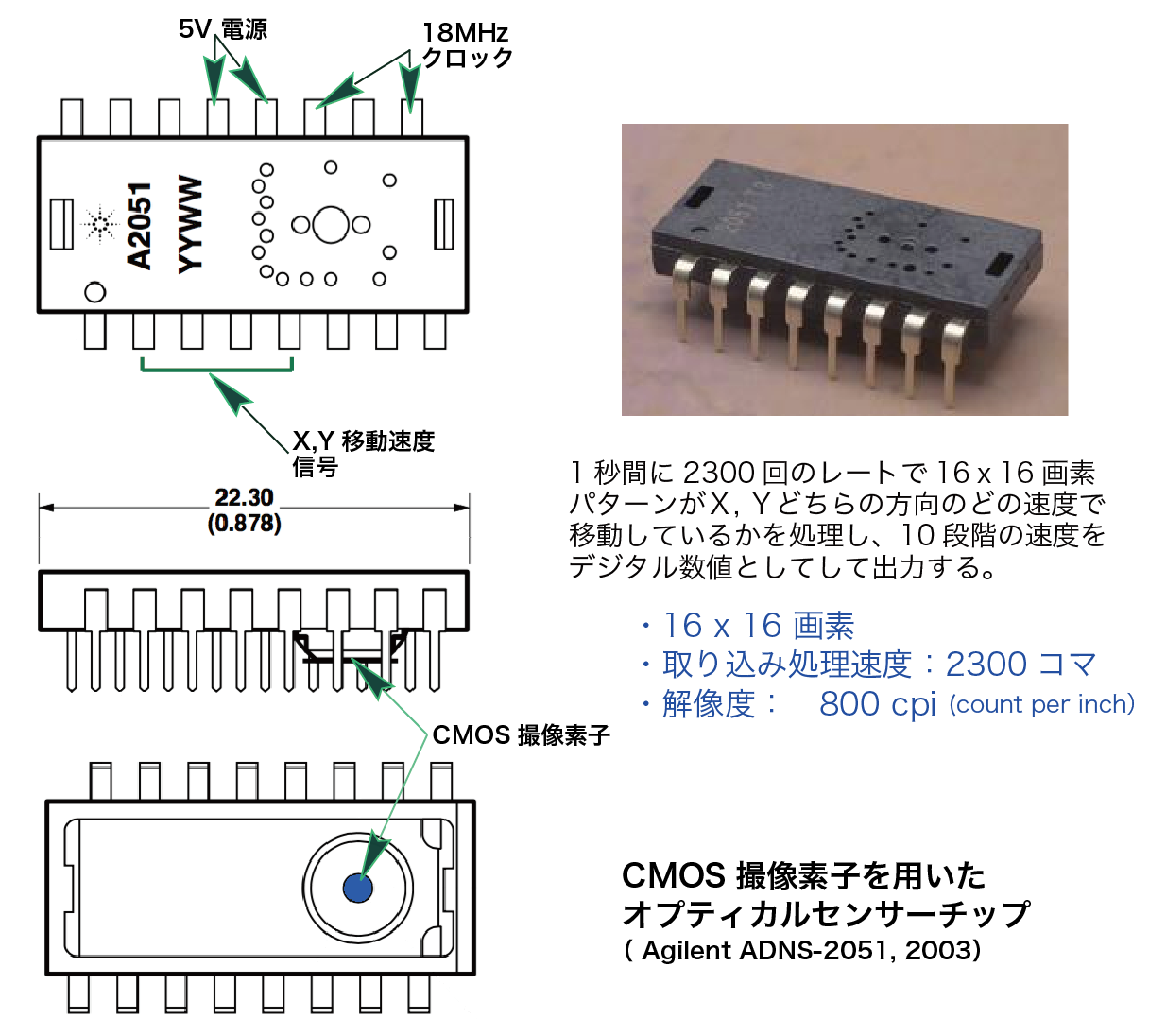

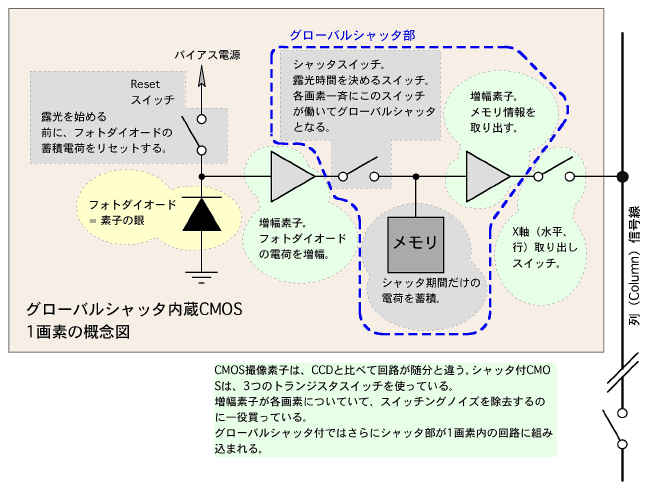

��ϡ�CMOS�ǻҤ����������¢������CMOS APS��CMOS Active Pixel Sensor�˻����ǻҤ�ȯ���ޤ�����

��ϡ�CMOS�ǻҤ����������¢������CMOS APS��CMOS Active Pixel Sensor�˻����ǻҤ�ȯ���ޤ����� �ޤ���CMOS�����ϥ����δ�Ȥ��ƤǤϤʤ�����ԥ塼���˻Ȥ�����إޥ����Υ����Ȥ������Ѥ���Ƥ��ޤ���

�ޤ���CMOS�����ϥ����δ�Ȥ��ƤǤϤʤ�����ԥ塼���˻Ȥ�����إޥ����Υ����Ȥ������Ѥ���Ƥ��ޤ���

|

||||||||||||||||||||||||||||||||

|

||||||||||||||||||||||||||||||||

��¬��CMOS�����ǻҤǤϡ��Żҥ���å���¢�Τ�Τ�����Ū�ˤʤäƤ��ޤ���

��¬��CMOS�����ǻҤǤϡ��Żҥ���å���¢�Τ�Τ�����Ū�ˤʤäƤ��ޤ���

��

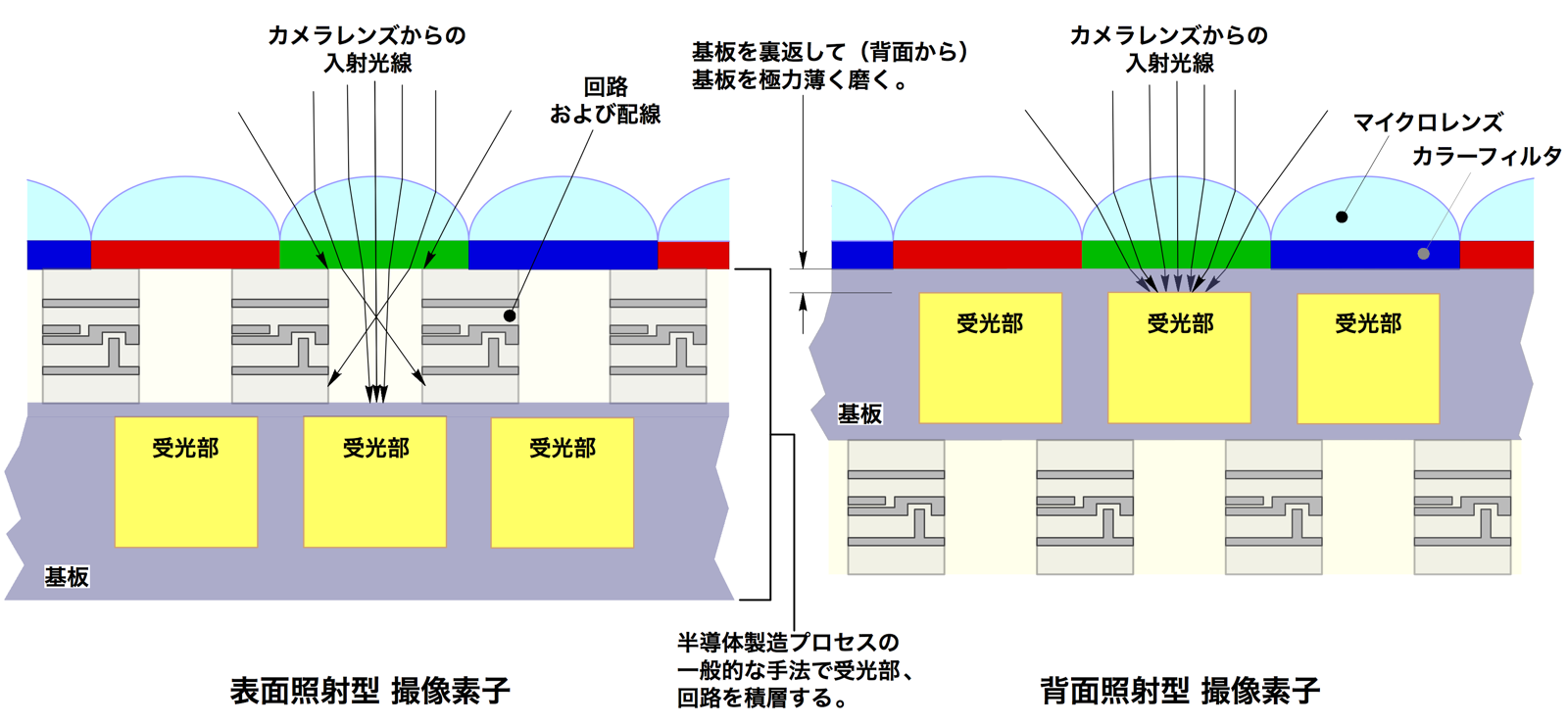

���̾ȼͷ������ǻҤϡ����ޤ˼����褦�˼������������������֤����������Ȳ�ϩ�ǻҤ��������֤��������ǻҤǤ���

���̾ȼͷ������ǻҤϡ����ޤ˼����褦�˼������������������֤����������Ȳ�ϩ�ǻҤ��������֤��������ǻҤǤ���

|

|||||

|

|||

�� ![]()

|

|

||||||

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

��

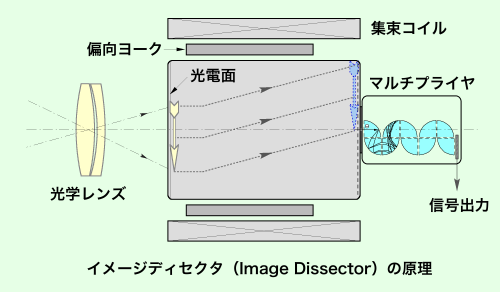

�����ѻ����ɤϡ��ƥ�ӥ����θ���Ū¸�ߤΤ�Τǡ�1931ǯ���ƹ��Farnsworth��1906 - 1971�ˤˤ�äƥ�����ǥ���������Image Dissector�ˤȸƤФ�뻣���ɤ���ȯ����ޤ�����

�����ѻ����ɤϡ��ƥ�ӥ����θ���Ū¸�ߤΤ�Τǡ�1931ǯ���ƹ��Farnsworth��1906 - 1971�ˤˤ�äƥ�����ǥ���������Image Dissector�ˤȸƤФ�뻣���ɤ���ȯ����ޤ����� |

|||

|

|||

|

||||||

|

||||||

|

||||||

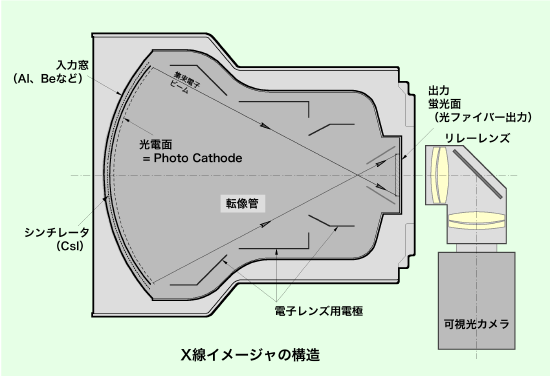

X���������ϡ��ʲ���3�Ĥ����̤�������Ω�äƤ��ޤ������ʤ����

|

||||

|

||||

|

||||

���˼������ޤϡ���3����ζ��ܷ����������ƥե���������ե����С���CCD�ǻҤȥ��ץ�����ⴶ�٥����ι�¤�ޤǤ���

���˼������ޤϡ���3����ζ��ܷ����������ƥե���������ե����С���CCD�ǻҤȥ��ץ�����ⴶ�٥����ι�¤�ޤǤ��� ������ˤ��Ƥ⡢��������Τ������ʬ��ȼ�������ϰ������Ȥ��Ǥ��ޤ���

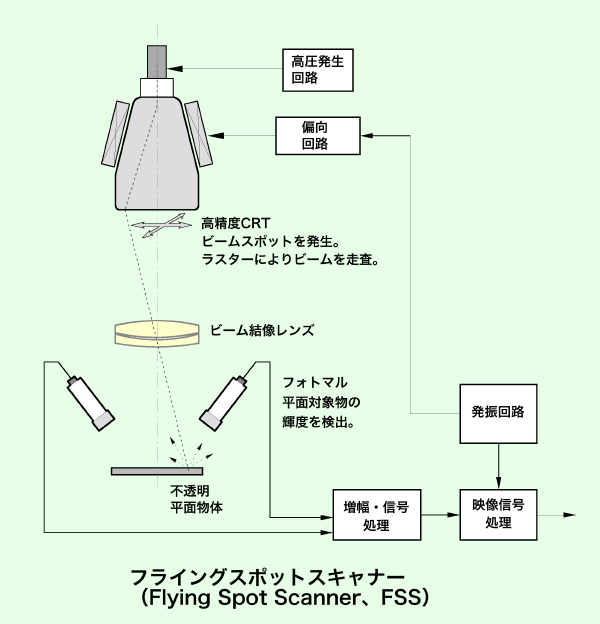

������ˤ��Ƥ⡢��������Τ������ʬ��ȼ�������ϰ������Ȥ��Ǥ��ޤ��� �������ŻҸ������θ����ե饤�����ݥåȡ�������ʡ���FSS�ˤ˸��뤳�Ȥ��Ǥ��ޤ���

�������ŻҸ������θ����ե饤�����ݥåȡ�������ʡ���FSS�ˤ˸��뤳�Ȥ��Ǥ��ޤ�����

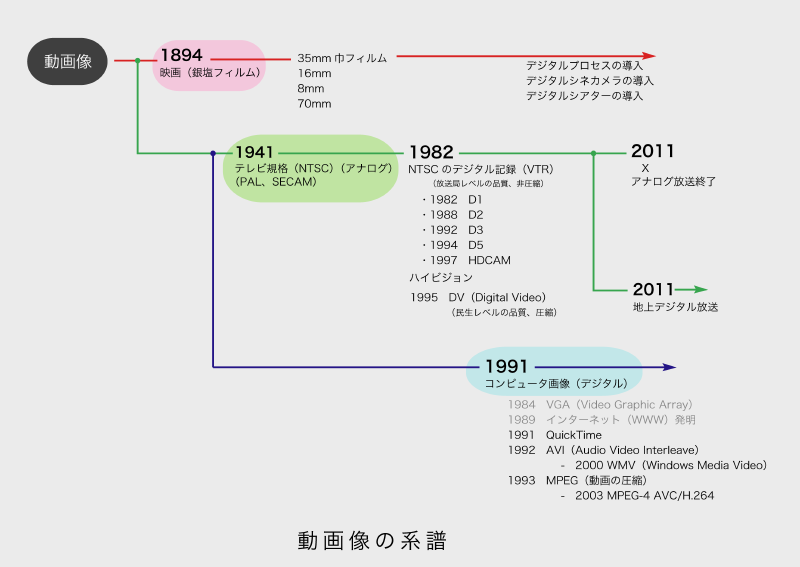

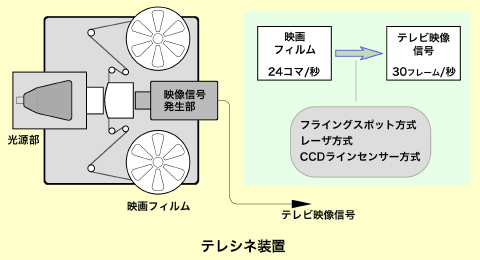

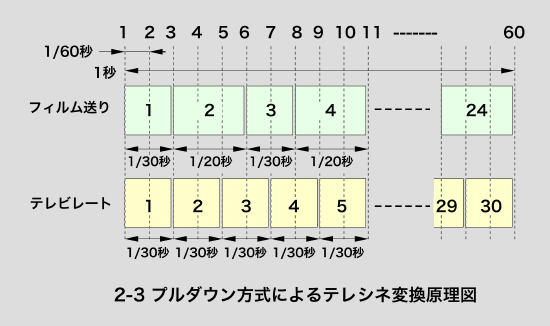

�ƥ쥷�����֤Ȥϡ��Dz�ե�����ƥ�ӿ�����Ѵ��������֤Ǥ���

�ƥ쥷�����֤Ȥϡ��Dz�ե�����ƥ�ӿ�����Ѵ��������֤Ǥ��� �ƥ쥷�ͤαǼ̵��Ǥϡ�1�����ܤ�2�����ܤ��ϡ�

�ƥ쥷�ͤαǼ̵��Ǥϡ�1�����ܤ�2�����ܤ��ϡ�

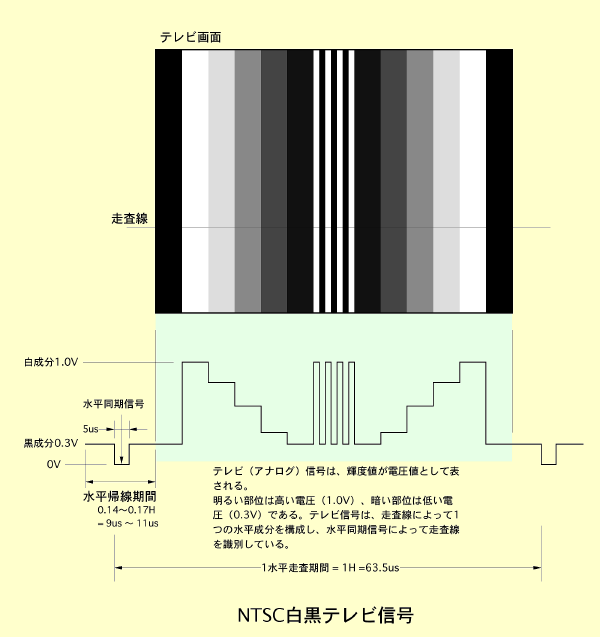

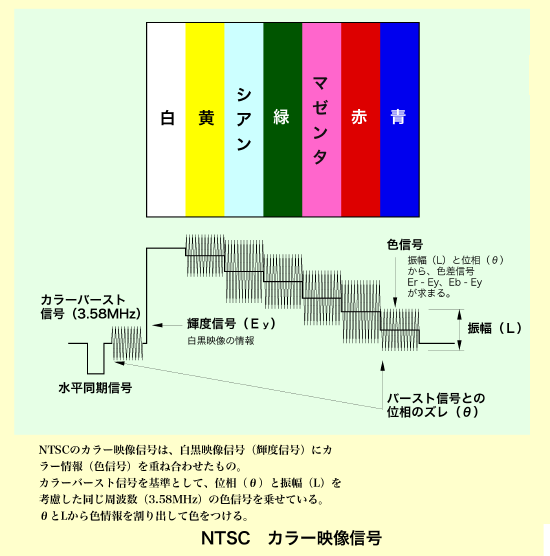

NTSC�ϡ�1941ǯ������Υƥ�ӥ�����������ʤ��Ǥ��Ф��ޤ���

NTSC�ϡ�1941ǯ������Υƥ�ӥ�����������ʤ��Ǥ��Ф��ޤ��� |

|||

|

|||

��

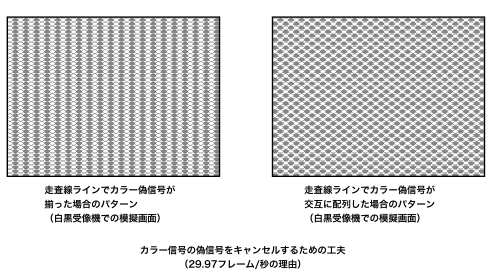

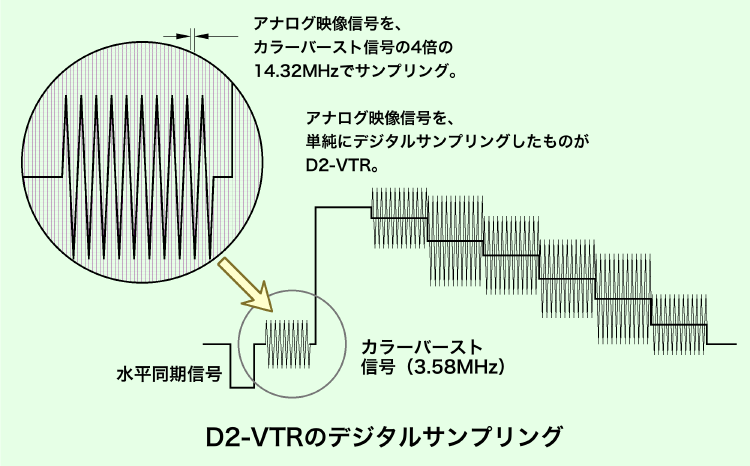

������졢�����͡�3.58 MHz�ˤ����С����ȿ�����ȿ���fs�ˤκ���Ȥʤ�ޤ�����

������졢�����͡�3.58 MHz�ˤ����С����ȿ�����ȿ���fs�ˤκ���Ȥʤ�ޤ����� |

||||

|

||||

��

��

|

||||

|

||||

|

|||||

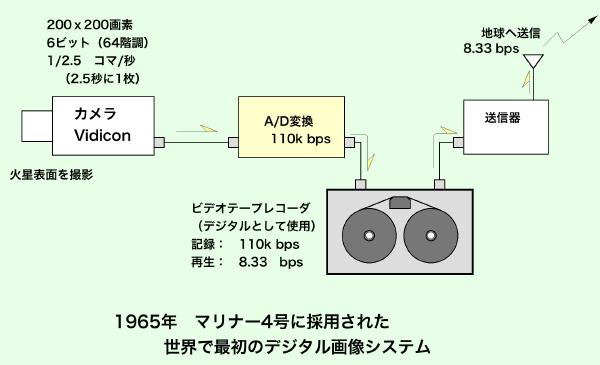

����õ�������ޥ�ʡ�4���Mariner 4�ˤ���ܤ��줿�����ϡ��ե���५���ǤϤʤ������������Τ���ʤ��ƥ�ӥ����Ǥ�����

����õ�������ޥ�ʡ�4���Mariner 4�ˤ���ܤ��줿�����ϡ��ե���५���ǤϤʤ������������Τ���ʤ��ƥ�ӥ����Ǥ�����

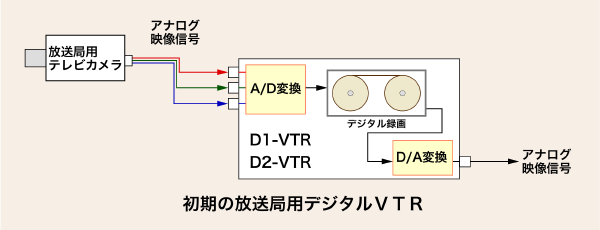

�����ǥ�����VTR��Digital Video Tape Recorder��

�����ǥ�����VTR��Digital Video Tape Recorder��

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

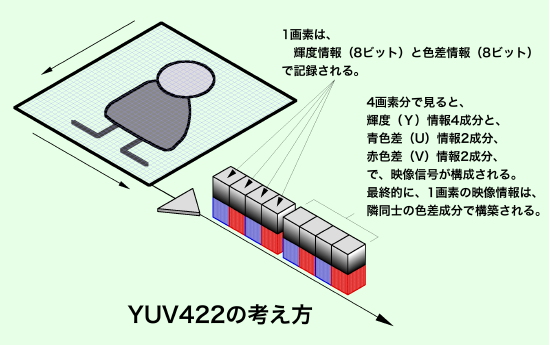

�ǥ����뿮��Ǥ���4:2:2����ݡ��ͥ�ȥǥ����뿮��ˤ����Ƥ⡢�����դ�����ˡ�ϥ��ʥ��������Ʊ���褦����������Ѥ������ٿ���ȿ������椫�鹽����������������ꡢ�٤������̤��Ф��ƤϿ����դ��ʤ���ˡ����Ѥ��ޤ�����

�ǥ����뿮��Ǥ���4:2:2����ݡ��ͥ�ȥǥ����뿮��ˤ����Ƥ⡢�����դ�����ˡ�ϥ��ʥ��������Ʊ���褦����������Ѥ������ٿ���ȿ������椫�鹽����������������ꡢ�٤������̤��Ф��ƤϿ����դ��ʤ���ˡ����Ѥ��ޤ�����

��

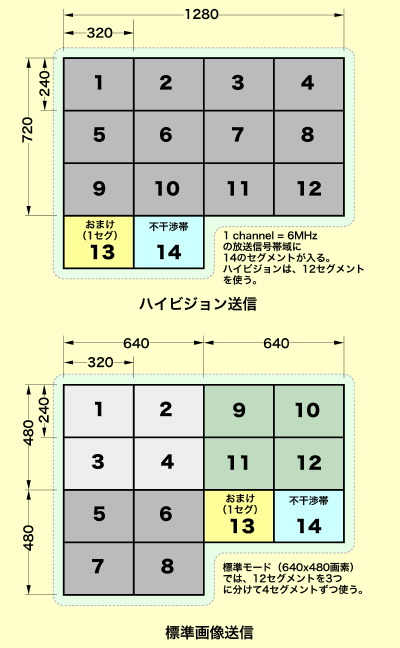

������������������Segment Broadcasting������2009.02.03�ɵ���

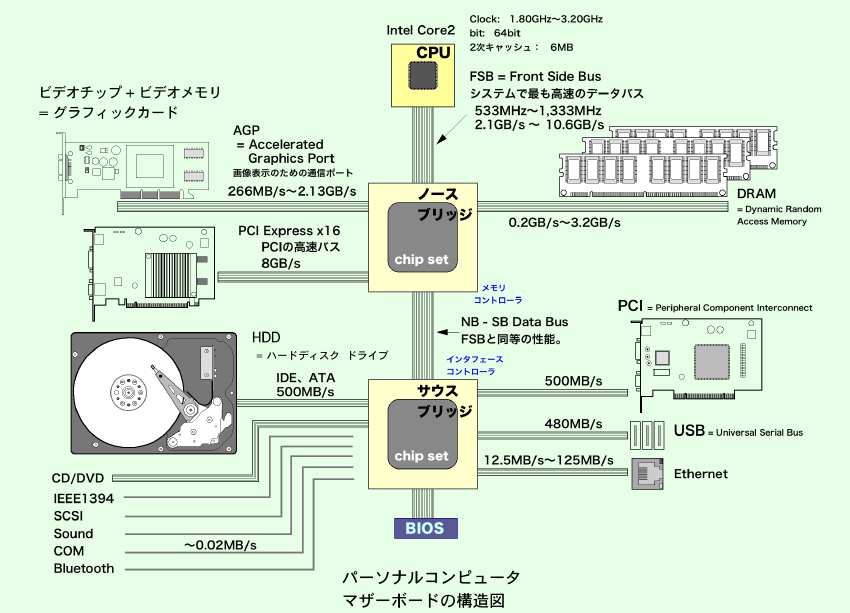

������������������Segment Broadcasting������2009.02.03�ɵ��� �����ܡ��ɤǥǥ�����������Ѵ����줿�ǡ����ϡ�����ԥ塼���Υǡ����Х��ˤ�äơ��������֡ʥץ����å��ˤ�DRAM�������ޤ���

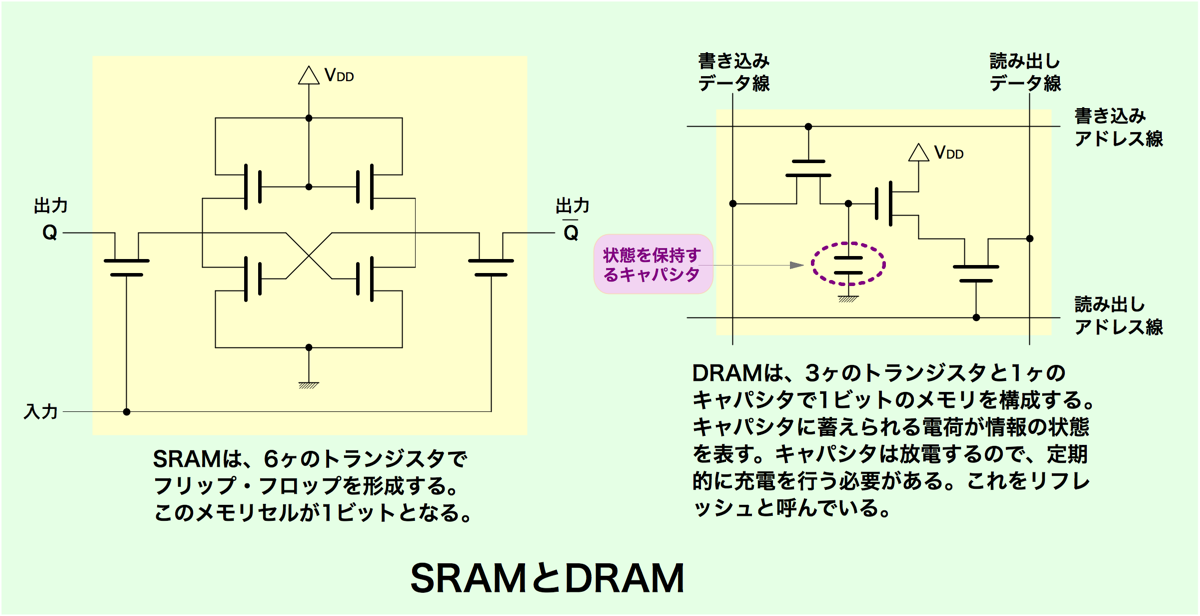

�����ܡ��ɤǥǥ�����������Ѵ����줿�ǡ����ϡ�����ԥ塼���Υǡ����Х��ˤ�äơ��������֡ʥץ����å��ˤ�DRAM�������ޤ���

|

|||

|

|||

�ƹ�β��������������RCA��Radio Corporation of America�˼Ҥ���1940ǯ��˳�ȯ���������������³ü�����ͥ�����RCA���ͥ����ʱ��̿������Ѽ��ȿ��� 10M Hz�ˤȸƤ�Ǥ��ޤ���

�ƹ�β��������������RCA��Radio Corporation of America�˼Ҥ���1940ǯ��˳�ȯ���������������³ü�����ͥ�����RCA���ͥ����ʱ��̿������Ѽ��ȿ��� 10M Hz�ˤȸƤ�Ǥ��ޤ���

|

|

|

||||||||

|

||||||||||

|

|

|||||||||

|

|||||

|

|||||

|

|||||

��

��

��

��

��

|

||||

�̿�����Miikka Raninen��

|

||||

��

�⤤���ȿ��ο�����֥�������硢�����֥�ϰʲ�������ʬ������ޤ��� ��

�⤤���ȿ��ο�����֥�������硢�����֥�ϰʲ�������ʬ������ޤ��� ��

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

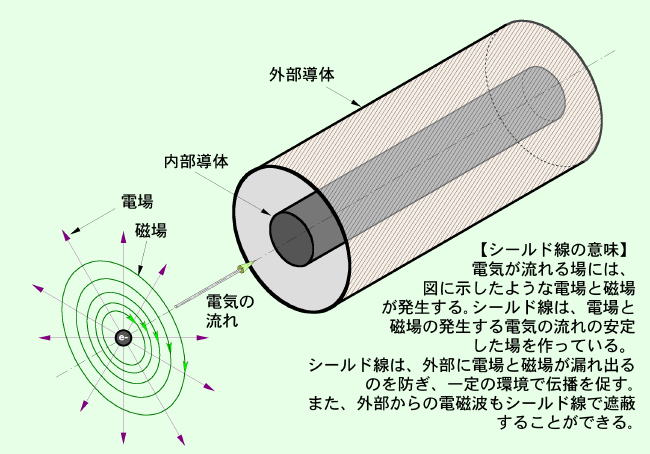

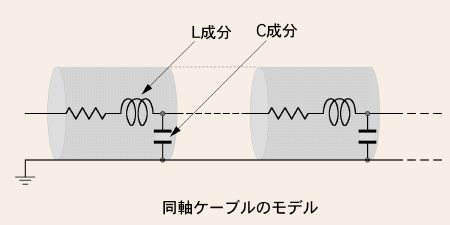

Ʊ�������֥��3C-2V��10C-2V�ˤ�����ɽ��

��ʬ�����դ�ʧ�ä�����Ǥϡ�����������Ʊ�������֥����ͥ��Ƥ��ޤ���

��ʬ�����դ�ʧ�ä�����Ǥϡ�����������Ʊ�������֥����ͥ��Ƥ��ޤ�����

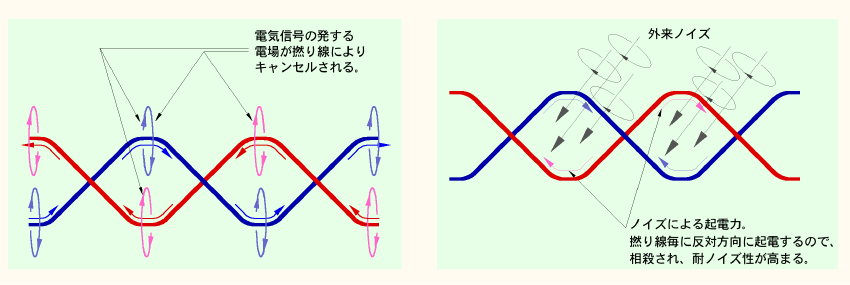

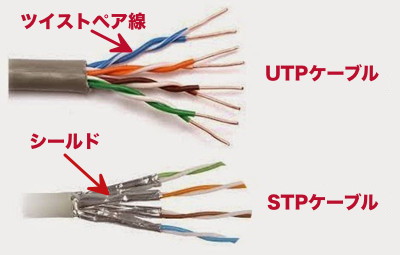

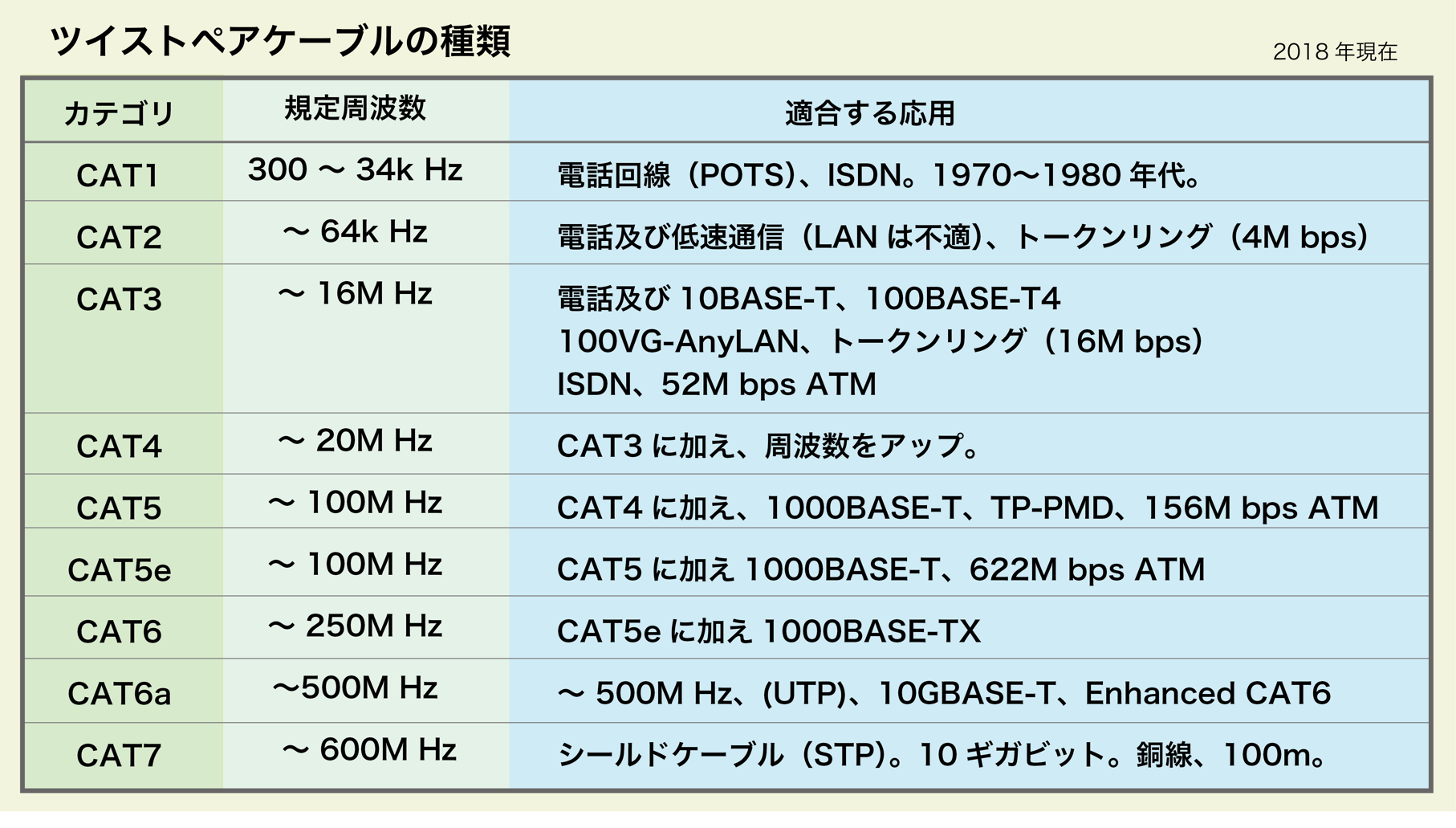

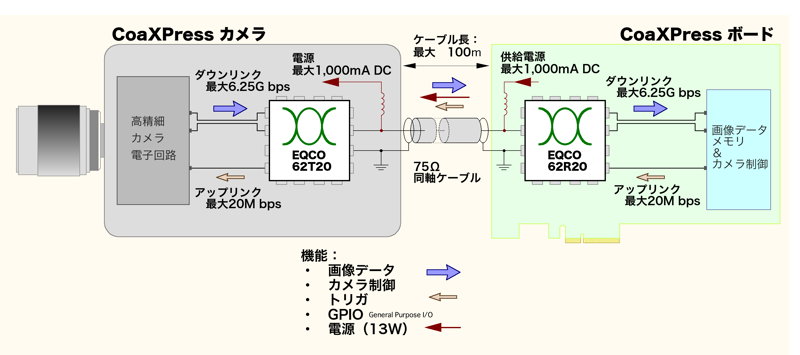

�ĥ����ȥڥ������֥�ϡ�����Ū�˥Υ����˶�����������äƤ��ޤ���������Ǥ⳰��������ż��Υ��������ۤ������ˡ������֥����Τ���ɽ��������ĥ����ȥڥ������֥��Ȥ����Ȥ�����ޤ���

�ĥ����ȥڥ������֥�ϡ�����Ū�˥Υ����˶�����������äƤ��ޤ���������Ǥ⳰��������ż��Υ��������ۤ������ˡ������֥����Τ���ɽ��������ĥ����ȥڥ������֥��Ȥ����Ȥ�����ޤ��� |

||||

|

||||

��

��

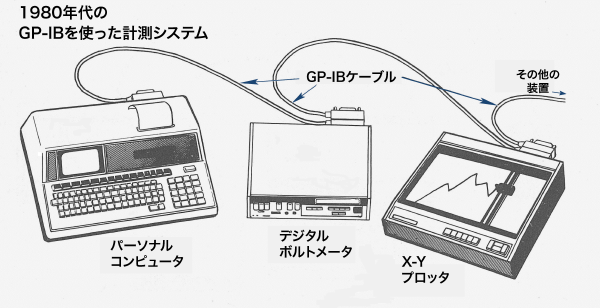

COM�Ȥ����Τϡ�Communication���̿��ˤ�ά�ǡ��̿��ݡ��Ȥΰ�̣�Ǥ���

COM�Ȥ����Τϡ�Communication���̿��ˤ�ά�ǡ��̿��ݡ��Ȥΰ�̣�Ǥ��� �������ץ顼�ȸƤФ�����֡����äμ��ô�ˤ��ФΤ褦�ʤ�Τ����դ��ơ�FAX������ݤΥ�����/��������Τ褦�ʲ����ǥǥ������̿���Ԥä����֡ˤ⡢����RS232C���ʤ���Ѥ��Ƥ��ޤ�����

�������ץ顼�ȸƤФ�����֡����äμ��ô�ˤ��ФΤ褦�ʤ�Τ����դ��ơ�FAX������ݤΥ�����/��������Τ褦�ʲ����ǥǥ������̿���Ԥä����֡ˤ⡢����RS232C���ʤ���Ѥ��Ƥ��ޤ�����

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

��

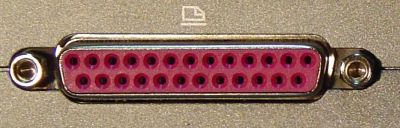

- * �ԥ�1��STROBE���ѥ����ǡ����������������Ȥ�ץ��������Ʊ�����档

- * �ԥ�2-9��DATA1 - DATA8��8�ӥåȤΥǡ������档

- ---------------------------------

- * �ԥ�10��ACKNLG���ץ���ǡ���������������Ȥ�ۥ��Ȥ�������Ʊ�����档

- * �ԥ�11��BUSY���ץ�����Υǡ���������Ǥ��ʤ����Ȥ����档

- * �ԥ�12��PE���ץ���ѻ�ν������Τ餻�뿮�档

- * �ԥ�13��SEL���ץ�����档

- * �ԥ�14��LF���ץ�ιԴ������档

- * �ԥ�15��ERROR���ץ�Υ��顼���档

- ---------------------------------

- * �ԥ�16��PRIME������ԥ塼���ν�������档

- * �ԥ�17��SEL������ԥ塼�������档

- ---------------------------------

- * �ԥ�18 - 25��GND��8�ܤΥ����ɿ������� ��

����

��

|

|

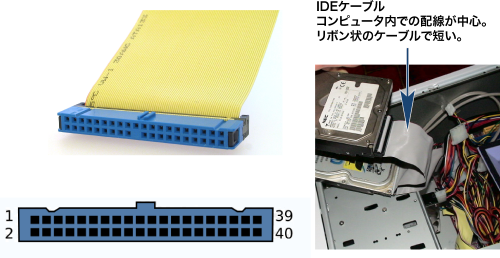

IDE�ϡ�SCSI ���֤������褦�ˤ���ȯŸ���Ƥ�����Τǡ��ϡ��ɥǥ�������HDD�ˤι�®�ǡ���ž������Ū�ˤ��Ƥ��ޤ�����

IDE�ϡ�SCSI ���֤������褦�ˤ���ȯŸ���Ƥ�����Τǡ��ϡ��ɥǥ�������HDD�ˤι�®�ǡ���ž������Ū�ˤ��Ƥ��ޤ����� ��

��  |

|||||||

|

|||||||

|

|||||||

|

|||||||

|

||||

|

||||

��ȥ����դϡ��ǡ������̿����������Ȥ������äζ�Ʊ�������ʥѡ��ƥ��饤��ˤȤ�����ǰ��Ƴ�����ޤ�����

��ȥ����դϡ��ǡ������̿����������Ȥ������äζ�Ʊ�������ʥѡ��ƥ��饤��ˤȤ�����ǰ��Ƴ�����ޤ�����

��

��

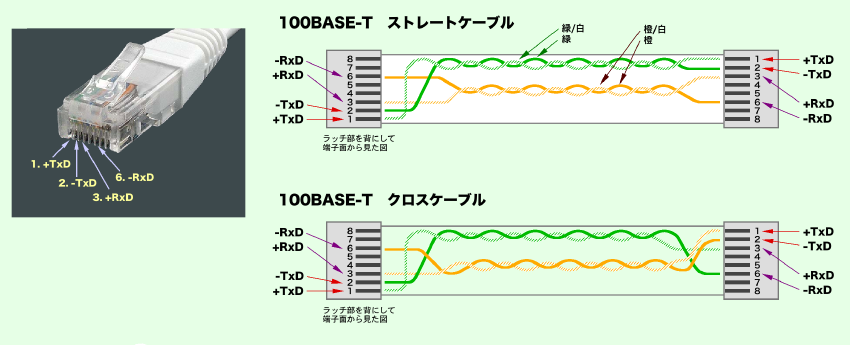

- ��1000BASE-T�Ǥϡ���¸�Υĥ����ȥڥ������֥��Ȥäƹ�®�̿��뤿���4�Фο������٤Ƥ�Ȥä����������������Τ���ǡ����Ȥ��뤿���8�ӥåȾ����9�ӥåȤˤ���������4�饤���9�ӥåȾ����ʬ���뤿���5��ˡ�ǡ����Ȥ�������

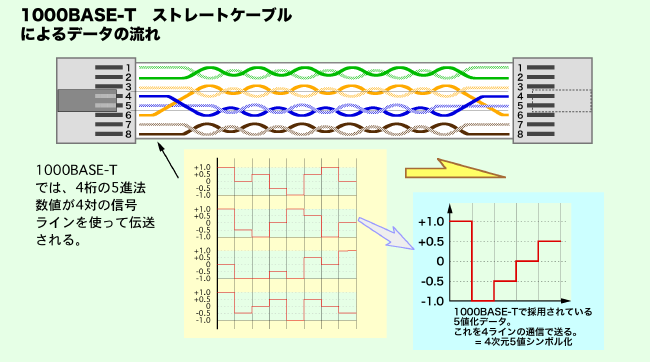

�ĥ����ȥڥ������פΥ������ͥåȥ����֥�ˤϡ���ǽ�̥��ƥ����ʬ����줿�����¾�ˡ���¤��2����Τ�Τ�����ޤ���

�ĥ����ȥڥ������פΥ������ͥåȥ����֥�ˤϡ���ǽ�̥��ƥ����ʬ����줿�����¾�ˡ���¤��2����Τ�Τ�����ޤ��� |

||||||

|

||||||

|

||||||

|

||||||

Ʊ�������֥�ϡ�Ĺ��Υ�̿������դǤ����Τ�̵��¢��Ĺ�����뤳�ȤϤǤ��ޤ���

Ʊ�������֥�ϡ�Ĺ��Υ�̿������դǤ����Τ�̵��¢��Ĺ�����뤳�ȤϤǤ��ޤ��� |

||||

|

||||

|

||||

|

||||

��

|

|||||

|

|||||

|

|||||

|

|||||

�ʥۥ��ȡˤˤ�������ɬ�פȤ��ޤ���

�ʥۥ��ȡˤˤ�������ɬ�פȤ��ޤ���

��

��

94�����®�̿����Ǥ�����ǽ�Ǥ���

94�����®�̿����Ǥ�����ǽ�Ǥ���

��

��

��

��

��

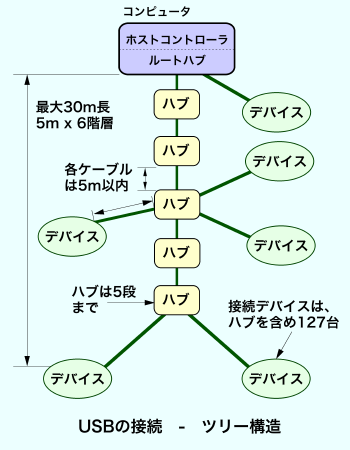

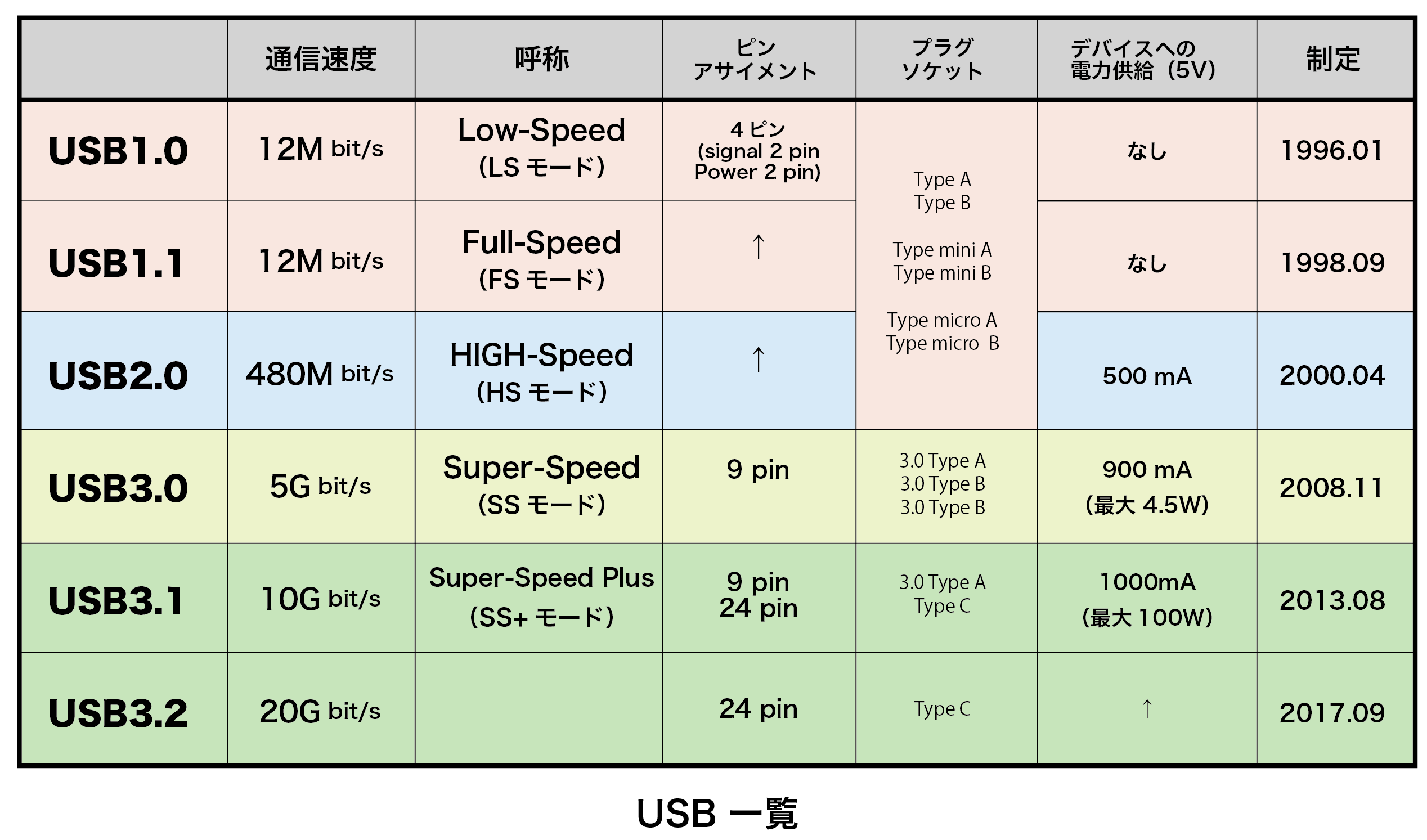

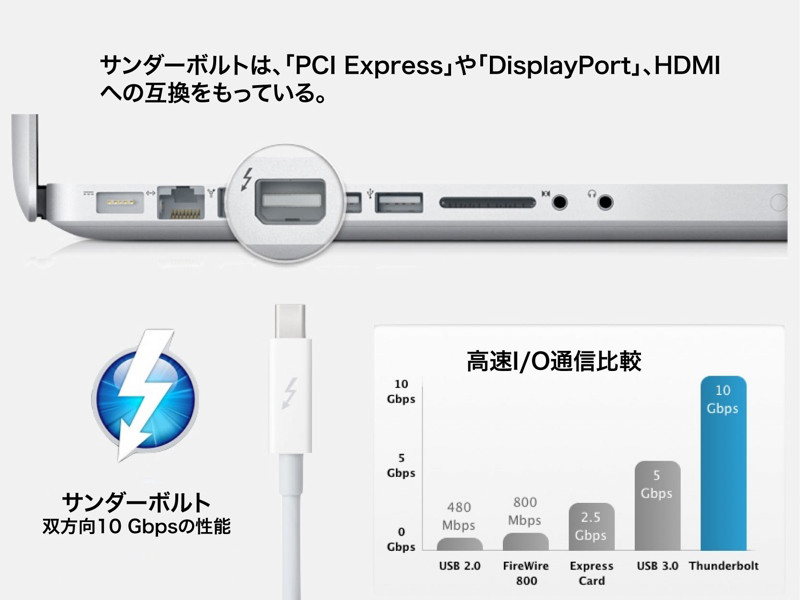

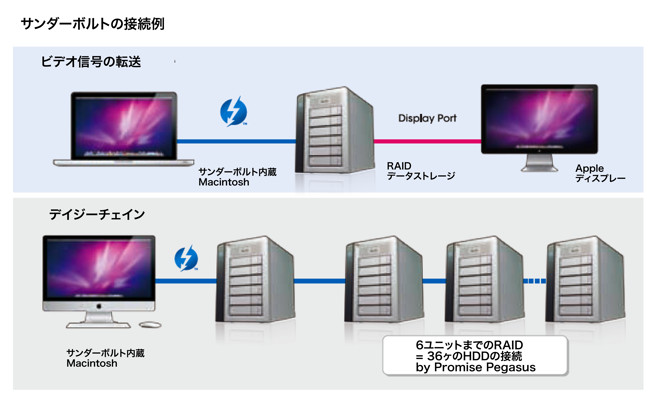

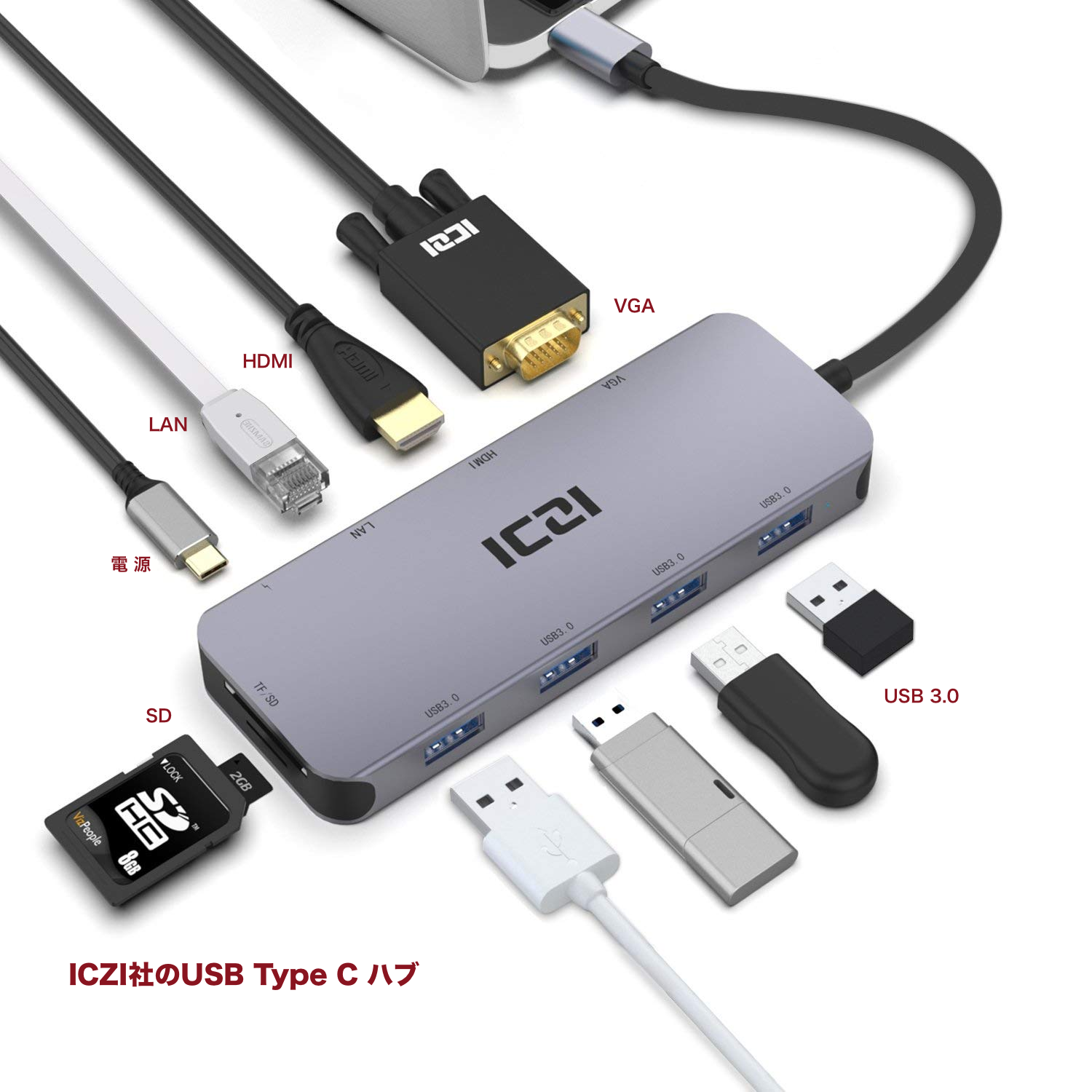

USB4�ϡ�2019ǯ8���USB Implementeres Forum��1995ǯ��Ω�ˤˤ�äƥС������1.0����������ޤ�����

USB4�ϡ�2019ǯ8���USB Implementeres Forum��1995ǯ��Ω�ˤˤ�äƥС������1.0����������ޤ����� USB3.0�ʹߤǤϡ����ͥ�������Thunderbolt3�ʹߤ���Ȥ��Ƥ���Ʊ��������USB-C�����֥뤬���Ѥ���Ƥ��ơ����ѼԤˤ�ξ�Ԥΰ㤤���狼�餺�����ޤͤ��Ƥ��ޤ���

USB3.0�ʹߤǤϡ����ͥ�������Thunderbolt3�ʹߤ���Ȥ��Ƥ���Ʊ��������USB-C�����֥뤬���Ѥ���Ƥ��ơ����ѼԤˤ�ξ�Ԥΰ㤤���狼�餺�����ޤͤ��Ƥ��ޤ�������USB���������2018.11.12�ˡ�2018.12.27�ɵ���

��

��

��

��

��

|

||||||||||||||||

|

||||||||||||||||

|

||||||||||||||||

|

|

|||

|

||||

|

|||

| ���ʥ����ӥǥ�ü�ҡʾ�̿��ˤȥǥ�����ӥǥ�ü�ҡ�DVI�ˡʲ��̿���

�ǥ����ȥåץѥ�����Ǥϥǥ�����ӥǥ�ü�Ҥ���ڤ��Ƥ��뤬���Ρ��ȥѥ��������°��˥����Ϥ�վ��ץ�����������ü�Ҥˤϰ����Ȥ��ƾ�ޤΥ��ʥ���ü�Ҥ��Ȥ��Ƥ��롣 |

|||

|

|||

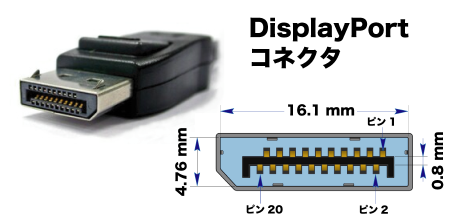

����DisplayPort�ʥѥ����̿���

����DisplayPort�ʥѥ����̿���

��ư���������Ȥ��˻Ȥ��ڥ��ˤʤä�2�����ϡ��ߤ����ܿ�����Dz�ä��κۤˤʤäƤ��ޤ���

��ư���������Ȥ��˻Ȥ��ڥ��ˤʤä�2�����ϡ��ߤ����ܿ�����Dz�ä��κۤˤʤäƤ��ޤ�����

- �� �� �� �� ��

- ��

��

��

��

��

3���ܤι��ܤ�USB PD��USB Power Delivery�˵�ǽ�Ȥϡ���³���줿������Ÿ�������Ԥ���ΤǤ���

3���ܤι��ܤ�USB PD��USB Power Delivery�˵�ǽ�Ȥϡ���³���줿������Ÿ�������Ԥ���ΤǤ��� Thunderbolt 4�ϡ�2020ǯ1��˥���ƥ�Ҥˤ��ȯɽ����ޤ�����

Thunderbolt 4�ϡ�2020ǯ1��˥���ƥ�Ҥˤ��ȯɽ����ޤ����� Thunderbolt4 ������Thunderbolt3�ϡ�USB4�˵��ʡ���ǽ��ܴɤ��Ƥ��ޤ��Τǡ�Thunderbolt4�б������֥���Ѥ���USB4�������³���뤳�Ȥ��Ǥ��ޤ���

Thunderbolt4 ������Thunderbolt3�ϡ�USB4�˵��ʡ���ǽ��ܴɤ��Ƥ��ޤ��Τǡ�Thunderbolt4�б������֥���Ѥ���USB4�������³���뤳�Ȥ��Ǥ��ޤ���

|

|||||

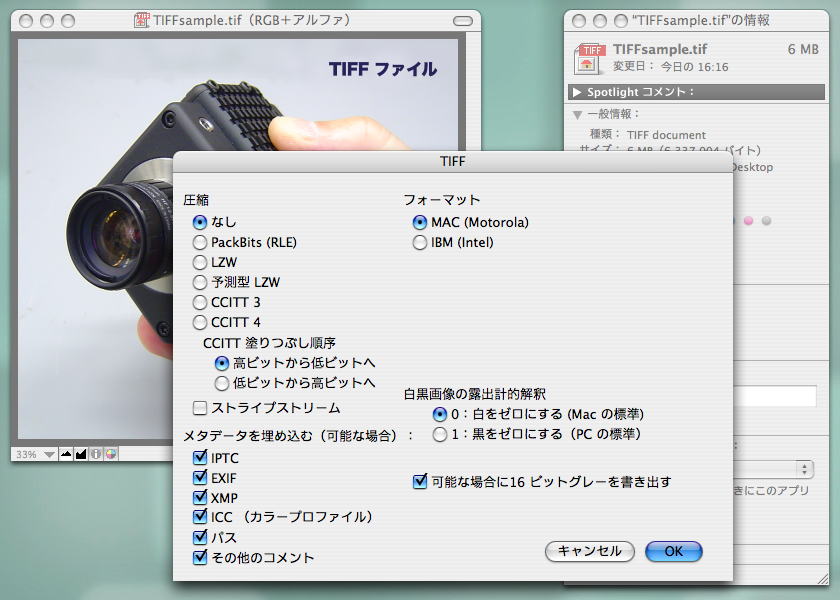

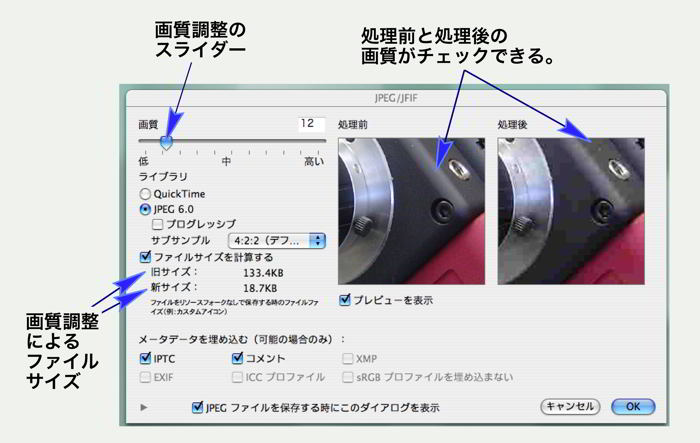

TIFF�ϡ��Ż߲����Ȥ��ư���Ū�ʥե�����ե����ޥåȷ������������ǽ�Τ�ΤǤ���

TIFF�ϡ��Ż߲����Ȥ��ư���Ū�ʥե�����ե����ޥåȷ������������ǽ�Τ�ΤǤ���

TIFF�ե��������¸�����硢���ץ����ܥ�����ȱ��˼����褦�ʥ��ץ�������꤬�Ǥ��ޤ���

TIFF�Ǥϰ��̤ˤ��ե�����������ǽ�ȤʤäƤ��ޤ���

TIFF�ե��������¸�����硢���ץ����ܥ�����ȱ��˼����褦�ʥ��ץ�������꤬�Ǥ��ޤ���

TIFF�Ǥϰ��̤ˤ��ե�����������ǽ�ȤʤäƤ��ޤ���

| �ե�����ե����ޥåȤˤ�����ΰ㤤 | ||||||

|

||||||

| TIFF��BMP��PICT�Υӥåȥޥåײ��������̤���Ƥʤ��Τ����̤��礭������������������ɹ��� | ||||||

|

||||||

| ����Ψ10%��JPEG������JPEG���äΥΥ����ʥ⥹�����ȥΥ����ˤ�����롣ʸ���η�֤��طʿ������������褦�ˤʤäƤ��롣JPEG�Ǥϰ���Ψ�����ȡ��٤������ʤ��ʤ롣 | ||||||

|

||||||

| ���10%�˰��̤���JPEG���������ɽ��������Ρ����̤ˤ������ιӤ줬��Ω�ġ��⥹�����ȥΥ������Ф�Τϡ�8����x8���Ǥǰ��̤�Ԥ����ᡣ | ||||||

|

||||||

| ���̥ե�����Ǥ���GIF�β��������ɽ��������Ρ�GIF�����ϲĵհ��̤Ǥ��ꡢ�������ξ������Ϥʤ���ʸ���ʤɤϡ�GIF������JPEG���⤭�줤��Ʊ������������PNG�����롣GIF���õ������꤬���ä�����PNG�ˤϤʤ��� | ||||||

|

||||||

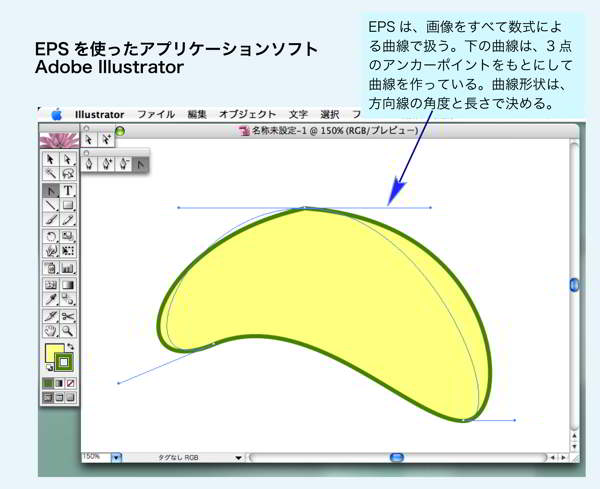

| EPS�ե����롣EPS�Ͽ����Dz����Ҥ��Ƥ��롣�ӥåȥޥåפȰ�äơ�����������Ƥ��Ŭ�ʲ�����ɽ�������äƲ�������礷�Ƥ��餫��ɽ�����롣 | ||||||

JPEG�ϡ�JFIF�Ȥ�ƤФ�Ƥ��ޤ���������������Ū�ˤ�JPEG�Ȥ���̾�����Ȥ��Ƥ��ޤ���

JPEG�ϡ�JFIF�Ȥ�ƤФ�Ƥ��ޤ���������������Ū�ˤ�JPEG�Ȥ���̾�����Ȥ��Ƥ��ޤ���

JPEG 2000�ϡ�JPEG�θ�ѥե�����ե����ޥåȤǤ���2000ǯ12��˴��𤵤�ޤ�����

JPEG 2000�ϡ�JPEG�θ�ѥե�����ե����ޥåȤǤ���2000ǯ12��˴��𤵤�ޤ�����

- ��β����ϡ��ǥ�����ǻ��Ƥ���Exif�����Ȥ��β��������äƤ���Exif�ǡ����� �ǡ����ξܺ٤˼�����

- ���Υե����뤫�顢���Ƥ���ǯ�����Ȼ��֡����Ѥ�������顢���ƾ��ե��������̤ʤɻ��٤��ʾ���뤳�Ȥ��Ǥ��롣

- ���β����ϡ��ޥå���ȥå���β������������֥��եȥ�������Graphic Converter ver.5.9.5�פ���Ѥ��Ʊ����������̤Υ��ԡ��Ǥ��롣 ��2006.06��

EPS�ե�����ϡ�ASCII �����Τ�Τȡ��Х��ʥ�����Σ����ब���ꡢ�Х��ʥ�����Τ�Τϥե����륵������Ⱦʬ�ˤʤ�ޤ���

EPS�ե�����ϡ�ASCII �����Τ�Τȡ��Х��ʥ�����Σ����ब���ꡢ�Х��ʥ�����Τ�Τϥե����륵������Ⱦʬ�ˤʤ�ޤ���

|

||

- ̾������

- ������

- ������

- �� ��

- �ģ����ʲ����ϡ�

- ���ǿ�

- MB

- Base/16

- 128 x192

- 24.8 k����

- 0.07

- �ץ�ӥ塼������ͥ���

- Base/4

- 256 x 384

- 98.3 k����

- 0.28

- �����ͥå�Web��

- Base

- 512 x 768

- 393.2 k����

- 1.13

- ����ԥ塼���������

- �����ͥå�Web��

- 4Base

- 1,024 x 1,536

- 1.57 M����

- 4.50

- �������TV�������

- 16Base

- 2,048 x 3,072

- 6.29 M����

- 18.0

- ������

- 64Base

- 4,096 x 6,144

- 25.2 M����

- 72.0

- �ץ�����

- ��

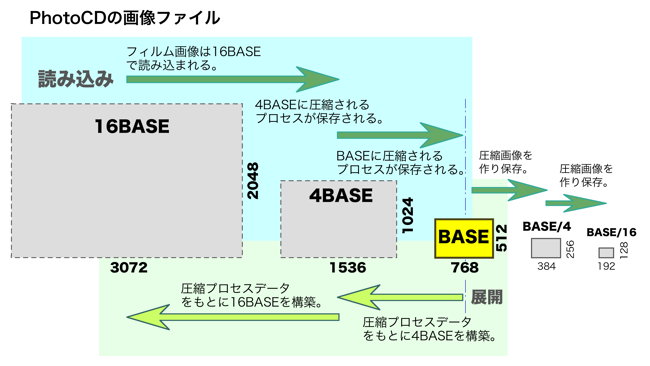

- ���ε��ʤ��Ǥ���1990ǯ���Ⱦ��DPE����åפ˥ե����ͥ����������ȡ�Base/16���� 16Base �ޤǤ�5�Ĥβ�����1���åȤȤ���CD�˾Ƥ��Ƥ��줿����������ޤ���

- PhotoCD�Ǥϡ�CD1���100������Ͽ�Ǥ��뵬�ʤˤʤäƤ��ޤ�����

- Pro PhotoCD�Ǥ�4�ܤ��礭���ˤʤ�Τ�1���CD��25��β�������¸�Ǥ��ޤ�����

- PhotoCD��5�Ĥβ����Υե��������̤��פ����23.99MB�Ȥʤ�ޤ���

- CD1���100����ʬ��Ͽ�����2.4GB�Ȥʤ�ޤ���

- ����Ǥ�CD�˼��ޤ�ޤ���

- 650MB��CD��100���PhotoCD��Ͽ����Ȥʤ�ȡ�1�Ĥβ�����6.5MB�ʲ����ޤ��ʤ���Фʤ�ޤ���

- 16Base�β����Ǥ�18MB��������ΤǤ���

- ���äơ�PhotoCD�ϲĵհ��̼�ˡ���Ȥ��Ƥ��ޤ���

- ����ϡ�Image Pac�ȸƤФ������Ǥ�����

- ��

- ����������ѥå�������Image pac��

- PhotoCD�ϡ�16Base�� = 2,048 x 3,072���ǡˤβ����Ϥ����Ȥ���5�Ĥβ����Ϥ�ɽ���Ǥ�������ե������������äƤ��ޤ���

- ��Pro PhotoCD�ϡ�64Base��ޤ6����β����ե�������äƤ��ޤ�������

- ������ѥå��ϳ��ز���¤����ä���Τǡ����ܲ�����Base�˲��������ղþ���ˤ�ä�5����β����Ϥ���IJ�����Ǥ�դ˸ƤӽФ����Ȥ��Ǥ����ΤǤ���

- ���γ��ز����ѡ�hierarchical storage format�ˤϡ��ƹ��HP�ҡ�Hewlett-Packard�ˤ������ȸ����Ƥ��ޤ���

- ��˽Ҥ٤ޤ����褦�ˡ�PhotoCD��5�Ĥβ����Ϥ���IJ��������ǡ�����Τ�Τϡ�16Base��2,048 x 3,072���ǥե륫�顼�Ǥ���

- �����������β����ϥե��������̤�ñ��������18MB�Ȥʤ�ޤ���

- PhotoCD�Ǥϡ�Base�������δ��ܤȤʤäƤ��ơ�������٤β�������Ȥ��ˤϡ�Base��������ܤȤ��Ʋ��Ǵ֤��䴰����4�ܤξ�������4Base����ޤ���

- ����˹�����٤��᤹����ϡ�4Base�β����˲���������䴰����4�ܤξ�������16Base����ޤ���

- �ޤ���Base/4��Base/16�ξ����������ϡ����̤����ʤ��Τ�ľ�ܲ����ե�������ä���¸���Ƥ��ޤ���

- ��

- PhotoCD�δ��ܲ����ϡ�Base�Ȥ���512 x 768���ǤǤ��ꤳ�줫�����Ǥ��ۤ��Ƥ���������ȤäƤ��ޤ���

- ���ֹ⤤�����Ϥβ����ե����뤫��ְ������Ʋ��ǿ��餷�Ƥ����Τ����䤹����ΤǤ�����Base�Ȥ������Ū�����ʲ��Ǥǹ�����٤β������ۤ��Ƥ����Ȥ����Τ���ˡ���ߤƤ��ơ��ۥ�Ȥ˹����β�����������Τ��ȵ���˴����Ƥ��ޤ��ޤ���

- ����ϡ�Base��ǽ�Ū�˺��夲��Ȥ����ǽ��16Base�β����ǥǥ��������ʥǥ����벽�ˤ��ơ���������1/16��Base�ޤǽ̾����Ƥ������̾���������������Ĥ��Ƥ������餳���Ǥ�����ˡ���ä��ΤǤ���

- �̾�������ϡ�16Base�����˸��������Ǥ������Ǥ��ꡢ���ξ����˰��̡�Huffman�����ˤ�����¸����Ȥ�����ΤǤ�����

- 1990ǯ�������ϡ�������ˡ��������ѥ��ȤˤޤȤ�Ʋ����ȥ쥹�ʤ�ɽ�����ʤ����Ĺ�����٤ޤ��б����Ƥ���٥��Ȥ������Ǥ��ä��ȸ����뤫���Τ�ޤ���

- ������ѥå������Ѥ��Ƥ���������̤ϲĵհ��̤Ǥ��ꡢJPEG�Τ褦�ʲ���������������ޤ���

- �����Τˤϡ��٤�����ο������䰦�����پ��������Ĥ��ΤǴ����ʲĵհ��̤ǤϤ���ޤ����ۤȤ������ˤʤ�ޤ���

- ������ѥå��βĵհ��������δ��ܤϰʲ����̤�Ǥ���

- ��

- ����1.���ǽ�β����ʥե��������ˤ�16Base�����ʤ����2,048���� x 3,072���ǤΥե륫�顼��24�ӥåȡˤǼ����ࡣ

- ����2.�����β�����RGB��3�����ˤǤϤʤ���YCC�ʵ��٤ȿ�����YUV�Ȥ���������Ѵ����롣

- ��������YCC���������ΰ��̤��Ԥ��䤹��������Ū��Y�ʵ��١ˤϽ��פʤΤǤ��ξ���ϻĤ���

- ����������������ϡ��٤������̤˴ؤ��ƤϿͤ��ܤ��б����ʤ��ΤǴְ�����

- ���������ʤ���ϥƥ�ӤΥ��顼���Ѥ�Ʊ������

- ����3.����������1/4���Ѵ�����4Base�β������롣

- �����������λ��ˡ��Ѵ���������ե�����˻Ĥ��Ƥ�����16Base�β�������Ȥ��ν���䵤Ȥ��롣

- ����4.������ˡ�4Base��1/4���Ѵ����ơ�Base�ײ������롣ʻ���Ƥ����Ѵ���������ե�����˻Ĥ���

- ����������Base�ײ�������ܲ����Ȥ�����¸���롣������Ȥ�4Base��16Base����夲�롣

- ����5.��Base/4��Base/16�ϡ��������������Τ�ͽ���äƲ����ե�����Ȥ�����¸���롣

- ����6.��64Base�ϡ�Pro PhotoCD�ȸƤФ���Τǡ�����ϡ��ǽ��4,096���� x 6,144���Ǥ��ꡢ

- �����������Ʊ�ͤμ�ˡ�ǹ��6����β������ۤ��롣

- ��

- 1990ǯ�塢4Base�β�����4.5MB�ˤ�ѥ�����dz�����Τϻ���ζȤǤ�����

- �������������30�����٤λ��֤������äƤ����ȵ������Ƥ��ޤ���

- ���ǿ������ޤ��ȡ�Base������2000ǯ�����˸���줿�ǥ����륫����640���ǣ�480���������ˤȤۤȤ��Ʊ���٤Ȥʤ�ޤ��������ä��ꤷ���ե��������������ǽ������ʡ���PhotoCD�˻Ȥ�줿������ʡ������ɴ���ߡˤǥǥ����벽���������ϡ���γ��γ·�äƤ�����1���ǤΥΥ��������ʤ��ˡ��̥����ɤ��ǥ���������������Ƥ��ޤ�����

- �ޤ���ñ��CCD�ǻҤ�����줿�ǥ�����������⥫�顼�����ä��ꤷ�Ƥ��ޤ�����

- ��������2010ǯ�ˤ��äƤϡ�3000���ǣ�2000���������Υǥ����륫��餬�²��˽в��褦�ˤʤ�ȡ����ǿ�������Ū�ʥѥ������Τǽ̾����ƻȤ��Хե��������ʾ�β�����������褦�ˤʤ�ޤ�����

- ����ˤ��谷�Τ褤�ǥ����륫��餬�ե���५������ष�Ƥ������Ȥˤʤ�ޤ�����

- ����

- ����Flashpix�ʥե�å���ԥ�����������2010.03.15�ˡ�2010.04.29�ɵ���

�����γ��ز����Ѥ������Τ�Flashpix�Ǥ���

- ���β����ե����ޥåȤϡ��������ȥޥ��å��Ҥμ�Ƴ�ǥҥ塼��åȥѥå����ɼҡ��饤�֥ԥ�����ҡ��ޥ��������եȼҤζ��Ϥ�����1996ǯ�˺��ꤵ��ޤ�����

- Flashpix�ե����ޥåȤϡ��饤�֥ԥ�����Ҥ���ȯ����IVUE�Ȥ��������뵡ǽ/�ޥ����롼�����ǽ��Ƨ�����Ƥ��ޤ���

- Flashpix�ϡ�Exif�ե����ޥåȤˤ��б����Ƥ��ơ��ǥ����륫��������줿Exif�ե����ޥåȲ�����Flashpix���Ѵ���¸���Ʊ������뤳�Ȥ��Ǥ��ޤ���

- Flashpix�ϡ���®�˹��������ե����������������Ȥ����ᤫ�����ޤ�ޤ�����

- �������Ȥ��̤ˡ�96x96���ǤΥ���ͥ�����������Υե����ޥåȤ��Ȥ߹��ޤ�Ƥ��ơ������γ��פ�����˸�����褦�ˤʤäƤ��ޤ���

- ����˲ä������������ʬ�����ơʥ����뵡ǽ�ˡ��ɤΥ��ꥢ��ȴ���Ф�����ͳ�����֤��Ȥ��Ǥ��ޤ���

- �ޤ������ϰϤ�����硢�٤�������������ɬ�פϤʤ��ΤǴְ����������������ä��̿���ɽ������٤�ڸ������Ƥ��ޤ��ʥޥ����롼�����ǽ�ˡ�

- Flashpix�Ǥϡ��Ǿ�ñ�̤�64x64���ǤǴ�������Ƥ��ơ����β��ǥ֥��å��ʥ�˥åȡˤ���Ž��ι�¤�Τ褦�ˤ��Ƹ�����������Ƥ��ޤ���

- �����ϰϤ�Ȥ��ϡ�64x64���Ǥ������ɽŪ�ʾ�����夲����1���ǤȤ��Ʋ������ۤ���褦�ˤʤ�ޤ���

- �̾�β����ե����ޥåȤϡ�������ѥ�����ˤ��ä��������ǥѥ�������dz���䥹���������Ԥ��Τ����̤Ǥ�����������ˡ�����礭�ʲ����٤Ƽ����ޤʤ���Фʤ�ʤ��Τǻ��֤������ä����̿��֤䥳��ԥ塼������٤�������ޤ���

- �����Զ����θ���Ʋ������ʬ�����Ƴ�Ǽ������ͳ�ˤ��Ĺ�®���ɤ߽Ф����Ȥ��Ǥ���Τ�Flashpix�Ǥ���

- �ڥޥ����롼�����ǽ��

- Flashpix�ϡ����켫�Τ�ʪ��Ū�ʥե�����ե����ޥåȤ�������Ƥ���櫓�ǤϤʤ�����Ǽ����ǡ�������ˡ�ʤɤΥ롼������������ƥ�����Ǥ��ꡢ����Ū�ˤϤ��ޤ��ޤ�ʪ���ե����ޥåȤ˱��ѤǤ���褦�ˤʤäƤ��ޤ���

- �פ����JPEG�����Ǥ�TIFF�����Ǥ�Flashpix�ˤǤ���Ȥ������ȤǤ���

- Flashpix���礭����ħ�ϡ������� 64x64�ԥ������1�ĤΥ֥��å��Ȥ��ƴ����������Υ֥��å�ñ�̤�ɽ��������ʤɤΥ����������Ԥ��Ƥ��뤳�ȤǤ���

- ���äơ�������Ϥβ�����ɽ�����������������ˡ�ǽ�ϤΤʤ�����ԥ塼����ץ�Ǥ�ɬ�װʾ�ˤ�����������֤�û�̤����뤳�Ȥ��Ǥ��ޤ���

- Flashpix�Ǥϡ�������ɽ����Ǿ�1/64�ˤ��뤳�Ȥ��Ǥ��ޤ���

- ��������������ϡ�PhotoCD�Ȼ��Ƥ��ޤ���

- ��������PhotoCD�����ǿ��䥢���ڥ����椬BASE�Ȥ������ޤ�Ǹ��ꤵ��Ƥ���Τ��Ф���Flashpix�ϼ�ͳ�����֤��Ȥ��Ǥ��ޤ���

- ����ˤ��μ�ͳ�ʲ������������Ȥˤ��ơ����դ줾��1/2��1/4��1/8��4�ʳ��˲����������٤�������ƿ�®�˲���ɽ������Ϥ��Ǥ���褦�ˤʤäƤ��ޤ���

- �㤤CPU ǽ�Ϥ���ĥ���ԥ塼���Dz���������Ԥ��Ȥ��ϡ�������ְ����ƽ�����Ԥ����ץ��Ȥ���Ȥ��˻��֤��ƹ⤤�����Ϥǥץ��Ƚ��Ϥ��뤳�Ȥ�Ǥ��ޤ���

- �����֥ޥ����롼����� = MultiResolution��ǽ�ȸƤ�Ǥ��ޤ���

- ��

- �ڥ������ǽ��

- Flashpix�Τ⤦��Ĥ��礭����ħ�ϡ��֥������ = Tiling��ǽ�Ǥ���

- ��ۤɡ�Flashpix��64x64�ԥ���������Υ֥��å�ñ�̤Dz���������������Ƥ���ȸ����ޤ����������Τ��ޤ�����Ѥ��ơ����Τβ�������ɬ�פ���ʬ��������Ф��ʤ��줬���Τ���Ф��ʤ��Τǹ�®�˼��Ф���˵�ǽ������ޤ���

- �������Ȥ����ޤ���

- ���äơ������ǡ����Ϻǽ�����Τ�����ɤ��Ƥ���ɬ�פϤ���ޤ���

- �Ǿ��¤Υ��ȥ쥹�Ǥ��������ݴɤ���Ƥ����ǥ�����������ɤ��ʤ��顢�礭�ʲ����ǡ�����������뤳�Ȥ��Ǥ���ΤǤ���

- ���Υ�����ȥޥ����롼�������Ȥ߹�碌�ϥ����ߥǤ�ͭ���˵�ǽ���ޤ���

- ��������Flashpix����ħ�ϡ�������ʪ�ʤɤε��Ťʲ��λ�ե�������������ٲ����Ȥ����ݴɤ���ɬ�פ˱����ƴ�˾�����礭���Ǻ���ɽ��������Ū��ͭ���Ǥ���

- �㤨�п�ۤ˽�¢���Ƥ��볨��ʪ���ʸ���Flashpix��������¸���ơ����Ѥ����������Ԥ˥ͥåȥ�����̤���Viewer�Ǹ��Ƥ�餦�Ȥ�����ˡ�Ǥ���

- �������ϡ�1GB�ʥ����Х��ȡˤˤ�ã���뤳�Ȥ�����ޤ���

- Flashpix�Ǥϡ��ְ����������Τ���ɽ�������Ȥ������ä��ꡢ��������ʬ�����γ�����������뤳�Ȥ��Ǥ���Τǡ�ɬ����¤Υǡ����̤Dz����������Ǥ�ɽ�����ԡ��ɤ����åפ��ޤ���

- Flashpix����Ѥ���ˤϥ饤����ɬ�פǤ��ꡢFlashpix������ˤ����ѤΥӥ奢��ɬ�פʤ��ᡢFlashpix�Ȥ���̾����������˹����Ȥ��Ƥ���Ȥ������ȤϤʤ��褦�Ǥ���

- �������̥ե����롡-�������ˤ��ե��������̤ΰ㤤

- ���Ȥ��Ƥ�������ե�����ϡ����̤�����Ū�ˤʤäƤ��ޤ���

- ���̤�Ԥ����֤���Ū�ϡ������ե��������̤������뤳�ȤǤ���

- ���꤬����Ǥ��ä������ѥ��������ǽ���夬��ʤ��ä����塢����˥����ͥåȤ��̿�®�٤��夬��ʤ��ä�����ˤϤȤƤ⤢�꤬������ǽ�Ǥ�����

- �����������̤���ߤˤ�����ȴ��Ԥ�ź���ʤ���̤Ȥʤ�ޤ���

- �㤨�С�����Ψ�ι⤤�������¸���줿JPEG�����ϡ����줷�������Ȥʤ�ޤ���

- �������¬���ʤȤ��ư������ˤϡ����̥ե��������ħ�ȥե��������̤�������ʬ�����Ƥ������Ȥ�ɬ�פ��ȹͤ��ޤ���

- ���˼��������μ̿��ϡ�����BMP�ʥӥåȥޥåס˥ե�����ǡ�����JPEG��10��ޤǰ��̤��������ե�����Ǥ���

- ����ϰ��������ǡ�JPEG�������Ƥ�����Ω���ޤ���

- BMP�ե�����ϡ��̤Ǥ�������ǿ������Τޤޥե��������̤Ȥʤ�ޤ���

- 512x417����@8�ӥå�ǻ�٤Ǥϡ��ʲ��Υե��������̤Ȥʤ�ޤ���

- 512 ���� x 417 ���� = 213.5k ����/����������������Rec-38��

- �ڼ̿������ΰ��̡�

- ���˼�����JPEG�����Ǥϡ�10��˰��̤��Ƥޤ��Τǥե��������̤�1/37��5.7k�Х��ȤǤ���

- ξ�Ԥ���٤�ȡ��ե��������̤����ʤ꾮�����ʤä�ʬ����������ʤäƤ���Τ�����Ǥ��ޤ���

- Ʊ��������PNG�ե��������ȡ�155.7k�Х��ȤȤʤ�ޤ�������ϡ�BMP�ե������73�����٤������̤Ǥ��ޤ���

- ���Τ��Ȥ���PNG�ʲĵհ��̥ե�����ˤǤϼ̿��Τ褦�ʺ٤����������Ф��ƤϤ��ޤ����դǤϤʤ����Ȥ��狼��ޤ���

- �� �ڥ���ե��å������� ���β��˼���������ץ�����ϡ���ȹ����Ϥä��ꤷ��ñ��ʥѥ���������Ǥ���

- ���β����ǥե��������̤ޤ��ȡ�BMP�ե�����ϡ��̾�μ̿�������Ʊ��215.0kB�ȤʤꡢJPEG10%���̥ե������7.4kB��1/29�ΰ��̤ˤʤäƤ��ޤ���

- ���ܤ��٤��ϡ�PNG�ե�����ǡ�2.7kB�ȶð�Ū�ʲĵհ��̤ˤʤ�ޤ���

- PNG�ϡ����˥��ʸ���ʤɤΥѥ��������Τʤ�Τ��Ф����̲������Ѥ��ʤ��ʼ��ǹ⤤���̤��Ǥ��뤳�Ȥ��狼��ޤ���

- JPEG�ϡ�ʸ���䥰��ե��å������ΰ��̤Ǥϲ褬�����ʤ�ޤ��ʥ⥹�����ȥΥ������Ф�ˡ�

- �� �ڿ�����ʲ����� �Ǹ�˿�����ʲ����ˤĤ��ƹͻ����ޤ���������ʲ����Ǥ�BMP�ե�����ϲ��ǿ�ʬ�����Υե��������̡�215.0kB�ˤȤʤ�ޤ���

- JPEG�ϡ�8x8���ǤDz����Υѥ�����Ƥ����ޤ��Τǡ�1/(8x8) = 1/64�ʲ��ˤϤʤ�ޤ���

- ��������PNG�Ǥ�1.9kB�Ȥʤ�1/119�ΰ��̤ˤʤ�ޤ����ѥ�����ñ�㲽������Τۤ�PNG�ե�����ΰ��Ϥ�ȯ���Ǥ���ȸ�����Ǥ��礦��

����

- 512x417����8�ӥåȤ�����̿������Υե��������̤���ӡ� ������BMP�ե����롧215.0kB��-���庸�β����� ������TIFF�ե����롧215.0kB��-�����̤�Ԥ�ʤ�TIFF�ե������BMP��Ʊ���ե��������̤���ġ� ������PNG�ե����롧155.7kB��-���ĵհ��̥ե�����ʤΤǺ٤����̿������ΰ���Ψ�Ϥ褯�ʤ��� ������JPEG90%���̥ե����롧��51.9kB��-���ե��������̤�1/4���٤ˤʤä��������½���ʤ��� ������JPEG50%���̥ե����롧��18.6kB��-���ե��������̤�1/11���٤ˤʤä�������ϼ㴳�Ӥ�Ƥ��롣 ������JPEG10%���̥ե����롧��5.7kB��-���屦�β������ե��������̤�1/37��

- ������JPEG 1%���̥ե����롧��4.0kB��-���ե���������1/53������Ϥ��ʤ�Ӥ�롣

- 512x417����8�ӥåȤ�����ѥ���������Υե��������̤���ӡ� ������BMP�ե����롧�������� 215.0kB��-���庸�β����� ������PNG���̥ե����롧������ 2.7kB��-��1/79�ΰ��̤Ȥʤ롣�����½���Ϥʤ��� ������JPEG90%���̥ե����롧 16.0kB��-���ե��������̤�1/13���٤ˤʤä��������½���ʤ��� ������JPEG10%���̥ե����롧��7.4kB��-���ե��������̤�1/29���٤ˤʤä��������½���ʤ��� ������JPEG 1%���̥ե����롧�� 5.8kB��-���屦�β������ե���������1/36������ϹӤ���ʥ⥹�����ȥΥ������� ��

- �ѥ�������礭�ʲ����ϡ������ΰ���Ψ������礭�ʥե����밵�̤��Ǥ��롣������ͳ�ϡ�JPEG��8x8�ΰ��̥��르�ꥺ�ब���ѥ�����ΤϤä��ꤷ�������Ǥ�1/64�ˤ��뤳�Ȥ��Ǥ��뤿�ᡣ�ѥ�������Ƥ�������PNG������Ū��ͭ���ǹ⤤����Ψ�������롣

- 512��417����8�ӥåȤ� �����Υե������������ ����BMP�ե����롧 215.0kB��-�����β����� ����PNG���̥ե����롧 1.9kB��-��1/119���̡� ����JPEG 90%���̥ե����롧 3.6kB��-��1/59�� ����JPEG 50%���̥ե����롧 3.6kB��-��1/59�� �� ñ�����쿧�β����Ǥ⡢BMP�ե�����Ǥϲ���ʬ�����̤�Ϳ�����롣PNG�ե�����Ǥϡ�1/119�ΰ��̤�Ԥ���JPEG��갵��Ψ���ɤ�������ϡ�JPEG�Ȥϰ㤦���̥��르�ꥺ���ȤäƤ��뤿�ᡣJPEG�ϡ�8x8���Ǥ��ĤΥ֥��å��Ȥ��Ƥ��뤿�ᡢ1/64���٤��³��Ȥʤ롣ñ��ʲ����Ǥ����PNG����������Ψ���褤��

- ��

- ��¸�ե����ޥå�

- �̾�β���

- ����Υѥ��������

- ������ʲ���

- 512x417���� 8�ӥåȡ�256��Ĵ��

- ���

- BMP

- 215kB

- 215kB

- 215kB

- TIFF

- 215kB

- 215kB

- 215kB

- PNG

- 155.7��B

- 2.7kB

- 1.9kB

- JPEG��90%

- 51.9kB

- 16kB

- 3.6kB

- JPEG��10%

- 5.7kB

- 7.4kB

- 3.6kB

- JPEG��1%

- 4.0kB

- 5.8kB

- 3.6kB

�����ѥ�����ΰ㤤�ˤ��ե��������̤ΰ㤤�ΤޤȤ��ɽ��

- ���ɽ���顢JPEG�ϼ̿������˰��Ϥ�ȯ������ �ѥ�����ΤϤä��ꤷ�������Ǥ�PNG�����̤Τ��뤳�Ȥ�����Ǥ��ޤ�

- ��

- ��

- ��

- ��

- ����DNG��Digital Negative��������2018.11.07��

- DNG�ϡ��ƹ�Adobe�Ҥ�2004ǯ�˳�ȯ���������ե����ޥåȤǤ���

- �ǥ����륫���β������������8�ӥå�ǻ�١ʥ��顼������8�ӥå� x 3 = 24�ӥå�ǻ�١ˤ���10�ӥå�ǻ�١�12�ӥå�ǻ�٤���Ĥ�Τ������ơ��ƥ���������ȼ��Υե��������Ѥ��Ф������Ȥ��顢�������ե�����ե����ޥåȡ� �ե�����ˤ����줹����Ū�dz�ȯ����ޤ�����

- ̾�����֥ͥ��ƥ��֡פȤ��Ƥ���Τϡ��ե����Υͥ�����������Ƥ���Ȼפ��ޤ���

- DNG�ϡ�Adobe�Ҥ��꤬��������������եȥ�������Photoshop�פ��Lightroom�פؤΰܿ�����褯���ơ������Υ��եȤǤβ���������Ԥ��䤹�����Ƥ��ޤ���

- DNG�ϡ�TIFF/EP��TIFF�ե������2001ǯ���ɲ����ꤷ����Ρˤ�١����ˤ��Ƥ��ޤ���

- TIFF��Tag Image File Format�ˤϡ�1986ǯ�ˤǤ����Ť��ե����ޥåȤ��̤Ǥ���

- Aldus�Ҥ���ȯ��Adobe�Ҥ�Aldus�Ҥ������������TIFF��Adobe�Ҥν�ͭʪ�ȤʤäƤ��ޤ�����

- TIFF�ϡ�¾�β����ե�����ե����ޥåȤ����8�ӥåȡʥ��顼8�ӥå� x 3 =24�ӥåȡˤǤ��ä��Τ��Ф��ơ����16�ӥåȡ�2�Х��ȡˡ����顼48�ӥåȤ�Ϳ�����ÿ�����äƤ������ᡢAdobe�Ҥ�����TIFF�ե����ޥåȤ����Ϥ����ȹͤ��ޤ���

- TIFF/EP��Tag Image File Format / Electric Photography�ˤϡ����ꥸ�ʥ��TIFF�˥ǥ����륫������ڤ��Ƥ���Exif������Ȥ߹�碌����Τǡ��ǥ����륫���β����ե����ޥåȤ��ò�������ΤȤ���2001ǯ�����ꤵ��ޤ�����

- DNG�ϡ�TIFF/EP��˿ʲ������ƥե�����ե����ޥåȤ��ò�������8�ӥåȲ�����JPEG��PNG�ʤɡˤؤ��ڤ�Ф����ưפˤ�����տޤ�����ޤ���

- ����DNG�����ե�����ϡ��⾰����ǰ�Ǻ���ƤϤ����ΤΡ����꤫��14ǯ�����äƤ⤳�����Ѥ��Ƥ��륫��������ϥ����ޡ��饤�����ڥå����ʤɿ��Ҥǡ����Υ���������ϰ����Ȥ��Ƽ��ҤΥե��������Ѥ�³���Ƥ��ޤ���

- ��Photoshop�פ��Lightroom�פؤΰܿ�����ǧ�����Ф��β����ե�������礭���������Ƥ�����ΤȻפ��ޤ���

- ��

- ����HEIF��High Efficiency Image File Format��������2018.11.07��

- HEIF�ϡ�2017ǯ�����åץ�Ҥ����Ҥ�OS��macOS High Sierra�ڤ�iOS11�ˤǥ��ݡ��Ȥ�Ϥ�����ե�����ե����ޥåȤǤ���

- JPEG����������夵����Ʊ���ʾ���ʼ��ǥե��������̤�1/2���ޤ������ΤǤ���

- ���ޥۤ���Ѥ�������Ǽ̿�/ư�褬���������Ȥˤ�äƥե�������¸���̤��������뤳�Ȥˤʤꡢ��������ޤ�ޤ�����

- ���β����ե�����ϡ�����ư��ե������꤬����MPEG���ؤ�2013ǯ������ꤷ2015ǯ�˳�ȯ���ޤ�����

- H.265�Ȥ������������ʤΥ����ǥå�����Ѥ��Ƥ��ޤ���

- HEIF�μºݤα��Ѥϥ��åץ�Ҥ����ƤǤ��ꡢ�ޥ��������եȼҤϤޤ����ݡ��Ȥ���Ƥ��ʤ��Τǡ�Windows�Ǥϥե�������䥵���ɥѡ��ƥ��ˤ������������ץꥱ������եȥ����������Ѥ���ɬ�פ�����ޤ���

- HEIF���Ż߲����Ǥ�������Ȥ�Ȥ�H.265����Ѥ���ư��ե������HEVC��High Efficiency Video Codec���Ȥ������ʤ����졢������Ȥ��Ż߲�Υե�����ե����ޥåȤ����ʲ�����ޤ�����

- ���Υե����ޥåȤ�����ɸ��ˤʤäƤ������ɤ����Ϥޤ��狼��ޤ���

- ���ѿ���¿��iPhone��ɸ����������줿�Τǡ�ǧ�ΤϤ���Ƥ����Τ������Ȼפ��ޤ���

- ������iPhone�ϡ����ޤͤ����Ѥ���Ƥ���JPEG��º�Ť��ơ������¦������ˤ�äơ�HEIF �ե����ޥåȤǤϤʤ�JPEG����¸��������ˤ����ꡢ�֥饦����JPEG�ե�����˴�ñ���Ѵ�����¸�Ǥ���褦�ˤ��Ƥ��ޤ���

- ��

- ��

- �����ǥ����뵭Ͽ��ư������������2007.4.15�ɵ��ˡ�2010.05.19�ɵ��� �� ���ι�Ǥϡ�ư�����ˤĤ��ƿ���ޤ��� �� ���˥�ư��θ����������Ǥ���褦�ˡ��Ż߲����ּ����¤٤ƺ��������ư�����������ޤ���

- �ѥ������ư�����Ϥ���ȯ�ۤǺ���ޤ�����

- ư�������Τ�Τϡ��ѥ�����ȯã���������餢��ޤ�����

- �ƥ�������ȱDz�Ǥ���

- ����黰�Ԥϡ��ȼ��ο�Ÿ�ʤ��餷����ߤ��˱ƶ�����äƺ����˻�äƤ��ޤ�����ư���������Ū��ή������ȡˡ�

- �Dz��ƥ�Ӥ����ʥ���ư��Ǥ��ä��Τ��Ф����ѥ������ư��ϥǥ�����������饹�����Ȥ��ޤ�����

- ������������ư���������������NTSC��PAL���ʡˤ��龯�ʤ���̱ƶ�������Ƥ��ޤ���

- �ѥ������ȯ����IBM�Ҥ�MSDOS����ԥ塼����Ϳ����ɸ����̤ϡ�NTSC����������ϤȤ���640x480���Ǥ���VGA��Video Graphics Array�˵��ʤǤ�����

- ��

- ����ԥ塼����ư�����ϡ��Ż߲��Ϣ³���ƺ������뤳�Ȥ����ȯ���ޤ�����

- ���������˲���������ƥƥ�������Τ褦�ʻ��ȤߤȤ��ޤ�����

- ����ԥ塼����ư�����ϡ��ƥ�����������������������뤳�Ȥ��Ǥ����Τǡ�����������ư�����ե�����ե����ޥåȤ��Ǥ��ޤ�����

- ������������Υѥ��������ǽ���褯�ʤ��ä��Τǡ��ƥ��������٥�β���Ȳ���ͳ���ߤ���뤳�Ȥ��Ǥ��ޤ���Ǥ�����

- �ǥ�����������������Ѥ����⤷��NTSC������ɤŨ����褦�ˤʤ�ȡ��ǥ�����������ƥ�����������ĥ��褦�ʷ��Ȥʤ�ޤ�����

- ξ�Ԥϸߤ���ʸ������ʤ��顢�ѥ�����ǰ�ä�ư�����ե�����ȡ��ƥ�Ӥ��ݤ�줿�ƥ�ӱ���������˱Dz�Ǻ��Ѥ��Ƥ����Dz�ե����ޥåȤ������Ȥ�褦�ˤ��ơ��ǥ�����ư�����ե����ޥåȤ�������ƹԤ��ޤ�����

- ��AVI�ۡ�Audio Video Interleaved Format�ˡʤ����֤�����������2009.05.19�ɵ��ˡ�2022.04.19�ɵ���

- �桹��¬ʬ��ǺǤ��ɤ��Ȥ��Ƥ���ư��ե�����ե����ޥåȤ�AVI��1992 ǯ��ȯ��1997ǯ��ȯ��λ�ˤǤ���

- �Ǥ�Ť����ʤǤ��뤳�Υե����ޥåȤ�30ǯ�������ǻȤ��Ƥ���Τ϶ä��Ǥ���

- ������25ǯ��Ⳬȯ�������ݡ��Ȥ���ߤ��Ƥ��ޤä��ˤ⤫����餺�Ǥ���

- AVI�ե�����ϡ�Audio Video Interleaved Format��ά�Ǥ���

- �ޥ��������եȼҤ�1992ǯ��PC�Ѥ˳�ȯ�����ࡼ�ӡ��ե����ޥåȤǤ���

- AVI�ϡ�Windowsɸ���DIB��Device Independent Bitmap = BMP�˲�����Ϣ³�����ե����륷�����֤ˡ�WAVE�ǡ����ʲ����ǡ����ˡ�WAV�ե����ޥåȡˤ߹�����ե����ޥåȤȤ��ƽ�ȯ���ޤ�����

- ����2GB����������2022.04.19�ɵ���

- Windws95�dz�ȯ���줿Microsoft Internet Explorer�ˤϡ�AVI�ե�����ե����ޥåȤ�����饤��ࡼ�ӡ��Ȥ������Ѥ���Ƥ��ޤ����ʱ��ޡˡ�

- AVI�ե�����ϡ�WAVE�����ǡ����ȹ��Τ����Ƥ���ط���RIFF��Resource Interchange File Format�ˤȤ�������ʪ�����Ѥ��Ƥ��ޤ���

- ����RIFF������ʪ����32�ӥåȤ�ʸ�������������뤿�ᡢ�ե�����Υ�������32�ӥåȡ�4,294,967,296 = 4G�Х��ȡˤޤǤȤʤ�ޤ���

- �ޤ����ǡ����̤ˤ����¤��ä���졢16�ӥåȤ�AVI��1G�Х��ȤΥե����롢32�ӥåȤ�AVI��2G�Х��Ȥ����¤Ȥʤ�ޤ���

- �ե�����̤���2GB�ʲ��ˤ��Ƥ⡢AVI�ǤϺ��������̤�Ʊ���Υ����ΰ����ݤ���褦�ǡ����ΤȤ���2GB���̤�Ķ����ȥ��顼�Ȥʤ�������Ǥ��ʤ��ʤäƤ��ޤ��ޤ���

- ¿���Υޥ����ǥ����ǡ����ˤ����ơ�1��B��2GB�Υǡ����Ͻ�ʬ�����̤Ǥ��������ȥࡼ�ӡ��˴ؤ��Ƥϡ����θ¤�ǤϤ���ޤ���

- �ӥǥ��¤Υ�����ƥ��ǰ������Ȥ���ȡ����äȤ����֤˥�����ɤ��ͤ������äƤ��ޤ��ޤ���

- 2000ǯ�ʹߤι�®�٥����Ǥϡ�������2GB����4GB�Υ���ʻ��ˤ�16GB��32GB�ˤ���ܤ��Ƥ��ơ����Ƥ���������ѥ������ž�����Ƥ��Τޤ����ե�����Ȥ�����¸���褦�Ȥ��������ˤ���ޤ���

- 2022ǯ�����Ǥϡ������̤Υǡ�����RAW�ʳƥ�����ȼ��θ������ե�����ˤ���¸���뷹���ˤ���ޤ���

- RAW�ϡ�������ζ��뤹��ӥ��Ǥʤ��Ⱥ����Ǥ��ޤ���

- AVI�ե�����ϡ��ȤƤ�Ť����ʤǷѤ����Ѥ�����¸³���Ƥ��뵬�ʤǤ����顢4GB�Τ褦������ʥǡ�����AVI�ե�����������Ȥ���Ȥ��������ʾ㳲�������ޤ���

- ����ˡ���ȯ���Υޥ��������եȼҤϡ�1997ǯ��13ǯ�ʾ�����ˤ˥��ݡ��Ȥ���ߤ��Ƥ��ޤ��ޤ�����

- AVI�Ǥϡ��ɤ��ˤ��ĥ�����ʤ��Ȥ������ȤΤ褦�Ǥ���

- �ޥ��������եȤϡ�1996ǯ��AVI���Ѥ��ե����ޥåȤȤ���ASF��Advanced Streaming Format�ˤ��о줵������ڤ�Ϥ���ޤ�����˧������̤ˤʤ�ޤ���Ǥ�����

- �����ǡ��ޥ��������եȤϡ�WMV��Windows Media Video File�˥ե������2000ǯ���о줵����WindowsOS��ɸ��ư��ӥ奢�Ǥ���MediaPlayer��ɸ��ե����ޥåȤˤ��ޤ�����

- WMV�ݡ��Ȥ��븽�ߤ�MediaPlayer�Ǥϡ������������AVI�ե�������ɤ߹��ळ�ȤϤǤ��ޤ���

- �������ʤ��顢OS��AVI���Τ�Τε��ʤ��鳰�줿2GB�ʾ�����̤����AVI�ե�������Ф��Ƥϡ��桼��������Ǥ�ˤ����ƽ������ʤ���Фʤ�ʤ�����Ȥ��ƻĤäƤ��ޤ���

- �����ϸ��äƤ⡢��¬ʬ��Ǥ�ư������Ǥ�2020ǯ�����Ǥ�AVI�ϰ���Ū�˼�ή�Ǥ���

- ¿���η�¬��ư��������եȤ������ߤ�ʤ�AVI�ե�������ե�����ե����ޥåȤȤ���MPEG��WMV�ե�����ˤ��б����Ƥ��ʤ��Τ��¾�Ǥ���

- DVD�ʤɤαDz褬MPEG2�ε��ʤ�ư��������¸�������Ƥ��뤿�ᡢAVI���ΤϷ�¬����Ū�Ȥ���ʬ��˸¤���褦�ˤʤäƤ��ޤ�����

- �ʤ���AVI������Ȥ��Ƥ���Τ��ȸ����ȡ�AVI�ϰ������β�����ʬΥ������¸�Ǥ��뤫��Ǥ���

- ��������AVI�Υ����ǥå��ˤϡ�MPEG�䡢H.264�ʤɤλ��ְ���������ФƤ����Τǡʤ�������������Ψ���⤯�Ʋ�����ɤ��ˡ��������������ǥå�����ä�AVI���¬�˻Ȥ����ˤϡ�����ξQ�Ǥ����AVI�ϰ�����礬��Ω���������פȤ����ͤ����Ǥ��ʤ��ʤꡢ����������Ǥ�����ˤʤ뤳�Ȥ�����ޤ���

- ��AVI�ե�����ΰ��̡�-�����̥����ǥå���

�����ǥå���Codec�Ƚ�Compression & Decompression ��ά�Ǥ���

- ���̤���Ĵ�Ȥ�����̣�Ǥ���

- AVI�Ǥϡ��ǡ����ΰ��̥ᥫ�˥��ब�����ƥ��OS�ˤ��Τ�Τȴط��ʤ���Ω���Ƥ���Τǡ����̥����ǥå��ɥ饤�Ф����ȡ��뤵��Ƥ���С����������ʥ����פΰ��̤���ǽ�Ǥ���

- �դˡ�Ŭ�ڤʥɥ饤�Ф����ȡ��뤵��Ƥ��ʤ��Ȱ��̤��줿�ǡ������ɤ߽Ф������������Ƹ�����ޤ���

- ���Ѥ��Ƥ��밵�̥����ǥå��˴ؤ������ϡ��ӥǥ����ȥ��Υإå���4ʸ����ID�Τ������ǵ�Ͽ���졢�������˻��ꤵ�줿�ɥ饤�Ф��ɤ߽Ф��Ʊ�����Ƹ�����褦�ˤʤäƤ��ޤ���

- �����ǥå���ͭ̾�ʤ�ΤǤϡ�����ƥ뤬��ȯ����Indeo��1992ǯ���ˡ�SuperMac�Ҥ���ȯ����Cinepak��1992ǯ���ˡ��ޥ��������եȼҤ���ȯ����Microsoft Video1��1992ǯ���ˡ�MotionJPEG���̡�MPEG���̡�H.264���̤ʤɤ�����ޤ���

- ����ɽ�ˡ��Ƽ�Υ����ǥå�����¸����AVI�ե�����Ȥ������̤���Ӥ��ޤ�����

- ɽ�ΰ��ֺ���TIFF��Ϣ�֥ե������21��ι�פǤ���

- ��AVI��TIFF�ե�������������Τ�ΤǤ�����ե��������̤�Ʊ���Ǥ���

- ���ֱ���QuickTime��AVI�ե�����ǤϤ���ޤ���2010ǯ�����ǰ��ְ��̤��褯�Ʋ�����褤�Τǻ��ͤޤǤ���Ӥ�����ޤ�����

- AVI�Ϻ���Ť������פΥե����ޥåȤǡ�����ƥʤȤ�����̾����Ĥۤɡ��Ĥޤꡢñ�ʤ�Ȣ�Ȥ����ۤɤˤʤäƤ��ޤ��ޤ�����

- ����Ȣ�ˤ��������ʥ����ǥå���Codec�ˤ�ųݤ���AVI�ե�����Ȥ��Ƥ��ޤ���

- �Ǥ����顢�ҤȤ�����AVI�ȸ��äƤ�ɤΥ����ǥå��dz�Ǽ�������ä�����İ����Ƥ���ɬ�פ�����ޤ���

- ��2GB�ʾ�Υե��������AVI2.0��

- �ޥ��������եȼҤ����ݡ��Ȥ���ߤ���AVI�ե����ޥåȤ�Ȣ������褫���ơ����ߤǤ�Ȥ���褦�ˤ������ʤ�AVI2.0�Ǥ���

- ���ε��ʤˤϡ��ޥ��������եȼҼ��Τϴ�Ϳ���Ƥ��ޤ���

- ����ϡ�1996ǯ�˲����ܡ��ɥ����Matrox�Ҥ��濴�ˤʤäơ�OpenDML��Open Digital Media Language�ˤȤ������Ѥ��ꡢ���ε��Ѥˤ���OpenDML AVI��AVI2.0�ˤ���ޤ�����

- ����AVI�Ǥϡ�2GB�ʾ�Υե����뤬������褦�ˤʤꡢ�ޤ���MotionJPEGư���AVI�ե����ޥåȤǺ����Ǥ���褦�ˤ��ޤ�����

- Sony��VAIO�ϡ������ƥ�ˡ�DVgate�פȸƤФ��ư���Խ����եȤ�Ʊ������Ƥ��ơ������2GB��ۤ���AVI�ե�������뤳�Ȥ��Ǥ��ޤ���

- �ޤ���ư��������ץ��㡼�ܡ��ɤäƤ��륫�Ρ��ץ��Ҥ�AVI2.0����¸�Ǥ���ư������¸���եȥ��������äƤ��ޤ���

- Adobe�Ҥ�ư���Խ����եȥ�������Premier�פǤϡ�ver.6.0����OpenDML AVI���б����Ƥ��ޤ���

- �����δĶ��Τ���ѥ�����Ǥ�2GB�ʾ��AVI�ե������������뤳�Ȥ��Ǥ��ޤ�����¿���Υѥ�����ˤϤ��Τ褦�ʴĶ���������ʤ���礬¿���Τǡ�������������AVI�ե���������ۤ���Ȥ��ˤϡ����ä���꤬�����Ǥ��뤳�Ȥ��ǧ����ɬ�פ�����ޤ���

- �ޤ���2GB��ۤ���AVI�ե���������ˤĤ��Ƥϡ����ȷ�AVI��Reference AVI�ˤȤ�����Τ�¸�ߤ���ʣ����AVI�ե�������ڤ��ؤ��ʤ��������³���ơ���������2GB�ʾ���ɤ�ۤ�����ˡ���äƤ����Τ⤢��ޤ���

- ������ˡ����AVI�⡢������ˤ��μ��ư��ե����뤬�����Ǥ��뤳�Ȥ��ǧ�����ۤ�ɬ�פ�����ޤ���

- 2GB�ʾ�Υե���������ư�����ξ��ˤϡ�JPEG�ʤɤ�1��ñ�̤��Ż߲��Ϣ�֤ǰ�ĤΥե����������¸������ˡ���μ¤ȹͤ��ޤ���

- AVI�ǰ�ĤΥե�����ˤޤȤ��Τϡ��ǡ������������Ƥ��ޤ鷺��������¦�̤�����ޤ�������¬�Ȥ�����������ϡ���İ�Ĥ��Ż߲�Dz���������Ȥ����Τ����ܤʤΤǡ��Ż߲��Ϣ�֥ե����������ޤ���

- �ѥ�ݥ���Ȥ�ư������Ž���դ�����ϡ����Υե����뤫�顢ɬ�פ��ϰϤ�ȴ����ꡢɬ��ʬ�ʲ��ǥ��������Ѵ�����MPEG2�ʤɤΰ��̥ե��������¸������ˡ�����ޡ��Ȥ��ȹͤ��ޤ���

- ��64bit��AVI��32bit��AVI������2020.03.01�ɵ���

- AVI�ϡ�1992ǯ�˺��ꤵ�줿ư��ե����ޥåȤ�1997ǯ�˥��ݡ��Ȥ��ޤ�����

- ���äơ�AVI��32bit��CPU�dz�ȯ���줿��ΤǤϤʤ������ǥå���ۤȤ�ɤ�32bit�Ķ��dz�ȯ���줿���ᡢ64bit�Ķ��Ǥϻ��Ѥ��뤳�Ȥ�������뤳�Ȥ�Ǥ��ޤ���

- ��¬ʬ��Ǥϡ��Ť���Indeo�����ǥå����Ȥ�졢DivX��Xvid��VCM9��Cinepak��Ȥ��Ƥ��ޤ�����

- �����ϡ�32bit �б��Υ����ǥå�����

- 64bit�Ķ���AVI��������Τϡ��̡�uncomp�ˤ�microsoft��cinepak��3�������٤Ǥ���

- H264�����ǥå��ϡ����ߤΤȤ����Ǥⰵ�̤��⤯���IJ�����褤��ΤǤ���

- ����ɡ����Υ����ǥå���Windows7/Vista/8/10��ɸ��ǥХ�ɥ뤵��Ƥ��ʤ����ᡢ���ӥ��ȡ��뤹��ɬ�פ�����ޤ���

- ����ϡ���x264vfw download / SourceForge.net�פ������������ɤ��ޤ���

- ��WMV�ۡ�Windows Media Video�����֤�夨��֤�����2000.06�ˡ�2020.03.01�ɵ���

- �ޥ��������եȼҤ���AVI�ե�����ڤ�ASF�ե���������뵬�ʤȤ���2000ǯ��ȯɽ�����ǥ�����ӥǥ��ο������ץ�åȥե�����Ǥ���

- 2020ǯ�λ����ǤϤ��Υե����ޥåȤǤ�ư��Ϥ��ޤ�Ȥ��Ƥ��ޤ���

- ���ޥۡ�2009ǯ iPhone�ˤǤ�ư�����MP4( = MPEG-4)���Ȥ��ϤᡢYouTube�ʤɤΥ����ͥåȾ��ư��Ǥ�MP4�������Ȥ��Ƥ��뤳�Ȥ��顢���Υե�����ե����ޥåȤϻȤ��뤳�ȤϤʤ��ʤ�ޤ�����

- ���äơ�2010ǯ��ʹߤ�ư��ϤۤȤ�ɻȤ��Ƥ��ޤ���

- AVI�ե�����θ�ѥե�����Ȥ����о줷��WMV�ϡ�AVI����ٹ⤤����Ψ�������̲����ޤ��Ƥ��ޤ���

- ���Υե�����ϡ����ְ��̤Ƥ���Τ�AVI���ꥸ�ʥ��1��1�����¸��������ȤϤʤäƤ��ޤ���

- MPEG���̵��Ѥ���Ѥ��Ƥ��ޤ���

- MPEG���̤Ȥ��äƤ�ޥ��������եȼҤ��ȼ��˼��ä���MS-MPEG4�ʤΤǡ��ߴ���������ˤʤä����Ȥ⤢��ޤ�����

- ������ˤ����¬ʬ��ˤϻȤ��Ť餤�ե����ޥåȤǤ�����

- WMV�ե�����ϡ���ȯ����ϥ����ͥåȾ�ǽ����˿�Ʃ���Ƥ��ޤ�����

- Windows Media Player ��ɸ���ư��ե�����Ȥ����硹Ū�˺��Ѥ����а塢����ƶ��Ϥ��礭�ʤ�ΤǤ�����

- AVI�ե����뤬1997ǯ�˥��ݡ�����ߤ줿�塢��¿��������Ф�Windows��ư��Ϥ��Υե����ޥåȤ�����夭�ޤ�����

- ���������桹��¬ʬ��Ǥϰ����Ȥ���AVI�ե���������Ѥ�¿���Τ��¾�Ǥ���

- WMV�ե�����ϡ���¬�Ѥ�ư��������եȥ������Ǥ�ǧ�����ʤ��褦�Ǥ���

- ��¬ʬ��ˤʤ�WMV����Ʃ���ʤ��Τ��Ȥ����ȡ�WMV�κ��Ѥ��Ƥ��밵��������MS-MPEG4←MPEG4�ȼ㴳�㤦�ˤ���¬ʬ��ˤ�����ʤ�������ȹͤ��ޤ���

- ��¬ʬ��Ǥ�ư���1��1����Ω���Ƥ����ۤ�����¬��ط����Թ礬�ɤ��ΤǤ���

- ���ΰ�̣��AVI�ϡ��Ť����ʤʤ��餽�δꤤ�ˤ��ʤä��ե����ޥåȤʤΤǤ���

- ��QuickTime�ۡʤ����ä��������������2010.03.27�ɵ���

- QuickTime�ʤ����ä�������ˤϡ�����ԥ塼��ư��ե������Ϸ��Ū�ʤ�Τǥ��åץ�Ҥ�1991ǯ�˻��ͤ���ޥ����ǥ����ե����ޥåȤǤ���

- 20ǯ����ˤ�����ޤ���

- �ޥ��������եȼҤγ�ȯ����AVI�ϡ�QuickTime����˰ռ�����1ǯ�٤�ǥ������줿��ΤǤ�����

- QuickTime�ν���Τ�Τϡ����̥��르�ꥺ��Ȥ���SuperMac Technology����ȯ����CinePak����ܤ��Ƥ��ޤ�����

- �ѡ����ʥ륳��ԥ塼���Ǻǽ��ư��ä��ե����ޥåȤȤ�����ˤ˻Ĥ��ΤǤ���

- ���Υե����ޥåȤϡ�2010ǯ�ˤ��äƤ�Ƕ���ư��ե����ޥåȤȤ��ƻȤ��³���Ƥ��ޤ���

- QuickTime������Ū�ʥե������ĥ�Ҥϡ�mov���뤤��qt�Ǥ���

- QuickTime�ϡ��ࡼ�ӡ����������������갷�����ޤ����Ū��ñ�˥ࡼ�ӡ����뤳�Ȥ��Ǥ��뤿�ᡢ�����ͥåȤǤ���ɽŪ�ʥե����ޥåȤȤʤ�ޤ�����

- QuickTime�Ϥޤ����ӥǥ��ǥå��������桢�ӥǥ�����ץ��㡢�ǡ������̡���ǥ�����Ʊ�������ʤɤε�ǽ�Ȥ�������Ѥ��뤿��Υġ���ܥå����ʥ����ƥ�ˤ����Ƥ��ޤ���

- ���Υǡ����Υե�������QuickTime�ࡼ�ӡ��ե�����פȤ����ޤ���

- QuickTime��̾����ư���ѥե�����ե����ޥåȤȤ��Ƥ��ޤ�ˤ�ͭ̾�ˤʤäƤ��ޤ��ޤ��������ºݤˤϡ��Ż߲衢�ƥ����ȡ�������ɡ�MIDI�Ȥ��ä����ޤ��ޤʥ�ǥ��������Ȥ��Ǥ��������Υ�ǥ�������ּ����ɤä����椹�뤳�Ȥ��Ǥ��ޤ���

- �����å�������ϡ���ȯ���顢AVI�Ȥ褯��Ӥ���ޤ�����

- ���������ޥ����ǥ����Ķ�����ּ��˽��ä�Ʊ������������������Ǥ�AVI�Ȥ���٤�Τˤʤ�ޤ���Ǥ�����

- 1993ǯ�ˤϡ�Windows��Ǻ������뤿��κ�������QuickTime for Windows��ȯɽ���졢Windows��Ǥ������ǽ�Ȥʤ�ޤ�����

- �����1998ǯ�ˤϡ�Java�ǤΡ�QuickTime for Java�פ�ȯɽ����ޤ�����

- QuickTime�ࡼ�ӡ��ե�����Ǥϡ�RIFF��Resource Interchange File Fomat�ˤΥ�������������Τȥ��atom�ˤȤ����ޤ���

- ����������ϡ�32�ӥåȤ�����դ������Ȥ��ư����Τǡ������Ǥ���ΤϺ���2G�Х��ȤޤǤǤ���

- �����AVI�Ǥ�Ʊ���Ǥ����Ƕ�Υե�����ϡ�2GB�ʾ�Υե��������̤С����뤿��˥�����쥹�˥ե�������ɤ߽Ф���ǽ���ɲä��Ƥ��ޤ���

- QuickTime�ϡ������ɤ��Ǥ��������ͥå��̿���ư��ե�����ǡ��Dz���ͽ���ԡ�Trailer�ˤǤ���ǽ�Ϥ���ʤ�ȯ�����Ƥ��ޤ��ʲ����ȡˡ�

- �ϥ��ӥ�����б���QuickTime�β���ϡ����˥��쥤�Dz����⥯�ꥢ�Ǥ���

- �ޤ������ͥåȾ��ư�������������ݤˡ��ǡ����̿��ʥ��ȥ�ߥˤʤ��������Ǥ��ޤ���

- ���ε�ǽ�ϡ�QuickTime��RealPlayer����Ĥ����ǤƤ��ޤ���

- ���åץ�Ҥϡ�2001ǯ��ȯ��Ϥ���iPod�������ˤ�ꡢiTune��ư��ե������QuickTime��ɸ�������������ꡢ�ǥ�����ư���Խ����եȡ�Final Cut Pro�פ�QuickTime��ɸ������Ȥ��Ƥ��ޤ���

- �����å�������ץ졼��ˤ��Dz��ư�襵��ץ�ν̾������� ���ꥸ�ʥ�ϡ�1280��532���ǤΤ�Τǡ�H.264�ǥ���������ѡ�

- �Dz��ѤΥȥ졼��Ǥϡ��ե�ϥ��ӥ�����1080p�ˤǤΥ���ץ����ۤ�ԤäƤ��롣

- ���ߤ�QuickTime��QuickTime7��2005ǯ�ˤϡ�MPEG4�˲ä�H.264/AVC��ɸ��ե����ޥåȤˤ��Ƥ��뤿�ᡢ�ߴ����ι⤤��ΤˤʤäƤ��ޤ���

- 2009ǯ�ˤϡ�MacOS���������ʤä����Ȥˤ���Mac OS ver.10.6 Snow Leopard�ˡ�H.264���̤��®��������QuickTimeX��ȯ�䤷�ޤ�����

- ����ϡ�iPhone���������줿ư��������Ѥ��Ѥ�����Τǡ������Υϥ��ӥ��������ȥ쥹�ʤ��Ѵ�ɽ����������¸�Ǥ��뵡ǽ���äƤ��ޤ���

- �����QuickTime7�Ȥϸߴ������ʤ���MPEG-4/H.264���ò�������ΤǸŤ�ư��ե�������ɤ߽Ф����Ȥ��Ǥ��ޤ���

- QuickTime7��QuickTimeX�϶�¸�Ǥ���Τ�ξ�Ԥ�ѥ�����˥��ȡ��뤷�ƻ��Ѥ��뤳�Ȥ��Ǥ��ޤ���

- ���Ū�˸��ޤ��ȡ�QuickTime�ϰʲ��Τ褦�ʿʲ���뤲�Ƥ��ޤ���

- 1991��QuickTime1��������ԥ塼����ư���ǽ�Υӥǥ��ե����롣CD-ROMư�����κ�����Cinepak���̵�����ܡ�

- 1994��QuickTime2�����ե륹�����ӥǥ���Windows�б���MPEG-1�б���

- 1998��QuickTime3�����ꥢ�륿����ɽ���ʥ����ͥå��б��ˡ�Java�б���H.261��H.263�б�

- 1999��QuickTime4�������ȥ�ߥ��ѳ�ĥ��QuickTime TV��Macromedia Flash�б���

- 2001��QuickTime5����Sorenton Video3����ĥDV��Macromedia Flash4�б�

- 2002��QuickTime6����MPEG-4�б���3GPP��3GPP2�б���MPEG-2�����б���JPEG2000�б���iTunes��ɸ��������Apple Lossless codec���ѡ�

- 2005��QuickTime7����H.264�б����ե륹��������档

- 2009��QuickTimeX����iPhone OS��곫ȯ��H.264�ե�������®������

- ������������������������Mac OS ver.10.6��Snow Leopard�ˤ˥Х�ɥ롣

- ����������������������������ƥ�64bitCPU���б��������QuickTime�Ȥ��̥饤��Τ�Ρ�

- �������������������������Ť�Macintosh��Windows�ˤ��б����Ƥ��ʤ���

- ��Motion-JPEG�ۡʤ⡼��������ڤ��ˡ�����2010.06.29�ɵ���

- �Ż߲����ե����ޥåȤǤ���JPEG���®�ǿ�ĥ�������ơ�Ϣ³�������뤳�Ȥ�ư��˸��������������Ǥ���

- M-JPEG�ʤ��ࡦ�������ڤ��ˤȤ�ƤФ�Ƥ��ޤ���

- MPEG-2���ѥ�����ǥ��ȥ쥹�ʤ��Ȥ���褦�ˤʤ�ޤǤ褯�Ȥ��Ƥ�����ˡ�Ǥ���

- �������줿���������ΤǤϤ���ޤ���JPEG�����ʲ�����Ƥ���4ǯ���1996ǯ���˵��ʲ��ؤβ�礬��ȯ�ˤʤꡢ�ʸ塢�ӥǥ��Խ�����������¬����Ǥ褯�Ȥ���褦�ˤʤ�ޤ�����

- MPEG�����̽����˻��֤������ä��ꡢ�����˹���ǽ��CPU��ɬ�פȤ��Ƥ������ᡢ�����δĶ��������ޤǤδ֡�Motion JPEG�Ͻ�������ޤ�����

- 1996ǯ�����ϡ����Υե��������Τ��ƹ�Zoran�Ҥ�C-Cubed�Ҥ�2�Ҥ����뤹��Motion JPEG�Υ��åץ��åȤ�Ȥ��Τ��Ǥ⥹�ޡ��Ȥ��ä��Τǡ������ܡ��ɤˤ����Υ��åפ���ܤ���M-JPEG�������äƤ��ޤ�����

- 1996ǯ�����ϡ�ư���ѥ�����Ǹ���Ȥ����Ķ������äƤ��ޤ���Ǥ�����

- ����ԥ塼����ǽ�ϡ�CPU��RAM��HDD�����̡ˤ��ȤƤ����ϤǤ��ä����ᡢ��������ư������ˤϲ����ܡ��ɤ�Ȥäƽ������뤳�Ȥ�¿���Ԥ��Ƥ��ޤ�����

- MPEG��ѥ�����Ǻ�뤳�ȤʤɵڤӤ⤷�ʤ�����Ǥ�����

- ��������������ݤ�줿Motion JPEG�ϡ��ӥǥ��Խ�ʬ��ǽ�������2010ǯ�����Ǥ��Խ���ư��ե�����Ȥ��ƻȤ��Ƥ��ޤ���

- Motion JPEG�ϡ�MPEG�Ȱۤʤꡢ���������Ω���������Ȥ�����¸���Ƥ���Τǥե졼��ñ�̤��Խ�����Τ��Թ礬�ɤ��ΤǤ���

- ���θ塢����ԥ塼�������Υ��եȥ�����������M-JPEG�����������褦�ˤʤꡢAVI��QuickTime�Ǥ�Motion JPEG�Υ����ǥ��å�����ȯ����ޤ�����

- �ǥ����륫����ư��ե�����ˤϸ��ߤ�Ȥ��Ƥ��ޤ������Υǥ����륫���ϲ��ǿ���¿���ʤꤹ���������Motion-JPEG����¸����ȵ�Ͽ�������ô��������Τǡ����̸�Ψ���ɤ��ƹ�����H.264����Ѥ��륫��餬�����Ƥ��ޤ���

- Motion JPEG�Ϥޤ������ѤΥϡ��ɥ�������Ȥäƥǡ������̤�Ԥ��ʤ���ꥢ�륿�����ư��μ����ߤ��Ԥ��뤿�ᡢ�ѡ����ʥ�����Υӥǥ�����ץ��㡦�����ɤʤɤˤ��Υե����ޥåȤ����Ѥ���ư������˰��Ϥ�ȯ�����ޤ�����

- �ޤ���Motion-JPEG��MPEG�ǡ����ʤɤȰۤʤ�1���ޤ��Ż߲����Ȥ���¸�ߤ��뤿�ᡢǤ�դβս�Ǥ��Խ����ưפ˹Ԥ��ޤ���

- ����Ψ��1/5����1/20���٤Ǥ��ꡢ���̤���������Ƥ������Ȥʤ�ޤ�����ȯ���������ΰ��̲�����ȤäƲ�����¬��Ԥ����Ȥ����Ȥ��������̤��줿�ǡ�������ư����������Τʰ��־��������ޤ���Ǥ�����

- Motion JPEG��MPEG�ϡ�̾�������Ƥ��ޤ������ե����ޥåȤ��㤤�ޤ���������¬�Ѥ�Motion-JPEG�Ϥ��Ф��лȤ��ޤ�����MPEG���Ը����Ǥ���

- MPEG�ե����ޥåȤǤϲ������Żߤ������ꥳ�����ꤷ�����ž�������뤳�Ȥ������դǤ���

- �ʤ���������ǥե����ޥåȤ��äƤ��ʤ��Τǡˡ�JPEG�����Ǥⰵ�̤��ٹ礤�ˤ�äƤϷ�¬�϶줷���ơ��ɤ���ͤ����ΤǤϤʤ��ʤ�Ȥ�����Ŧ��¿������ޤ���

- ������¬�ˤϤ��ޤꤪ������Ǥ��ʤ��ե����ޥåȤǤ���

- �����ϸ��äƤ�2010ǯ�ˤ��äƤ�MPEG���������̤˽в�ꡢ����ȹ��ޤ���ˤ�����餺�����Ƥ��줿MPEG�������������¬�ʤ���Фʤ�ʤ�������¿���ʤäƤ��ޤ�����

- ��¬���٤Ϥɤ����줽����������ˤʤ�ޤ�������2010.05.25����

- ��MPEG�ۡ�Motion Picture Expert Group�ˡʤ���ڤ�������2009.05.04�ɵ��ˡ�2010.06.27�ɵ���

- MPEG�ϡ�Motion Picture Expert Group ��ά�Ǥ������Υե����ޥåȤϡ�1988ǯ����Ω���줿Ʊ��̾������ĥ��롼�פ�ư�����沽���Ѹ�����椫�����ޤ�ޤ�����

- ����Ū�ʳ�ĥ�Ҥϡ�mpg�����뤤��mpeg�Ǥ���

- WMV��Quick Time�ȰۤʤꡢISOɸ�ಽ���������ͤ���Ƥ��ޤ���

- DVD��ǥ����������ΰ��̥ե����ޥåȤ˺��Ѥ��줿���ᡢ2010ǯ�����ǤϤ�äȤ����Ū��ư�谵�̥ե�����ե����ޥåȤȤʤäƤ��ޤ���

- ����ư��ե����ޥåȤ���ˤ⤢�ꡢ���ʤ�ȯŸ��³���Ƥ���ư��ե����ޥåȤǤϤ���ޤ����������ϰϤ������ʤäƤ��ޤäơ��㤨�С�MPEG-4�Ǥ⤤�������ʥ��ƥ���� = �ץ��ե�����ˤ��Ǥ��Ƥ��ޤ���MPEG�Ȱ���˸��äƤ�����Ǥ��ʤ����������ǤƤ��Ƥ��ޤ���

- ���������ե졼��

- MPEG�ϡ���γ�ǰ�ޤ������Ƥ���褦�ˡ����٤ƤΥե졼��� = ���̡ˤˤ錄�ä���Ω��������������櫓�ǤϤ���ޤ���

- MPEG�Ǥϡ������ե졼��ȸƤФ�����Τβ�����������ե졼�ब���ꡢ����ʳ��ϡ������ե졼��֤�ư���Ƥ������̤�������¸��������������Ƥ��ޤ���

- ������ˡ��Ȥ��С�1�ե졼�ह�٤Ƥ���¸����������餫�˥ǡ����̤����ʤ��ƺѤߤޤ�����ñ�̻��֤����������ǡ����̤⾯�ʤ��Ƥ��ߤޤ���

- �Ĥޤꡢ�����������̿��Ӱ褬�����Ƥ⡢�Ӱ�ʾ�ξ������ı��������뤳�Ȥ��Ǥ���ΤǤ���

- ���οޤϡ�MPEG-2�����������ޤǤ���

- ������MPEG-2��������ħ�����뤳�Ȥ��Ǥ��ޤ���

- ���β����ϱ߷��β�ž���Ĥ˻�Ⱦ�߷�����ݡ����ݤΥ������åȥޡ�����Ž���դ��Ʋ�ž�����Ƥ�������ΰ���Ǥ���

- ���β����γ���ޤ�ȡ��������åȼ�������̤����ȥ�ߥ���ƺ٤������Ǥ˶�ʬ�����졢ư���Ƥʤ��Хå������ɤ��礶�äѤ˽�������Ƥ��뤳�Ȥ��狼��ޤ���

- MPEG�γ�ȯ�ϡ����äơ��ǡ����̿�����٤�ڸ����뤿��˹Ԥ��ޤ�����

- ư������̤Υǡ�����Ϣ�ʤ�³���Τǡ�ư�������ͥåȲ����ʤɤ��̤�������������Ӱ�����Ȥ������꤬�����Ƥ��ޤ��ޤ���

�����Զ����ä������ƤȤ��ơ��ǡ����̤�������Ȥ�����ˡ�����Ѥ��줿�ΤǤ���

- �ǡ������̤ϡ�JPEG�Τ褦�˰���β��̤�̵�̤ʾ����ʤ����ְ��̤ȡ�ʣ���������Ϥä��Ѳ����Ƥ��ʤ��������������ʤ��Ȥ�����ְ��̤�����ब����ޤ���

- ���ְ��̤Ȼ��ְ��̤�2������Ȥ����Ȥˤ�ꡢ���̤�Ԥ�ʤ���AVI�ե��������1/100��1/200���٤ΰ��̤���ǽ�Ȥʤ�ޤ�����

- MPEG�ϡ�1990ǯ���Ⱦ����2000ǯ��ˤ����ơ�DVD�ˤ��Dz�䥤���ͥå��ۿ�������ȥǥ�����ƥ�������˺��Ѥ����褦�ˤʤꡢ���ߤ�ư��ե�����μ��ϤˤʤäƤ��ޤ���

- �������֤��٤�

- ���Υե�����ե����ޥåȤ����դ��ʤ���Фʤ�ʤ����Ȥϡ���Ĥˤϡ��ꥢ�륿����Ǥ��������������ȤǤ���

- �ե�����ι�¤�塢�����ե졼��֤�1�Ȥβ�����GOP = Group Of Pictures�ˤ�ñ�̤Ȥ��ơ�ư���Τ���Ȥ�����������Ф��ư��̽�����Ԥ��ޤ��ʲ����ȡˡ�

- GOP��MPEG�ե���������δ��ܤ����ޤ�Ȥʤ�ޤ���

- MPEG�����ˤ�����ͥ���ʥ�������ɬ�פǤ���

- �桹���ȤäƤ���PC�Υ��եȥ�������Ȥä�MPEG�ե�������ɤ���ˤ������ʻ��֤�������ޤ���

- �ƥ�������Ǥϥѥ�����Τ褦��ͪĹ�ʤ��ȤϤǤ��ʤ��Τǡ����ѤΥ��������֤�Ȥä�MPEG-2�������®�ǹԤ��������Ƥ��ޤ���������������ǽ�������֤�ȤäƤ�����֤Ǥΰ��̽�����Ԥ�ɬ�塢������ί������Ȥ�ޤ�Ƥ��ν����˻���Ū���٤줬�Ǥޤ���

- �������פ���ȡ����褽1��2�����٤��٤�Ȥʤꡢ�ºݤθ��ݤ���٤��������ϩ�����뤳�Ȥˤʤ�ޤ���

- �ޤ����������¦�Ǥ�ͥåȥ�����̿������������Ӱ���̿�®�٤��Ѥ��ޤ���

- ���ξ塢������륳��ԥ塼���Ǥ�MPEG����ɤ��ƺ��������������������ޤ��Τǡ������Ǥ⥭���ե졼��Ⱥ�ʬ��������ư�������ۤ��뤿��ν������֡��٤���֡ˤ�и礷�ʤ���Фʤ�ޤ���

- �Υƥ�������ϡ��ǥ����������ˤʤ�ޤ�������ɤ⡢MPEG����Ѥ��Ƥ���ط��奢�ʥ���������Ʊ�����Ȥȸ���٤��2�������٤�Ƥ��ޤ���

- �ʻ�����Ͽ�褷����Τϥǥ������٤�����������������äƤ���ɤ⤢�뤽���Ǥ�����

NHK������λ���ʤɤϡ��ΤΥ��ʥ���������饸�������Ǥ���л��֤��٤�ʤ�ɤۤȤ�ɵ��ˤ��������Ǥ����Τˡ��ǥ�����������MPEG-2�Ǥϥǥ������٤줬�ФƤ��ޤ��Τǥ����ӥ���ߤ�Ƥ��ޤ��ޤ�����

- �ǥ�����ʤɤȤ�������ǽ����̾��Τ褦�ʶ������������ˡ�����Ū���٤줬���ʤꤢ��Ȥ����Τ϶ä��Ǥ���

- ����Хåե��˲��������ί�����Ǻƹ��ۤ���ǥ������ˡ�Ǥ����̤�ʤ���ħ�Ȥʤ�ޤ���

- ����I�ե졼�ࡢP�ե졼�ࡢB�ե졼��

- MPEG�Ǥϡ�3����Υե졼�ब�Ȥ��Ƥ��ޤ���

- ����I�ե졼��

- ����P�ե졼��

- ����B�ե졼��

- ����3�Ĥ�GOP����˳�Ǽ����Ƥ��ޤ��ʾ���ȡˡ�

- �����ե졼��ϡ���I�ץե졼���Intra coded Frame�ˤȸƤФ�Ƥ��ޤ���

- ��ʬ��������ξ��������̾���ե졼����P�ץե졼���Predicted Frame��ͽ¬�ե졼�ࡢ�ǥ륿�ե졼��ˡ�����ӡ�B�ץե졼���Bi-Predicted Frame��������ͽ¬�ե졼��ˤȸƤ�Ǥ��ޤ���

- ��I�ץե졼��ϡ����ʴ��뷿�Υե졼��Dz������Τξ������äƤ��ޤ���

- ����ϡ������ե졼��Ȥ��ƻȤ��ޤ���JPEG�ʤɤ���ְ��̤�ۤɤ����ƤϤ����ΤΤ��켫�Τˤ��٤Ƥβ�������������碌�Ƥ���Τǡ�I�ץե졼�������ޤ���

- ��P�ץե졼��ϥǥ륿�ե졼�ࡢ�⤷����ͽ¬�ե졼��Ȥ�ƤФ졢ľ���Υե졼���I�ե졼��⤷����P�ե졼��ˤȤ����Ѳ����������Ȥ��Ƶ�Ͽ���Ƥ��ޤ���

- ��P�ץե졼��Ͻ�������ñ�Ǥ������Ѵ���Ȥ��Ԥ��䤹��ȿ�̡����̤ˤ�³������ꡢ����Ψ���Ū�˾夲�뤳�ȤϤǤ��ޤ���

- ��B�ץե졼��ϡ��������ե졼��ȸƤФ���Τǡ�ľ����ľ��Υե졼���I�ե졼���P�ե졼��ˤȤ��ƺ�ʬ��Ͽ�����ΤǤ���

- �Ĥޤꡢ����Υե졼������Υե졼�������κ�ʬ����¸���뤿�ᡢ��P�ץե졼����⤵���;ʬ�ʾ�������Ȥ����Ȥ��Ǥ����̤���뤳�Ȥ��Ǥ��ޤ���

- ��B�ץե졼��ϡ�����������ʣ���ˤʤ�ޤ����顢���̡�����ˤϽ������֤���٤�������ޤ���

- ��

- ����������¬�Ȥ��Ƥ�MPEG

MPEG�Ǥ⤦������դ��ʤ���Фʤ�ʤ����Ȥϡ���¬��Ū�Τ����MPEG��Ȥ��Τ���Ŭ���Ǥ��뤳�ȤǤ���

- ���Υե����ޥåȤϡ����衢�¤�줿�̿��Ӱ��ư����������Ȥ�����Ū�Ǻ��줿��ΤǤ��ꡢ�ƥ�Ӥ�Dz�ʤɤ��̿����������뤳�Ȥ���Ū�Ȥ��Ƥ��ޤ�����

- �ޤ�MPEG-2�Ǥ�4.7GB�����̤�DVD�˱Dz����¸�������뤳�Ȥ�����ʻ�̿�Ȥ��Ƥ��ޤ�����

- DVD�ˤ��Dz�վޤϡ�Ϣ³������ǰƬ�ˤ���ޤ�����¬�Ѥ�ư�����ϡ��Żߤ������ꥹ����������Ԥä����ž������Ԥ��ޤ���

- ���Τ���������������礫��ʪ�Τ��Ѱ̤���ꡢǻ�٤����٤褯��¬���ޤ�������������Ū�ˤ�MPEG���Ը����Ǥ���

- MPEG�ǤϾ�ǽҤ٤��褦�˥����ե졼���Ĥ��ä�Ϣ³�������ۤ��뤳�Ȥ˽������֤��Ƥ��ޤ����쥳������䥹���å�������ž������Ԥ���硢�������٥����ե졼���õ���ơ�GOP��ˡ˴�˾�����ϰϤǤ�Ϣ³�������ۤ�����Ϣ��ư�������ۤ��ޤ�����������������Ф��������������ϼ����������ʤ���ΤȤʤ�ޤ���

- �����ȳ����Խ���Ȥˤϥ֥��å�ñ�̡�GOPñ�̡ˤǤ��Խ��������餤�����MPEG���Ѥ��Ƥ��餺���ǽ������ʤȤ��ƤΤ��Ѥ��Ƥ��ޤ���

- ���������������顢MPEG�Ϥ���������ʬ�����ƻ��Ѥ���ɬ�פ�����ȸ����ޤ��礦��

- �������ɤǺ��Ѥ���Ƥ���MPEG-4 Studio Profile�Ȥ������ʤϡ��Խ���ǽ��ʬ�˹�θ�������ʤΤ褦�Ǥ�����

- ��

- ���ޤˡ�MPEG-2�ե������ȤäƲ�ž�Τ�Ž�դ����������åȥޡ������Ѱ̤�ץ��åȤ����ޤ��ޤ���

- �ץ��åȿޤϡ������˥ե졼�ࡢ�ļ��˲�ž���륿�����åȤ�Y�����ʿ�ľ�����ˤ��Ѱ���ʬ���Ƥ��ޤ���

- �о�ʪ�ϲ�ž��ư�Ǥ�����Y����ʬ��ñ��ư�ʥ������֡ˤˤʤ�Ϥ��Ǥ���

- �ޤƤߤޤ��Ȥ��⤷�������Ȥ˵��Ť��ޤ���

- 15�ե졼����˥��֤Τ褦����ʬ������Ƥ��ޤ���

- MPEG-2�ե�����Υ��ꥸ�ʥ�ե������AVI�Ǥ���

- AVI����MPEG-2�ե��������ޤ��������ꥸ�ʥ�ե������AVI�ե������Ʊ�ͤβ��Ϥޤ��ȡʲ��ޡ����ʡˤ����������֤ϸ�������ޤ���

- MPEG-2�����Ǥɤ����Ƥ��Τ褦�ʥ��֤���ʬ�����Ф����Τ���Ĵ�٤Ƥߤơ����Τ褦�ʤ��Ȥ��狼��ޤ�����

- MPEG-2�����ϡ�GOP��Group Of Pictures�ˤ�ư���դ����Ԥ��Ƥ��뤳�ȤϤ��Ǥ˽Ҥ٤ޤ�����

- ������Ѥ���MPEG-2�����ϡ�15�ե졼��ʬ��GOP��1�֥��å����������Ƥ��ޤ���

- 15�ե졼���1�Ĥ�ư���뤵���Ƥ��ޤ���

- �����Ǥ�����ϡ�GOP�Υ֥��å��֤ΤĤʤ��ܽ��������ޤ����äƤ��ʤ����Ȥ˵������Ƥ��ޤ���

- 15���֤�ư���դ��Ϥ��ޤ��Ԥ����ΤΡ�GOP��ޤ����Ǽ��κǽ�Υե졼�ब���ԥ�����ʬ��֤Ǥ��Ƥ��ʤ�����������ޤ�����

- ��������β�褬����Τ��ɤ����Ϻ��ΤȤ����狼��ޤ���

- MPEG-2�Υ������饤�����줿�ե����ޥåȤ�Ȥ��ȡ������������꤬�����Ƥ��ޤ����Ȥϻ��¤Τ褦�Ǥ���

- �����������褹�뤿��ˡ�MPEG-2�ե��������ݤˤ��٤Ƥβ���ʬ���ɤ߹������֥ե�������äơ�������������Ȥ�����ˡ������ޤ���

- ��ޤβ��ϤǻȤä�MPEG-2�ե������TIFF��Ϣ�֥ե�������Ѵ���¸���ơ�Ʊ�ͤβ��Ϥ�Ԥä��Ȥ������֤��Զ��Ϥʤ������줤��ñ��ư�ȷ��������ޤ�����

- �����������Ȥ��顢MPEG-2�������ܼ�Ū�˲��Ϥ��Ը����Ǥ��뤳�Ȥ�����Ǥ��ޤ���

- ��¬��Ū�ˤϤǤ������MPEG-2�ϻȤ鷺��TIFF��JPEG��Ϣ�ֲ������Ѥ��뤫��AVI�ե�������Ѥ��뤳�Ȥ����ȥ쥹�ʤ���ˡ���ȹͤ��ޤ���

- ��������MPEG-2�Ǥ��������ե����뤬����Ǥ��ʤ����ϡ����Υե�������öAVI�ե����뤫TIFF�ե�������֤������Ʋ��Ͻ����˲��Ȥ�̵����ȹͤ��ޤ���

- MPEG-2�ե�������礭����ħ�Ǥ���2���֡�220,000���720x480���ǡˤˤ�錄��Ĺ����Ͽ��ե��������Ϥ�������硢�����쵤�˲��Ϥ���ͭ���ʼ���ƤϺ��ΤȤ�������ޤ���

- ���ξ��ˤϡ�Ĺ����Ͽ�褵�줿�ե��������Dz��Ϥ�ɬ�פ��ϰϤ���������AVI��TIFF�˥ե������Ѵ����ơ����Υե�����ǽ�����Ԥ��Τ���ñ�ǰ²�����ˡ���Ȼפ��ޤ���

- ��¬�����ˤ�äƤϡ�Ĺ����Ͽ���PC�Υϡ��ɥǥ�������ľ�ܽ���Ǥ�����Τ����ꡢ����������Τ��Ż߲��������¸�����Τ�¿���Τǡ���¬�ϥ��ࡼ���˹Ԥ����Ȥ��Ǥ��ޤ���

- ��

- �� MPEG-1��

- MPEG-1�ϡ�MPEG�ե����ޥåȤκǽ�ε��ʤǤ��ꡢ1993ǯ�˵��ʤ����ꤵ��ޤ�����

- ����MPEG-1�ϡ�ž��®�٤�1.5M�ӥå�/�äǡ�������������352 x 240 ���ǤǤ��ꡢ30�ե졼��/�ä�Ͽ�褬�Ǥ��ޤ�����

- �����鸫��ȿ�ʬ�����������Ǥ������β����������ϥƥ�Ӳ�����1/4�Ǥ��ꡢ�ƥ�Ӥ�ο���Ȥ�����ǽ�ǤϤ���ޤ���Ǥ�����

- MPEG-1�����줿��1993ǯ���������ǡ����̿���ѥ�����ν���ǽ�Ϥ�ͤ����顢���ε��ʤ������դ��ä��Τ����Τ�ޤ���

- MPEG-1�Υǡ���®�٤ϡ�����Ǥ������Υ����ͥåȤ˾褻�뤳�ȤϤޤä����Բ�ǽ�Ǥ�����

- 1990ǯ����Ⱦ���̿������ϥ��ʥ������õ��β������ۤȤ�ɤǡ������1.5M�ӥå�/�äΥǥ������̿���Ԥ����Ȥ��Բ�ǽ���ä��ΤǤ���

- �����Υ������륢�åײ������̿�®�٤�28.8k�ӥå�/�ä��ǹ���ǽ�Ǥ��ꡢMPEG-1���᤹��1/52����ǽ��������ޤ���Ǥ�����

- ���äơ�MPEG-1�ϡ�CD-ROM��ư������Ͽ������ʤȤ��Ƴ�ȯ���졢Video-CD�ʤɤ˻Ȥ��ޤ�����

- CD�ξƤ�����®�٤����Υ졼�ȤǤ�����

- MPEG-1�ϡ�2010ǯ�ˤ��äƤϤ���������MPEG-4���Ȥ���褦�ˤʤ�ޤ�����

- MPEG-1�Υ����ǥ����ե�����Ǥ����MPEG-1 Audio layer-3�פ����ϡ�MP3�Ȥ���2010ǯ�Ǥ�¿���Ȥ��Ƥ��ޤ���

��

- �� MPEG-2��

- MPEG-2�ϡ�1995ǯ�����ꤵ��ޤ�����

- ����ϡ�HDTV�ʥϥ��ӥ����ƥ�ӡˤޤǥ��С�����ǥ�����ӥǥ��Ѥε��ʤǤ�����

- ���ε��ʤǤϡ�MPEG-1�˲ݤ����ӥåȥ졼�Ȥ����¤���ž��®�٤�4Mbps��24Mbps�Ȥ��ޤ�����

- ��갷��������ϡ�720 x 480 �� 1920 x 1080�Ȥʤꡢ�ƥ�Ӳ������ʼ���ռ����ƥϥ��ӥ����ˤ��б��Ǥ����ΤȤ��ޤ�����

- �֥����ɥХ�ɤΥ����ͥåȤˤ��б��Ǥ���褦�ˤ������ᡢMPEG-2�ϥͥå��ۿ��Ǥ���ư�����γθǤ����ϰ̤��Ω���ޤ�����

- �ޤ���DVD�˺��Ѥ��줿���ᡢ�Ǥ�ͭ̾�ʵ��ʤȤʤ�ޤ�����

- ��

- �� MPEG-3��

- ��MPEG-3�ϡ�¸�ߤ��ޤ���

- ���Υץ��������Ȥϡ�1080�ܥ����졼��������20 Mbps - 40 Mbps�ˤ��HDTV���������ѤȤ��Ƶ��ʲ����Ϥޤ�ޤ�������MPEG-2����������ǽ��ʬ�˻��äƤ���Ȥ��ơ��Ĥޤꡢ����������MPEG-2��Ʊ���Ǥ��뤿�ᳫȯ�ΰյ����ʤ��ʤꡢ����������Ⱦ�Ф�1992ǯ��MPEG-2�˵ۼ�����ޤ�����

- ���ʤߤˡ����ڥե������ͭ̾��MP3�ϡ�MPEG-3�ǤϤʤ���MPEG-1�Υ����ǥ������ʤȤ��ƽ�ȯ������Τǡ���MPEG-1 Audio layer-3�פ�ά�ΤǤ���

- ��

- �� MPEG-4��

- 1998ǯ�����ꤵ�줿��ư���̿��ѵ��ʤǤ���

- ���ʲ����줿����������ե����ޥåȤϡ�176 x 120 �� 352 x 240 �Ⱦ��������̿�®�٤�64kbps �� 512kbps���٤���ΤǤ�����

- ���ε��ʤϡ�QuickTime��ASF�ʤɤΥѥ�������ư���ޥ����ǥ��������Ѥ��ޤ�����

- ���θ塢MPEG-4�ϼ�갷�����Ƥ������ʤꡢ�ѡ��ȤȤ�������¿�����������ʤ����ޤ졢�̿�®�٤��®�ˤʤ����ǹ��ʰ̤ε��ʤˤʤäƤ����ޤ�����

- 2010ǯ�ˤ��äƤϡ���MPEG�פȤ����Ȥ��Υ��ƥ����ؤ����Ȥ�¿���ʤäƤ��ޤ����������ϰϤ����ޤ�˹����Τ��������Τ���¤Ǥ���

- MPEG-4���Ȥ��Ƥ�����Ѥˤ���1������QuickTime7��iPod��iPad��AppleTV��HD DVD��Blu-ray�ʤɤ����ꡢ�����˺��Ѥ���Ƥ���ư��ե����ޥåȤϡ�MPEG-4 AVC/H.264 �Ȥ������ʤǤ���

- ��

- �� MPEG-7��

- MPEG-7�ϡ������MPEG�ε��ʤȼۤʤ�ޤ���

- ���ε��ʤϡ��ޥ����ǥ���������ƥ�Ĥ˴ؤ��뤵�ޤ��ޤʾ���ε�����ˡ��ɸ�ಽ���ơ�������Ԥä���ե�������ǽ�ˤ��뵬�ʤȤʤ�ޤ�����

- MPEG-7�ϡ�1996ǯ�˥������Ȥ���2000ǯ����ɸ�˵��ʲ���Ȥ��ʤ���ޤ�����

- ��������10ǯ��Ф�2010ǯ�ˤ��äƤ�MPEG-7��̾���Ϥ��ޤ�ʹ���ޤ���

- ���ʤμ�ݤϡ������ͥåȤο�Ÿ��ȼ���������ͥåȥ�ǥ�����ʸ��ե����ޥåȡˤ����줵���Ƹ�����������ưפˤ����褦�Ȥ������������ä��褦�Ǥ���

- ����������̤Ϥ���ۤ�˧������ΤǤϤʤ��ä��褦�Ǥ���

- ư�����˴ؤ���¤�MPEG-7�Ǥ����Ϥ���ۤ��礭���ʤ���2010ǯ�ˤ��äƤ�MPEG-4����ή�Ǥ���

- ��

- ��MPEG-4 AVC/H.264��

- AVC�ϡ�Advanced Video Coding��ά�Ǥ���MPEG-4�Υѡ���10�θƤ�̾�Ȥ���AVC���դ����ޤ�����

- �����ˤϡ���MPEG-4 Part 10 Advanced Video Coding�פȸƤ֤Τ��������ΤǤ�����Ĺ���Τ�ñ��AVC�ȸƤ֤��Ȥ⤢��ޤ���

- �ޤ�����ȯ�������ؤ�º�Ť���H.264���դ��Ƥ��ޤ���

- AVC�ϡ�MPEG-4�Υ��ƥ�������H.264���ʤ�����ơ�Part10�˥饤�åפ����Ȥ������֤Ť��Ǥ���

- AVC�ϡ�2003ǯ�����ꤵ��Ƥ�������˻Ȥ���褦�ˤʤꡢ2010ǯ�ˤ��äƤϤ�äȤ�ͥ�줿ư�������̥ե����ޥåȤȤʤ�ޤ�����

- ��갷���������礭���ϡ�320 x 240���Ǥ���1920 x 1080���Ǥȹ��ϰϤǡ��̿��졼�Ȥ�320kbps��10Mbps���Ͼ�ǥ������������ʤ����ƤϤޤ�褦�ˤʤäƤ��ޤ���

- ���ε��ʤǤϡ�ư������Τ���Υ֥��å���������16x16���Ǥ���4x4���Ǥޤ����֤��Ȥ��Ǥ��٤��������ޤ������������Ǥ��뤿�ᡢ�֥��å��Υ�����⥹�����ȥΥ�����ȯ�����ޤ��뤳�Ȥ��Ǥ��ޤ���

- ��

- ����H.264����

- H.264�ϡ�ư�谵�̥ե�����ε��ʤǤ���MPEG��ISO��IEC���ȿ��β��ǵ��ʲ����줿�Τ��Ф���H.264�ϡ�ITU�ʹ���ŵ��̿�Ϣ�硢International Telecommunication Union�����Ȥ�CCITT�ˤβ����ȿ��Ǥ���ITU-T��Video Coding Experts Group (VCEG)�ˤ�äơ�2003ǯ5��˺��ꤵ��ޤ�����

- �ǽ�ε��ʤǤ���H.261�ϡ�1990ǯ�ˤǤ��Ƥ��ޤ���

- ����ǯ�������иŤ����ʤȸ����ޤ���

- ���줬�ʲ���³����H.264�ˤʤ�ޤ�����

- ���ε��ʤ�MPEG�ˤ���Ѥ���뤳�ȤˤʤꡢMPEG-4�Υѡ���10�Ȥ���������ꤷ�ơ�MPEG-4 AVC/H.264�Ȥʤ�ޤ�����

- MPEG��H.264�ϡ����賫ȯ���Ƥ��뵡�ؤ���äƤ����ΤǤ��������̥��르�ꥺ���Ʊ���Ǥ�����H.264�ϡ�����ͥ���ʥ��르�ꥺ��Ǥ��ꡢ����Ψ���⤤��˲�����������ʤ��ä������MPEG���������Ѥ��ޤ�����

- ISO/IEC�Ǥϡ���MPEG-4 Part 10 Advanced Video Coding�פȤ��Ƶ��ꤷ��̾�������H.264�����äƤ��ޤ���

- �����������Ƥ�H.264���Τ�ΤǤ��뤿�ᳫȯ���ؤ˷ɰդ�ɽ���ƤĤ��˼����褦��ʻ������褦�ˤʤ�ޤ�����

- ��H.264/AVC�� ��H.264/MPEG-4 AVC��

- ��MPEG-4 AVC/H.264��

- ����VC-1��Video Codec 1��

- H.264�Υ饤�Х�ϡ��ޥ��������եȼҤ�VC-1��Video Codec 1�ˤǤ���

- ξ�Ԥϡ�����Ψ������ۤ�Ʊ���Ȥ����Ƥ��ޤ���

- VC-1�ϡ��ޥ��������եȼҤ��ȼ��˳�ȯ����MS-MPEG�Ѥΰ��̥����ǥå��Ǥ��ꡢWindows Media Video 9 ��WMV9�ˤȤ���Windows Media Player�˼�������ޤ�����

- ���줬2003ǯ���ƹ�Dz�ƥ�ӥ���Ѷ����SMPTE = the Society of Motion Picture and Television Engineers�ˤ˿������졢2006ǯ�˵��ʲ�����ޤ�����

- VC-1������̾�Τϡ�SMPTE 421M video codec standard�Ǥ������������̾����Ĺ���Ф����餤�Τǡ����ڤ�������ä�VC-1�θƾΤ������Ȥ��Ƥ��ޤ���

- DVD�ե������Ǥϡ����Υޥ��������եȼҤγ�ȯ����VC-1��H.264�Ǥ���MPEG-4 AVC��ξ�Ԥ�ɬ�ܥ����ƥ�Ȥ��ƾ�ǧ�������ᡢ�ʸ塢������Ĥ�ư�谵�̥ե�����Υ���������ɤȤ��ƻȤ���褦�ˤʤ�ޤ�����

- VC-1�ϡ�HD DVD��Blu-ray�ǥ�������Windows Media Video 9���ޥ��������ե�Silverlight�˺��Ѥ���Ƥ��ޤ���

- ��

- ��DV-AVI�ۡʤǤ��֤������֤�������

- DV-AVI�ϡ�Digital Video AVI ��ά�Ǥ����ǥ�����ӥǥ����ʤΥǡ����Τޤ�AVI�Ȥ�������ʪ�����줿�ե����ޥåȤǤ���

- ��˽Ҥ٤�AVI���ޤ���Ȣ�ˤʤäƤ��ޤä��Ȥ���ŵ��Ū����Ǥ���

- DV-AVI�ϡ�AVI�Ȥ���Ȣ�������Ф���������ư�襽�եȤǺ����Ǥ���Τ������Ǥ���Ȥ�������������졢�ǥ�����ӥǥ�����餫���ư��ե��������Τ���ڤ��ޤ�����

- �ǥ�����ӥǥ������Ͽ�褷��DV�ơ��פ�ѥ��������¸����Ȥ���DV-AVI���Ȥ��ޤ���

- MPEG���Ѵ���������Խ����ڤȤ�����ͳ����Ǥ���

- �������������ʤ���ե��������̤�2GB���ɤ�����ޤ���

- DV-AVI�ե�����κ��ܤϡ��ʲ��˽Ҥ٤�DV�����Ǥ�������DV���ʤ�Motion JPEG����ܤȤ��Ƥ��ޤ�������¬�Ѥ�ư�����������եȤǤϤ��Υե����ޥåȤ��б����Ƥ��ʤ���Τ�¿������ޤ���

- ��

- ��DV�ۡʤǤ���������������2010.07.10�ɵ���

- DV�ʥǥ����롦�ӥǥ����ǥ������ˤϡ�Digital Video��ά�Ǥ���

- �����1995ǯ�˷���줿̱����Υǥ�����ӥǥ����ʤǡ�����Υ��ʥ����ӥǥ��ơ��������������ؤ��ơ��ǥ���������ǡ����Ȥ��Ƽ����ơ��פ˵�Ͽ���뤿��˵��ʲ�����ޤ�����

- �ǥ�����Ͽ��Ǥ����顢����Υ��ʥ�������VHS�ӥǥ��ơ��ץ쥳�����Ȱ�ä��Խ���ʣ����ȼ�����������������ޤ���ʡ��ǥ�����ӥǥ������DV�����ȡˡ�

- ���ε��ʤ��Ǥ��������ˤϡ��ƥ�������Υǥ����벽�ȥѥ��������ڤ��������ޤ���

- 1980ǯ�塢VTR����ڤˤ�ꥢ�ʥ����ӥǥ�����ˤ��ӥǥ����郎������˹����Ԥ��Ϥ�褦�ˤʤ�ޤ�����

- �ʥ��ʥ����ӥǥ�����ˤĤ��Ƥϡ�NTSC��Q23.NTSC�äƲ������ͤˤ��Ƥ�����������

- ���Υ��ʥ����Υƥ�ӡʥӥǥ��˿����ǥ����벽������Τ�DV�ե����ޥåȤǤ���

- ���äơ�DV�ˤ�NTSC����α�����������ϳ�餵���ǥ�������֤�������տޤ�����ޤ�����

- �ӥǥ������ǥ����벽�������Ȥˤ�ꡢ���ԡ��ˤ��������������ʤ��ʤ�ޤ�����

- ����ޤ���ڤ��Ƥ���8mm�ӥǥ��ơ��ץ쥳�����⡢�����˥ǥ�����ӥǥ��ơ��פ��ؤ�äƤ����褦�ˤʤ�ޤ�����

- ������������DV�⡢2000ǯ��Ⱦ�����о줷��80mm�¤�DVD��1�������25.4mm��HDD��ȾƳ�Υ����SD�����ɡˤ�Ͽ���ΤȤ���ӥǥ������γ�ȯ�ˤ�ꡢ�Ծ���Υ����˾���褦�ˤʤ�ޤ�����AVCHD�����ˡ�

- ���������ӥǥ������Ǥϡ�DV�ǤϤʤ�MPEG-4���Ȥ��ޤ�����

- MPEG���������̤��⤤����Ǥ���

- �����������٤�Ҥ٤Ƥ��ޤ������Խ�����Ū�Ȥ����̳�Ѥ�ʬ��Ǥ�Motion-JPEG��١����Ȥ���DV������̥��Ū�Ǥ��뤿�ᡢ��������ʬ��Ǥ�2010ǯ�ˤ����Ƥ�DV���ʤΥǥ�����ӥǥ��ơ��פ����Ѥ����ӥǥ�����餬�Ȥ��Ƥ��ޤ���

- ��

- ����DV - Motion JPEG��¸

- DV���ʤǤ����̥������ϡ�720��480�ԥ�����ǡ��ե졼��졼�Ȥ�30fps������Ψ����1/5�ȤʤäƤ��ޤ���

- ���̥������ϡ�NTSC�����ǥ�����ˤ��뤿���ɬ�פ��Ľ�ʬ�ʲ��ǤȤ��Ƥ��ޤ���

- 30����/�äȤ���Ͽ�衦����®�٤�ӥǥ�����ε��ʤΤޤ�Ƨ�����ޤ�����

- �����ϡ�Motion-JPEG�ˤ��ե졼���ⰵ�̤���Ѥ��Ƥ��ơ�MPEG�Ȥϰ㤤���������Ż߲����¸���Ƥ��ޤ���

- MPEG�ϡ������ְ��̤�Ԥ�����˥����ɽ������ȤƤ�ʣ���Ȥʤꡢ1995ǯ�����Ϥ�����ǽ�ˤ���²���MPEG���������åפ��ʤ��ä����ᡢ���ޥ��奢���������ʤˤ���ܤǤ��ޤ���Ǥ�����

- Motion JPEG�ϡ�ȿ�̡������Խ����ڤˤǤ��ޤ�����

- �����ϡ�����ץ���ȿ�48kHz���̻Ҳ��ӥåȿ�16bit�Υ�˥�PCM2ch����32kHz��12bit�ΥΥ��˥�PCM4ch�ȤʤäƤ��ޤ���

- Ͽ����֤�ɸ�५���åȤ�270ʬ���ߥ˥����åȡ�Mini DV�ˤ�60ʬ��80ʬ�Τ����줫��Ͽ�褬��ǽ�Ǥ���

- DV�ˤϾ�˽Ҥ٤������ѤΤ�Ρ�SD�ˤȡ��ϥ��ӥ�����ѡ�HD���ѤΥե����ޥå�HDV���ʤ�����ޤ������ǥ�����ӥǥ����� ���ȡ���

- ��

- ����DV��MPEG-2

- �ǥ�����ӥǥ��ơ��פ���¸����DV�ȡ�DVD�˺��Ѥ���Ƥ���MPEG-2����٤�ȡ�DV�Υӥåȥ졼�Ȥ���25Mbps�Ǥ���DVD��8Mbps����٤�3�ܶ��Υǡ����̤ˤʤ�ޤ���

- DV�ϻ��ְ��̤ʤ�Motion JPEG���Ȥ��Ƥ���Τǡ��ǡ����̤�¿���ʤ�ޤ���

- ȿ�̡����ְ��̽�����Ԥ�ʤ��Τǽ������֤�®������������ľ�˹Ԥ����Ȥ��Ǥ��ޤ���

- 2010ǯ������̱���ѥǥ����륫���λԾ�Ƥߤޤ��ȡ�DV�ơ��פ�Ȥä��ǥ�����ӥǥ������������ϤۤȤ�ɹԤ��Ƥ��餺��HDD��ե�å�����ꡢDVD���Ѥ���MPEG-2Ͽ��Υӥǥ�����餬��ή�ȤʤäƤ��ޤ���

- ����ή��ϡ�MPEG-2����/���ब���ȥ쥹�ʤ��Ԥ���ޤ����֤ι�®�����ʤ�����Ȥȡ����Ѥ��뵭Ͽ��ǥ����������������ꥳ��ԥ塼����DVD���֤Ȥ��������褤���ȡ���Ͽ���֤�����Ū��Ĺ���Ȥ��褦�ˤʤä����Ȥ������ͳ�ȹͤ��ޤ���

- ��HDV��High-definition Video�ˡ�

- HDV�ϡ�2003ǯ��DV���ʤ������Ȥ��ƺ��줿�ϥ��ӥ����Ͽ��ΤǤ��뵬�ʤǤ���

- HDV�ˤĤ��Ƥϡ��ϥ��ӥ����ǥ�����ӥǥ���HDV�˿����ν�Ǥ�ܤ�������Ƥ��ޤ���

- DV�����ʲ������Ȥ��ˡ��ϥ��ӥ���������̱���ӥǥ�������Ȥ߹��ळ�Ȥ���θ����Ƥ��ơ�DV���ʤdz�ȯ���줿�ǻҤ�ơ��פʤɤ����¤����Ѥ��뤳�Ȥ�������ޤ�Ƥ��ޤ�����

- ���äơ����Ѥ���DV�ơ��פ�Ʊ����Τ�Ȥ����Ȥ�����Ǥ�����

- ��������˽��äƥϥ��ӥ�����б����ޤ��ޤ�����

- ���Τ�����礭�ʵ��ʤȤ��ơ�Ͽ��ե����ޥåȤ�MPEG-2�����Ѥ���ޤ�����

- DV��Motion-JPEG����Ѥ��Ƥ����Τ��Ф���HDV�Ǥ�MPEG-2����Ѥ��ޤ�����

- �ϥ��ӥ����ˤ�Motion JPEG�ե����ޥåȤǤϲ٤��Ť����ޤ�����

- 2010ǯ�ˤ��ä�HDV���ʤΥӥǥ��������ϡ����ߥץ����Ѥ��̳�Ѥι���ʵ�������˸¤�졢�²��ʥ�ǥ�ϰʲ��˼���AVCHD���ʤΥӥǥ�����������ή�ȤʤäƤ��ޤ���

- ��

- ��AVCHD��Advanced Video Codec High Definition�ˡۡ���2010.07.10����

- AVCHD�ϡ�HDV�����Ѥ��Ƥ���DV�ơ��פε�Ͽ��ˡ�ˤ�����뤳�Ȥʤ������ޤ��ޤʵ�Ͽ��ǥ������б������ⰵ�̡������Υϥ��ӥ���ʤǤ���2006ǯ�˥ѥʥ��˥å��ȥ��ˡ��ζ�Ʊ�Ǵ��ܻ��ͤ����ꤵ��ޤ�����

- AVCHD�δ��ܹ��Ҥϡ�ư�����ե����ޥåȤ�H.264/MPEG-4 AVC����Ѥ��������ǡ�����ѥ�����Υե���������Τ褦�ʥĥ��¤�Ȥ��Ƥ��뤳�ȤǤ���

- �ơ���Ͽ�������Υ����Ͽ��Ȥϰۤʤä���¸�����Ǥ���

- ���Τ��ᵭϿ����������PC�Ǻ������Խ�����Τ��Թ��ɤ��Ǥ����ޤ���

- MPEG-4 AVC�ϡ�2010ǯ�ˤ����ƤϺǤ��Ψ�Τ褤��Ͽ�ե����ޥåȤǤ���

- ��Ͽ��ǥ����ϡ�����Ū�ˤ�80mm�¤�DVD�Ǥ��ꡢ���Τۤ���SD�����ɤ�HDD�ʤɤ��б��Ǥ���褦�ˤʤäƤ��ޤ���

- 2010ǯ���ߡ�̱���ѥӥǥ����ॳ�����ΤۤȤ�ɤϤ��ε��ʤΤ�ΤȤʤäƤ��ޤ���

- �����ʤ���720x480���Ǥ�NTSC���ʤ�4:3�β��̥����ڥ�����ˤʤ�Τ���������2007.04.15���ˡ�2010.07.10�ɵ���

720 : 480 = 4 : 3 �ˤʤ뤫�����Ȥ�������Ǥ���

- ����Ϥʤ�ޤ���

- 720 �� 480 �ϡ�3 �� 2 �Ǥ��ꡢ4��3�ˤʤ�ޤ���

- ����ʤΤˡ�4:3�β��̥����ڥ��������DV���ʤǤϤʤ�720���ǣ�480���ǤˤʤäƤ���ΤǤ��礦����

- �������Ѥʼ���������륵���ȤϤʤ��ʤ�����ޤ���

- �����ԻĤʵ���ϡ�NTSC���������ʤ��ǥ�����˰ܹԤ���Ƥ��������Ǥ���̯�ʥ��줫����Ƥ��ޤ���

- �ޤ���NTSC�ϡ����̥����ڥ����椬 4 : 3 �ȸ��ʤ˷����Ƥ��ޤ���

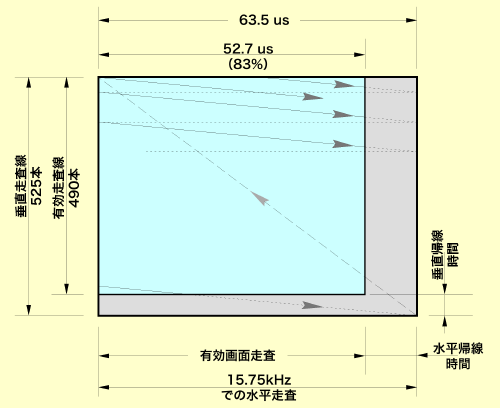

- ��������������525�ܤǤ��뤳�Ȥ�����Ƥ��ơ����줬�Ĥβ����Ϥ���ꤷ�Ƥ��ޤ���

- �Ĥ�525�ܤβ����Ϥ��鴹�����ơ������ڥ����椫�鲣�β����Ϥ�����700�ܤȤʤ�ޤ���

- CCD����餬�������Ѥ˺��줿�Ȥ���CCD����ϡ����ε��ʤ�ʻ���������ǻҤ������Ȥ����Ϥ��Ǥ���

- ���������ǽ餫�餳�Τ褦�ʹ���Ǥ�CCD���뤳�Ȥ��Ǥ��ޤ���Ǥ�����

- �������β��Ǥ�525�ܤ���������ͤ����525�Ĥβ��Ǥ�ɬ�פ��Ȥ��Ƥ⡢�������Ϥ��������������Ǥ����֤�������ε��Ѥ�����ޤ���Ǥ�����

- ���ˡ���1980ǯ�˺ǽ�˺�ä�CCD�ϡ�381���ǣ�525���ǡ�20�����ǡˤ��ä��ΤǤ���

- ���������NTSC�Υ����ڥ��������������ˤϡ�381�Ĥ����ʤ��������β��Ǥ�Ĥβ��ǥ���������٤�1.38�ܤۤ�Ĺ�����ʤ���Фʤ�ޤ���Ǥ��������������аޤ�Фơ������Ϥ���ޤäƤ����Ȳ��ǿ���ɤ�ɤ����䤻��褦�ˤʤꡢ�������β��Ǥ�¿��CCD�������褦�ˤʤ�ޤ�����

- �Ĥβ��Ǥ�525�Ĥȷ����Ƥ���Τǡ���������䤹���ȤϤǤ��ޤ���

- ���äơ����β��Ǥ����䤷�ƿ�ʿ�����Ϥ������Dz���̤����ƹԤä��ΤǤ���

- ����ϡ��ͤޤ�Ȥ�����1�Ĥβ��ǤΥ����ڥ��ȥ쥷������ʿ�����Ϥ�����ʲ��ǿ��������Ƥ������ȡˤˤ�ä��Ѳ����Ƥ��ä����Ȥ�ʪ��äƤ��ޤ���

- ���Ǥ����ǽ�ϲ�Ĺ���ä��Τ˹���Dz��ˤʤ�˽�����Ĺ�ˤʤäƹԤä��ΤǤ���

- CCD����餬��¬�Ѥ˻Ȥ���褦�ˤʤäơ����Ǥ�1:1�Τ�Τ��Ǥ��Ƥ���褦�ˤʤ�ޤ�����

- �����ʻҷ������ǻҤȤ�����ΤǤ���

- ����ԥ塼����ȯã�ȤȤ�ˡ�����ԥ塼����Dz�������褦�ˤʤ�ȡ�����ԥ塼���˹�碌�����ǿ���CCD�Υ�������������褦�ˤʤꡢVGA�����˹�碌��640x480���Ǥ������ʻҡ�1���ǤΥ����ڥ����椬1:1�ˤ������褦�ˤʤ�ޤ�����

- VGA�Ǥβ��̤Υ����ڥ������4 �� 3 �Ǥ���������ԥ塼���������ϡ�VGA�ϡˡ������ڥ�����Ȥ��褽�β��ǿ���NTSC�����ޤ�������1���Ǥ��礭���������ʻҤȤ��ޤ�����

- ��1���� = �����ʻҡס����줬����ԥ塼�������λϤޤ�Ǥ��ꡢ�����β��̤�����Ω���Ȥ��礭���ۤʤ����Ǥ�����

- �����ʼ����ˤ��DV���ʤϡ���¬�ѡʥ���ԥ塼���ѡˤȤ��̤�ƻ�����Ǥ��ޤ�����

- �Ĥޤꡢ�����ͥ�褷1���ǤΥ����ڥ������1:1�Ȥ��������ǿ���ͥ�褷��720x480���ǤȤ��ޤ�����

- ����ˤ⤫����餺�����̤Υ����ڥ������4:3���ݤ��ޤ�����

- �Ȥ���ȡ�1���Ǥ���ˡ�νIJ��椬1:0.889�Ȥʤ�ޤ���

- ���ε��ʤ��¬�ѤȤ��ƥѥ�����˼������硢�ɤΤ褦�ʤ��Ȥ�������ΤǤ��礦��

- DV���ʤǤ�1���Ǥ��������Ȥߤʤ��Ƥ��ޤ��ȥ����ڥ����椬�Ѥ�ꡢ������ˡ���ºݤ���12.5%��Ĺ��ɽ������Ƥ��ޤ��ޤ���

- ����Ǥϡ����β���������ˡ���Ѱ̡�®�١����٤ʤɤ���뤳�Ȥ��Ǥ��ʤ��ʤ�ޤ���

- ����ϡ����̤α���������¬�Ѥ˻Ȥ��Ȥ������դ��ʤ���Фʤ�ʤ����פʥݥ���ȤǤ���

- ��¬�ѤˤϷ�¬�Ѥ�CCD�����ꡢ�����Ѥ䥢�ޥ��奢�ѥƥ�ӥ����ˤϷ�¬�ѤȤϰ㤦��ˤ��ʤ��ʤ���������β����ͥ�褷����CCD�����ä��Ȥ������ȤǤ���

- ��

- ��DVD-video�ۡʤǤ��֤��Ǥ��ӤǤ���������2010.7.10�ɵ���

- DVD-video�ϡ�DVD�˺��Ѥ���Ƥ���ư��ե�����ե����ޥåȤǤ���

- ���ʲ����طʤˤϡ���ǽҤ٤�DV�ʥǥ�����ӥǥ��ˤ�DVD�˵�Ͽ����Ȥ�����Ū������ޤ�����

- 2010ǯ�����ǡ��Dz衢�ƥ�ӥ���ƥ�Ĥ�DVDϿ���ǥ����Ȥ��ƺǤ�褯�Ȥ��Ƥ��������Ǥ���

- DVD�ϡ�CD��Ʊ��ľ�¤ȸ����ǡ�CD����7�ܤξ����Ͽ�Ǥ���ǥ������Ǥ���

- ����1�ؤ�4.7G�Х��Ȥα�����8Mbps��MPEG-2�ե�����ξ��ϡ���1����ʬ��4Mbps��MPEG-2�ե�����ξ����� 2����ʬ�ˤ�Ͽ�Ǥ��ޤ���

- ����2�ؤǤ��ܤε�Ͽ�Ȥʤ�ޤ���

- �����ε�Ͽ���֤ϤҤȤĤ��ܰ¤ǡ������μ��Ȱ��̤��ٹ礤�ˤ���Ѥ��ޤ���

- DVD-video�ϡ��ɤ߽Ф����Ѥ�DVD-ROM��DVD�ץ졼�䡼�Ǥκ�������ǽ�ǡ����٤��������DVD-R�����٤�����ΤǤ���DVD-RW�ʤɤ�����ޤ���

- DVD�Υ��ץꥱ������ʤǤϡ� �ʲ���3���ब����ޤ���

- ��

- ��������DVD-Video

- ��������DVD-VR(Video Recording)

- ��������DVD-Audio

- ��

- DVD-Video �ϡ������� MPEG-2 ����Ѥ��������������ѵ��ʤǤ����Dz���DVD�Ȥ��ƺǤ����Ū�ʤ�ΤǤ���

- DVD-VR(Video Recording)�ϡ�DVD-RW �� DVD-RAM ����Ѥ��ƱDz�ʤɤα�����Ͽ����ӥǥ��쥳���ɤε��ʤǤ���

- DVD-VRF�Ȥ�ƤФ�Ƥ��ޤ���

- �����ڤ��Ͽ�褬��ǽ�ǡ������٤�ʣ����480x480��544��480�ʤɡˤ����Ƥ��졢DVD-Video����ˤ����ʤǤ���

- DVD-VR�ϡ����ܤδ�Ȥ���ä��ȼ��ε��ʤǤ��ꡢ�����ʵ��ʤǤϤ���ޤ���

- DVD-Audio�ϡ������ǥ���CD��DVD�ǤǤ���������Ū�ǤϤ���ޤ���

- DVD�ӥǥ���DVD-Video�ˤϡ�ư�谵�̤�MPEG-2��Ȥ���133ʬ�α����Ȳ�������Ͽ���줿�ӥǥ��ǥ������Ǥ���

- ���ǿ�720�ԥ�����×480�ԥ����롢��ʿ��������500�����٤���ʵ��ʤǤ���

- �����ϡ��ɥ�ӡ��ǥ������AC-3�˥��饦��ɤȥ�˥�PCM�Τɤ��餫�Ǽ�Ͽ����ޤ���

- ���Τۤ��˥��ץ����ե����ޥåȤȤ��ơ�MPEG�����ǥ�����ǧ����Ƥ��ޤ���

- ����DVD-Video�Υե����빽��

DVD�ӥǥ���DVD-Video�˥ե�����ϡ�PC�ʥ���ԥ塼���ˤǸ��뤳�Ȥ��Ǥ��ޤ��ʱ��̿����ȡˡ�

- DVD�ɥ饤�֤�DVD�ӥǥ��μ��ޤä�DVD�ǥ����������졢�������ץ�����dz����ȡ�

- ��

- ����[AUDIO_TS]��

- ����[VIDEO_TS]

- ��

- �Ȥ����ե��������ǧ�Ǥ��ޤ���

- [VIDEO_TS]�ե�����ˤϡ�

- ��

- ������IFO��

- ������BUP��

- ������VOB��

- ��

- �Σ���Υե����뤬���äƤ��ޤ���

- ��IFO�פϥ�˥塼�����ޥ������ʤɤ��������ե�����Ǥ���

- ��BUP�פϡ�IFO����Υե����뤬��»�������ΥХå����åפǡ���IFO�פ�Ʊ���ե����뤬���äƤ��ޤ���

- ��VOB�פˤϱ����䲻��������ʤɤμ¥ǡ��������äƤ��ޤ���

- �̾�ϡ�PC��DVD�����������ȼ�ưŪ��ǧ�����ƺ�����Ԥ��ޤ���

- ��

- �ڥǥ������������ʡ�

- ���ε��ʤϡ��ƥ������ʬ��ǵ��ʲ�����Ƥ����ƥ�ӱ����Υǥ����뵬�ʤǤ���

- �ǥ������������ʤϡ��ƹ��͡��ʻ��Ǥ����ߥǥ����뵬�ʤ˾��Ф����Τ�1950ǯ��Υƥ��������Ʊ���������쵬�ʤȤϤʤ�ޤ���Ǥ���������������������Segment Broadcasting�����ȡ���

- ���ܤΥǥ������������ʤϡ�ISDB��Integrated Services Ditital Broadcasiting������ǥ��������������ӥ��ˤȤ�����Τǡ��������礭����4�Ĥβ����ʤ�1�ĤΤ��ޤ��ˤ����٤�褦�ˤʤäƤ��ޤ���

- 4�Ĥβ����Ȥϡ��ʲ��Τ�ΤǤ���

- 1.��480i����NTSC�α������������Ȥˤ���720x480���ǥ����졼������

- 2.��480p����720x480���ǥץ�����å�������

- 3.��720p�����ϥ��ӥ��������Ǥ���1280x720���ǥץ�����å�������

- 4.��1080i�����ϥ��ӥ��������Ǥ���1920��1080���ǥ����졼������

- �ʤ��������Ͼ�ǥ����������Ǥϡ��Ӱ�δط���1440x1080i�����ꡢ����¦��1920x1080i�˰�����Ф��Ƥ��롣��

- ���ޤ�5.��1��������320x240����ʬ�α���

- ���ε��ʤϡ��ǥ����������ȱվ�/�ץ饺�ޥƥ�Ӥ���Ƭ�ˤ�äƵӸ�����Ӱ���Ū�ˤʤ�ޤ�����

- �ʤ���ISDB�ˤϡ��Ͼ�������ǥ�����������ISDB-T�ˡ��Ͼ�ǥ����������ˤȱ�������������ǥ�����������ISDB-S�ˡʥǥ�������������ˤ�����ޤ���

- �ޤ����Ͼ��Ȥˤ���ư���̿������Υǥ�����������ISDB-T SB�ˤ䥱���֥�ƥ�Ӹ����Υǥ������������ʡ�ISDB-C�ˤ⤢��ޤ���

- �ǥ������������ʤϡ�����ԥ塼��ʸ�������Ǥ���AVI��QuickTime�ʤɤ�ư��ե�����ȤϾ����ۤʤäƤ��ޤ���

- �ƥ�������Ǥϡ��̿��Ӱ��30�ե졼��/�äκ���®�٤��Ǥ���פʻ��ͤǤ��ꡢ�����1945ǯ�˷���줿���ʥ�����NTSC�������椫��©�Ť��Ƥ����ΤǤ���

- ���������ϡ�30�ե졼��/�äλ��ơ�����®�٤�ݻ����Ƥ����˹��ߤ˲�����ɤ�Ͽ��Ⱥ�����Ԥ��������Ѥο����Ǥ��ꡢ���Τ���ˤ��������ʰ��̵��Ѥ���ȯ����ޤ�����

- ���䥳��ԥ塼��ư��Ǥϡ��Ż߲��ư���դ�����꤫���ȯ���Ƥ��ޤ���

- ���ǿ������®�٤�ʤ��«�������ΤϤ���ޤ���Ǥ�����

- �ޤ����ƥ��������2����Ͽ�����������ʤ���ư�赭Ͽ��������Ƥ���Τ��Ф�������ԥ塼��ư��Ϥ�������10ʬ���٤���������Ƥ��ޤ�����

- �ʤ�û���Τ��ȸ����С�����ԥ塼���κ���ǽ�ϡ���¸ǽ�ϡ�ž��ǽ�Ϥ��ɤ��Ĥ��ʤ��ä�����Ǥ���

- �����ƥ����������β�����¬

- �ƥ�������ϡ��ӥǥ�Ͽ�����֡ʥӥǥ��쥳������DVD�쥳������BD�쥳�����ˤ��ߤ��뤳�Ȥ���ǽ�ǡ������DVD��Blue-ray�ǥ�������MPEG-2�ե����ޥåȤȤ�����¸���뤳�Ȥ��Ǥ��ޤ���

- ������¬�ѤȤ��ƻȤ��뤫�Ȥ������Ѥʵ��䤬�來�ޤ���

- MPEG-2�β�����¬�ؤθ³��Ϥ��Ǥ˽Ҥ٤ޤ���������������¬�Ȥ��Ƥ�MPEG �ˡ�

- �ƥ�������ˤϡ������Υ��졼��������䡢�����ڥ��ȥ쥷�������ꡢ���ԡ�������ʤɤ�������äƤ��ơ������ν������ʬ�˹�θ����������ɬ�פǤ���ȹͤ��ޤ���

- ��

- ��HEVC��High Efficiency Video Coding�ˡ�������2018.11.07��

- HEVC�ϡ�H.265/MPEG-H Part2�θƤ�̾�ǡ�AVC��MPEG-4 AVC/H.264���θ�ѤȤʤ�ư��ե�����Ǥ���

- 2103ǯ��JCT-VC��MPEG & VCEG Joint Collaborative Team on Video Coding�˥��롼�פˤ�ä����ꤵ��ޤ�����

- AVC�����2�ܤΰ��̸�Ψ��Ʊ���̿��Ӱ��2�ܤβ����ϡˤ������8192 x 4320���ǤޤǤ��б���ǽ�Ȥ���4K����8K�������ǰƬ�ˤ��줿��ΤǤ���

- HEVC����������פ�OS�ˤϡ�Widnows10��Mac OS High Sierra, iOS 11���б����� �ޤ���

- HEVC�ϡ��õ������������꤬ʣ��������Ǥ��ơ�H.264�Τ褦��ñ�쵡�ؤؤ��õ�ȯ���ȤϤʤ餺��ʣ���γ�ȯ���Τ������ԻȤƤ��뤿����Ѥˤ����äƤϤ��줾������Τ��õ���������ɬ�פȤʤ�ޤ���

- ���줬���ꥢ�ˤʤ�ʤ�����ڤ����ȴ����ޤ���

- ��

��

- ���˥�˥塼�С�������ʤ���硢

- ������å����Ʋ�������

- ��

- �� �� �� ��

- �����������ŻҲ����ˤε�Ͽ����������2007.09.11�ˡ�2010.08.08�ɵ���

- �ŻҲ����ʥӥǥ������ˤ�Ͽ�������ΤˤϤɤΤ褦�ʤ�Τ����ä��ΤǤ��礦����

- ���ι��ܤǤϡ��ŻҲ����˻Ȥ��Ƥ�����Ͽ���ΤˤĤ��ƽҤ٤����Ȼפ��ޤ���

- �ŻҲ�����Ͽ�������Τ���ɽŪ�ʤ�Τϡ�Ŵ�μ����Ρ��ץ饹���å��פ�Ȥä�����Ͽ��ȾƳ�Υ����3�Ĥ�����ޤ���

- ������3�Ĥε�Ͽ���Τ�ȯã�������ˤϥե����ʶ��������ˤ��Ȥ��Ƥ��ޤ�����

- ��

- �����ե����λ���

- �ƥ�ӥ���餬��ȯ���줿�����1940ǯ��ˡ��ƥ�Ӳ�����Ͽ�褹�����ƤϤ���ޤ���Ǥ�����

- �ƥ�������ȸ����С����Ƥ�Ʊ���˱���Ϥر������������饤�ֱ������ۤȤ�ɤ��ä��ΤǤ���

- ������1960ǯ���ޤǡˡ�������Ͽ�������������Ƥȸ����С�ͣ���Ͽ�����ΤǤ��ä��ե����ʶ���ˤ����ʤ��ä��Τǡ��饤�֤ˤǤ��ʤ������ϱDz襫���ǰ�ö���Ƥ��Ƶ�Ͽ���������ե��������ˤʤä���Τ��ƥ쥷�����֤Ȥ����������ü�ƥ�ӥ����=�ե饤�����ݥåȡ�������ʡ����ǥƥ�ӿ����ľ�����������Ƥ��ޤ�����

- ���������ˤ�������ϡ�2005ǯ������ޤǹԤ��Ƥ��ޤ�����

- ���ޡ������ե����ϡ�35mm�Dz襫���ǻ��Ƥ��ơ������ƥ쥷�ͤȤ������֤ˤ������������Ƥ��ޤ�����

- �ޤ������������ʤɤǥƥ�ӥ�����Ȥä�����������Τ�Ͽ��¸���������ˤϤɤ����Ƥ������ȸ����ȡ��Dz�ե�����ȤäƤ��ޤ�����

- �������֤ϡ��ե������������ɤ��ü�ָ��̤���ä��Ĥߤξ��ʤ��ƥ�ӥ�˥��ʥ֥饦��ɡˤ˥ƥ�ӱ�����Ǥ��Ф���������ü�ʥե���५���ʥ��ͥ쥳���� = Kinescope Recording�ˤǥե����˻��Ƥ��Ƥ��ޤ�����

- ���ͥ쥳���֤Ȥ����Τϡ����ߤǤ⤵����˻Ȥ��Ƥ��ޤ���

- �Ƕ�αDz��CG�ˤ���ŻҲ�����¿���������ե����˾Ƥ��դ���ݤ˥ǥ����뿮�椫��졼����Ȥäƥե�����ľ�ܾƤ�����Ǥ��ޤ���

- ��Ͽ�λ����ϡ��ե������٤��졼���ӡ����������ʥ�����ˡ��ƥ�Ӳ�����ɽ���Ȼ����褦���������̵�Ͽ���Ƥ��ޤ���

- ���ߤαDz�θ��ܤϥǥ��������¸����Ƥ��ơ�����Τ褦�˥��ꥸ�ʥ�ͥ��ե�������¸����Ȥ����ΤǤϤʤ��褦�Ǥ��� ����→���ե����ˤ�뵭Ͽ�عԤ���

- ��

- ��

��

- �� �� ��

- ���������Τˤ�뵭Ͽ

- �ƥ�ӱ�����Ͽ���Żҵ�Ͽ�ˤ���ƹԤä��Τϡ�����Ŵ�ˤ�뼧���ơ��פε�Ͽ���֡����ʤ���ӥǥ��ơ��ץ쥳������VTR = Video Tape Recorder�ˤ���ȯ���줿1956ǯ�Ǥ���

- ����ʴ�Τ��ŵ�����ε�Ͽ�˻Ȥ���Ȥ���ȯ����1898ǯ�ˤ����ä�VTR���о�ޤǡ�58ǯ��ǯ��ФäƤ��ޤ���

- ��������Ͽ����Ȥ����Τϡ��ȤƤĤ�ʤ����ѳ�ȯ���ä��Τ˰㤤����ޤ���

- ���ι��ܤǤϡ������Τ�Ȥä���Ͽ���Ρʼ����ơ��ס��ե��åԡ��ǥ��������ϡ��ɥǥ������ʤɡˤ���ɤäƾҲ𤷤����Ȼפ��ޤ��� →���ּ����Τˤ�뵭Ͽ�פعԤ���

- ��

- �������ˤ�뵭Ͽ

- 1980ǯ�夫��ϡָ��פˤ�뵭Ͽ�������졼����Ȥä���Ͽ��ȯŸ���ޤ���

- �졼����ȯ���ʤ����Ƹ��ߤα�����Ͽ����ˤϤ������ޤ���Ǥ�����

- �졼����ȯ���ȥ���ԥ塼����ȯã�ʥǥ����뵻�ѡˤ����ε�Ͽ����٤���Ĺ�����ޤ�����

- ���ι��ܤǤϡ��졼����Ȥä��������֡ʥ졼���ǥ������ˤ���CD��MO��DVD��Blu-ray����ħ��Ҳ𤷤����Ȼפ��ޤ���

- �����ָ��ˤ�뵭Ͽ�פعԤ���

- ��

- ����ȾƳ�Τˤ�뵭Ͽ

- ȾƳ����¤���Ѥ���®��ȯŸ��뤲���桢�ȥ������Ͽ���ΤȤ����ˡ���ͤ��Ф��졢ȾƳ�Υ���Ȥ������ܤ��褦�ˤʤ�ޤ���

- ȾƳ�Υ��꤬�����Ӹ�����Ӥ��Τϡ��ե�å��������о줫��Ǥ��礦��

- ����ޤǤϡ�ȾƳ���ǻҤ�Ȥä���Ͽ�Υ����ǥ��Ϥ����Τα�����Ͽ�����ǥ����Ȥ��ƻ��Ѥ���ˤϡ��礭������ʤ�Ȥ���������Ū�ǤϤ���ޤ���Ǥ�����

- �ե�å�����꤬��ȯ���������ȾƳ�Υ���ϡ�����ԥ塼���˻Ȥ��Ƥ���DRAM�˸�����褦�ˡ��Ÿ����ڤ�ȥ������Ƥ��ä��Ƥ��ޤ���ΤǤ����� �ե�å������ϡ��Ÿ���̵���Ƥ�ǡ������ݻ���³����Ȥ����礭����ħ����äƤ��ޤ����� ������ȾƳ�Τˤ�뵭Ͽ���عԤ��� �� ��

- ��

- �� ��

- �����Τˤ�뵭Ͽ

- ������Ͽ�Ȥ���������ʤ���®�������̤Υǡ������Ż�Ū����¸�����ˡ�ϡ�����Ŵ�ˤ�뼧���Τμ�����Ͽ�ˤ������ޤ���

- ����ޤǤϡ��ʱDz�˥ե����ʶ���̿�������ˤǤʤ���ФǤ��ʤ����ȤǤ�����

- ������Ͽ���뼧���Τϡ��ӥǥ��ơ��פ�ȯ������Ϥޤ�ޤ���

- ����ϡ������ơ��פ��Ǥ��Ƹ��24ǯ�Фä�1956ǯ�Τ��ȤǤ���

- �ӥǥ��ơ��ץ쥳������ȯ���¿�ζ�ϫ������ޤ�����

��

- �� ��

- �ڼ����ơ��ס� ��2008.08.17�ɵ��� ��2008.12.07�ɵ���

- ��

- ���������ơ��פγ�ȯ

�ӥǥ��ơ��פϡ������ѥӥǥ��ơ��ץ쥳������VHS�ơ��פʤɤǹ����Τ��Ƥ���褦�ˡ������Ρʵ�Ͽ���Ρˤ����Τ褤�ݥꥨ���ƥ�ե����ʻٻ��Ρˤ����ۤ�����ΤǤ���

- �ӥǥ��ơ��פϡ������ѡʥ����ǥ����˥ơ��פ����������ޤ�����

- �����ǥ����ơ��פγ�ȯ�ϡ�1930ǯ����ɥ���BASF�ҤǻϤ��졢�ӥǥ��ơ��פϡ�1950ǯ���Ⱦ���ƹ�3M�Ҥ���Ω���ޤ�����

- 1970ǯ�夫��ϡ����ܤΥ���������ơ��׳�ȯ����¤�μ���ˤʤ�ޤ�����

- 2000ǯ�ʹߤμ����ơ��פϡ��ǥ�����ơ��פȤ��Ƥΰ��֤Ť����礭���ʤäƤ��ޤ���

- ���������ơ��פ����

- �����ơ��פγ�ȯ�����Ū�˸��Ƥߤޤ��ȡ������Τ��ŵ�����ε�Ͽ���ΤȤ��ƻȤ���ˡ��1898ǯ���ǥ�ޡ�����Valdemar Poulsen�ʥݡ��륻��1869 - 1942�ˤˤ�äƳ�ȯ����ޤ���

- ��ϡ���������Ĺ�������Ӥ�Ͽ���Τ˻Ȥä������磻���쥳������ȯ�����ޤ�����

- �ơ��פǤϤ���ޤ���

- �����ϡ������ץ饹���å��ե������뵻�Ѥ��ʤ��ä��ΤǤ���

- �������Ρʼ����磻��ˤϡ��������ʤ��顢��Ͽ̩�٤��㤯�ƻ�����¿����1970ǯ��Υ����ǥ����ơ��פ���٤�1000�ܶ���äƤ����ȸ����Ƥ��ޤ���

- �ݡ��륻��ϡ�����ꥫ�Υ�������ȯ�������߲�����Phonograph��1877ǯ�ˤȥ٥뤬ȯ���������õ���Telephone��1876ǯ�ˤ����ۤ����ơ����õ���Ͽ���ѤȤ��Ƥ������֤�ȯ�����õ�����ޤ�����

- ���Ͽ�����ϡ����äơ�Telegraphone�סʥƥ쥰��ե���ˤȸƤФ�ޤ�����

- ����Ͽ�����ϡ��ŵ������郎�ʤ��ƿ��椬�夯��������ɬ�פʻ��˿����ɤ�ȯ���ϡ�30ǯ���1906ǯ�Ǥ����ˡ�����˥磻�������ޤä��ꤷ��Ͽ���ο��������㤤��ΤǤ�����

- �������֤ϡ��õ����ڤ��1918ǯ�ޤǤ���ۤɤ���ڤ���1924ǯ����¤����ߤ��ޤ���

- ����ꥫ�Ǥϡ�1950ǯ���溢�ޤǷ����濴�Ȥ��Ƽ����磻��������Ͽ�������Ȥ��Ƥ����褦�Ǥ���

- ��

- �����ɥ��ĤΥơ��ץ쥳������ȯ

- �ڼ����ơ��פγ�ȯ��

- Ͽ�����θ��泫ȯ�ϡ���Telegraphone�פ��õ����ڤ��1918ǯ�ʹߺƤӻϤޤꡢ1932ǯ�˥ɥ��ĿͤΥ��˥� Fritz Pfleumer�ʥե�åġ��ե����ޡ���1881.03�� 1945.08�ˤ��ơ��������ˤ��Ͽ������ȯ�����ޤ���

- �������֤ϡ����顢��ơ��פ�ȤäƤ��ơ�����˻���Ŵ�μ�����ʴ���å������Ϥ��������ۤ�����ΤǤ�����

- �ץ饹���å��ơ��פϡ������ε��ѤǤ������ƶ��٤Τ����Τ����ʤ��ä��ΤǤ���

- ��ϡ��洬�����Х�����������Ѥ���äƤ����褦�ǡ����ε��Ѥ���Ѥ����褦�Ǥ���

- ��ϡ�������������õ���ɥ��Ĥ�AEG�ҡ�Allgemeine Elektrizitats-Gesellschaft���������ɥ��ĤκǤ��礭���ŵ����)�����ޤ���

- AEG�Ҥϡ�������Magnetophon�ʥޥ��ͥȥե���ˡפȤ�������̾�ˤ��ơ��ơ��ץ쥳���������˽Ф��ޤ�����

- ���Υơ��ץ쥳�����ϲ��ɤ��Ťͤ�졢BASF�ҡ�Farben�һ���)�ζ��Ϥˤ�꼧���ơ��פ���ɤ���ơ����������ȥ�α��դ������ڤ�Ͽ���˻Ȥ���ޤǤˤʤ�ޤ�����

- BASF�Ҥ��礭�ʲ��ع��Ȳ�Ҥǡ����β�Ҥˤϥơ��פλٻ��ΤǤ��륢���ơ��ȥե�����Acetate film��1920ǯ����������1924ǯ�֥�ƥ��å��塦����ˡ����ҹ��Ȳ��ˤ���¤���ѤȽ��٤ι⤤������ʴ���ʥ����ܥ˥�Ŵ��Fe(CO)5��Carbonyl Iron�ˤ��뵻�Ѥ���äƤ��ޤ�����

- �����ơ��פ���¤�ˤϡ��ɼ��ǰ��ꤷ���ե����١�����ɬ�פ��ä��ΤǤ���

- �����ơ��פ�ɸ��ٻ��ΤȤʤä��ݥꥨ���ƥ�ե�����Polyester film��1941ǯ�ѹ�ꥳ�ץ�����ҳ�ȯ��1953ǯ�ƹ�ǥ�ݥ���õ������ˤϡ���ˡ���������ˤ�Ƥ褯��������פʤΤǸ��������������ե������ơ��פ��뤳�Ȥ��Ǥ��ޤ���

- �������������Ϥޤ����κ����Ϥ���ޤ���Ǥ�����

- �ݥꥨ���ƥ�ե������о�ϡ�1960ǯ�ʹߤǡ����κ������Ǥ���ޤǤϥ����ơ��ȥե���ब��ή�ȤʤäƤ��ޤ�����

- AEG�ҤΥޥ��ͥȥե���������ˤϡ�BASF�Ҥμ����ơ��׳�ȯ�θ��Ӥ��礭���ä��ȸ����Ƥ��ޤ���

- �����Τϡ������ܥ˥�Ŵ����ޥ��ͥ����ȡ�Fe3O4�ˤ��夨���ơ����ɤ��פ�Ĥ��ޤ���

- ��

- ����AC�Х�������Ͽ��AC bias method��

- �ޤ����������Τؤ�Ͽ�����Ѥˤ���ɤ��ä����ơ����������夷�ޤ�����

- ���β��ɤȸ����Τϡ�������������Τ˵�Ͽ���������β��ɤǤ���

- ������Ͽ�ϡ�ľή�Х�������DC bias�ˤȸƤФ���ˡ��Фơ���ή�Х�������AC bias��ˡ����ȯ����ޤ���

- ����ˤ�ꡢ����������Ū�˸��夷�ޤ�����