一般のビデオと高速度カメラ

Q01. 普段見ているテレビは1秒間に何枚の絵を出してるの? (2001.02.26追記)(2009.05.20追記)(2011.09.24追記)

なぜこのような難しい走査を行っているのでしょう。

なぜこのような難しい走査を行っているのでしょう。

|

|||||

|

|||||

|

|||||

|

|||||

|

||||

| |

||||

|

|||

| 1970年〜1990年まで活躍した、16mmフィルムタングステンリバーサルフィルム。当時の高速度カメラは、このフィルムで撮影された。フィルム感度は、ISO500だった。 | |||

|

||||||||

|

|

|

|

|

|

|

|

|

250コマ/秒

(1/250秒)

|

300 |

600 |

|

|

|

|

|

|

500コマ/秒

(1/500秒)

|

600 |

1,200 |

|

|

|

|

|

|

500コマ/秒

(1/1,000秒)

|

1,200 |

2,400 |

|

|

|

|

|

|

1,000コマ/秒

(1/1,000秒)

|

1,200 |

2,400 |

|

|

|

|

|

|

1,000コマ/秒

(1/10,000秒)

|

12,000 |

24,000 |

|

|

|

|

|

|

2,000コマ/秒

(1/50,000秒)

|

|

120,000 |

|

|

|

|

|

|

|

||||||||

|

|

|

|

|

|

|

|

|

|

||||||||

|

||||||||

|

|

|||||||

|

|

|||||||

|

||||||||

|

||||||||

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

アポスチルブ |

|||||||

|

20 |

|

|

|

|

|

|

|

40 |

|

|

|

|

|

|

|

81 |

|

|

|

|

|

|

|

163 |

|

|

|

|

|

|

|

325 |

|

|

|

|

|

|

|

650 |

|

|

|

|

|

|

|

1,300 |

|

|

|

|

|

|

|

2,600 |

|

|

|

|

|

|

|

5,200 |

|

|

|

|

|

|

|

10,400 |

|

|

|

|

|

|

|

20,800 |

|

|

|

|

|

|

|

41,600 |

|

|

|

|

|

|

|

83,200 |

|

|

|

|

|

|

|

166,000 |

|

|

|

|

|

|

|

333,000 |

|

|

|

|

|

|

|

666,000 |

|

|

|

|

|

|

|

1,330,000 |

|

|

|

|

|

|

|

2,660,000 |

|

|

|

|

|

|

上の表に示した値は、我々映画関係のカメラマンが経験的に用いている表です。

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

|

||||

|

||||

|

||||

高速度ビデオ

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

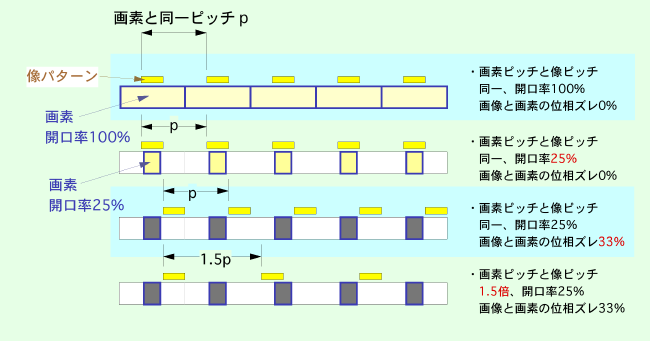

固体撮像素子は精度の良いシリコン平面板に微細加工を施してシリコンのホトダイオードを作りあげ、一つ一つを埋め込んであります。このホトダイオード1つを1画素(または1ピクセル)と言っています。

固体撮像素子は精度の良いシリコン平面板に微細加工を施してシリコンのホトダイオードを作りあげ、一つ一つを埋め込んであります。このホトダイオード1つを1画素(または1ピクセル)と言っています。 開口率が解像力に大きな影響を与えます。

開口率が解像力に大きな影響を与えます。 A27. シリコンのセルで受光した電荷を電位差を利用して、バケツリレーによって光の信号を送るやり方は、10MHz(100ns単位)が限界だろうといわれています。

A27. シリコンのセルで受光した電荷を電位差を利用して、バケツリレーによって光の信号を送るやり方は、10MHz(100ns単位)が限界だろうといわれています。

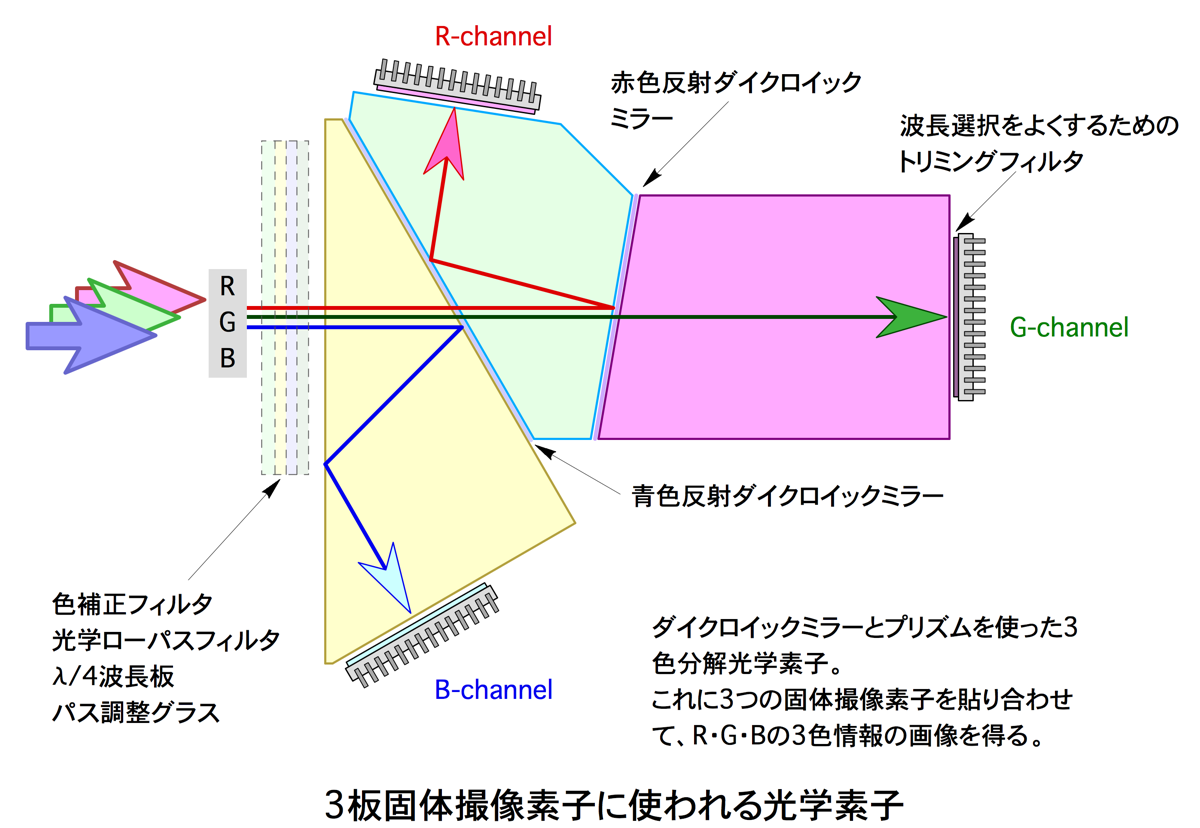

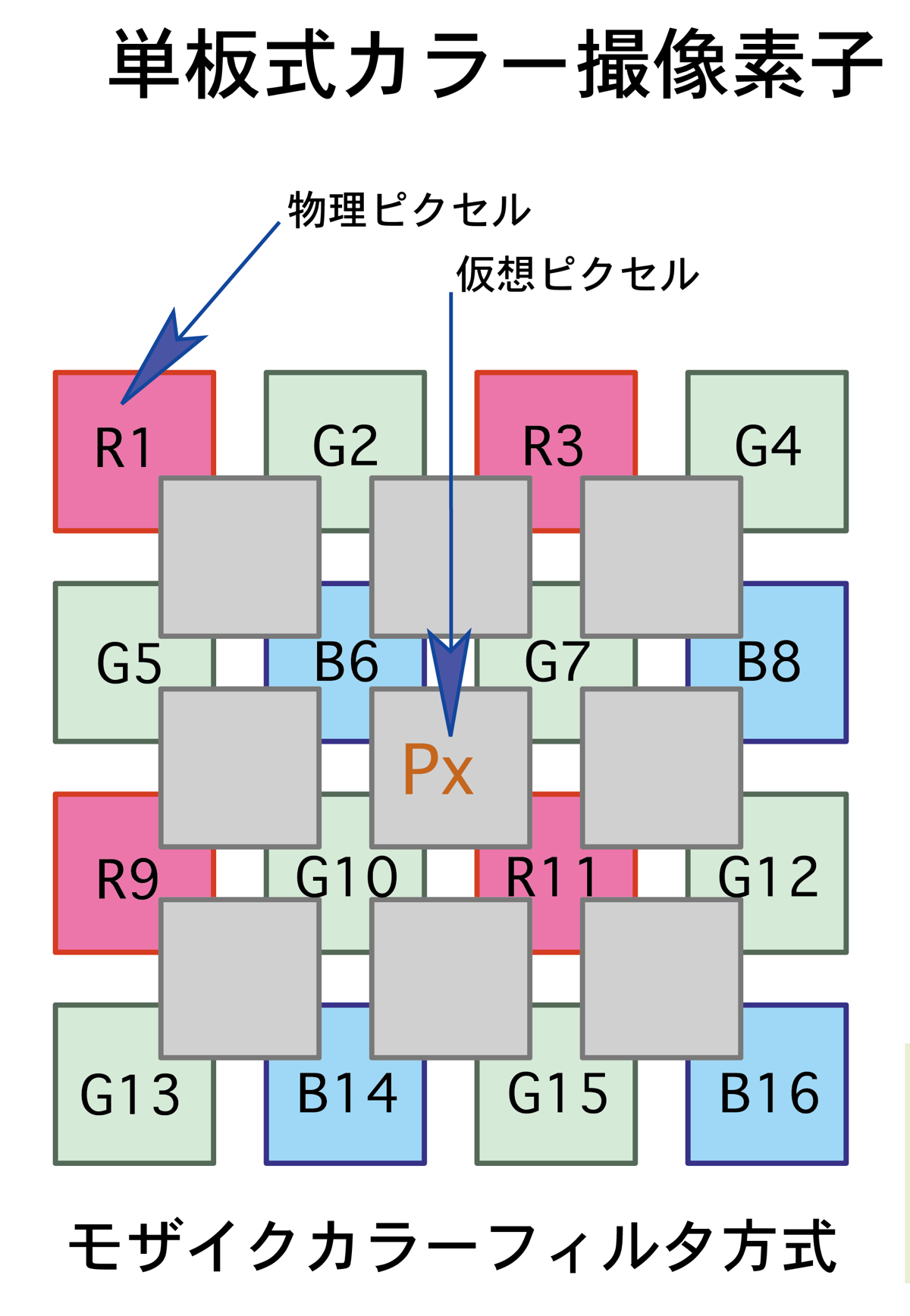

左図にカラーフィルタの原理を示します。

左図にカラーフィルタの原理を示します。画像処理装置

|

ターゲット自働読み取り装置Image Express(1998) 上部より、カラーモニタ、 キーボード及びマウス、 WindowNTコンピュータ VCR |

|||

|

||||

|

||||

3次元計測装置

- Q41. 3次元計測ってどうやって行うの?

- A41. 画像は、基本的には2次元情報です。

- この2次元情報から3次元情報を得るためには、図面の3角法と同じように2方向から映像を取り込みXYZ情報を構築します。

- 一番簡単な方法は、被写体に鏡を置いて一つのカメラで2方向の画像を取り込み3次元情報を得ます。

- 1台のカメラですと制約が大きいので、高速度カメラを2台用いてXY、YZ平面を構築し同一倍率で被写体を撮影して3次元情報を構築します。

- 2台のカメラだけですとターゲットが隠れてしまうことがあるため、5〜7台のカメラで被写体をとらえ隠れたターゲットを別のカメラで補間する方法が採られています。

- カメラは、いったん固定したら動かすことはできません。

- カメラを固定して、座標の良くわかったターゲットを撮影してカメラの位置と座標系を特定します。

- 英国Oxford Metrics社(Oxford大学 モーリス博士が1984年に創設)が開発したVICONと呼ばれるシステムは、映像ではなく、被写体に反射マーカを取り付け、画像を二値化処理してマーカの輝度だけを検出します。

- こうして読み取りを自動にして3次元座標構築、スティックピクチャ処理(人体の間接を線で結んで骨格処理を行う手法)を迅速に行うことができます。

- Q42. 3次元計測はいままでにどんなところに使われてきたの?

- A42. 3次元計測を本格的に行ったのは、ロケットの弾道、弾丸の弾道の軍事用でした。

- 弾丸はまっすぐに飛ぶとお考えの方が多いと思いますが、実際はさにあらずなかなかまっすぐに飛ばないそうです。

- 最近の誘導ミサイルは敵の包囲網をくぐり抜けて飛ぶためその飛行形態の計測は3次元計測が必要不可欠でした。

- ロケットの開発でも3次元計測は不可欠です。

- 衛星を打ち上げるロケットは巨大な構造物でこれが糸の切れた凧のようにどっかに飛んでいっては一大事!打ち上げる前にロケットの軌道を何度も計算し、計算どおりの経路でロケットが打ち上がって行くかをセオドライト(オプティカルトラッキングマウント)と呼ばれる測距儀の映像版を使って追跡します。

- 打ち上げ軌道が理論軌道から外れた場合、軌道修正するかさもなくば爆破しなければなりません。

- セオドライトを使った3次元計測は、Vロケットを開発したドイツによって第二次世界大戦で確立しました。

- 次に3次元計測を熱心に行ったのは運動解析(バイオメカニクス)と身体障害者向けの歩行分析(リハビリテーション)でした。

- スポーツ科学分野(Biomechanics)では、映像計測が盛んに使われていましたが2次元計測ではどうしても有効な計測結果が得られず、ひねり、重心計測など3次元情報でないと正確な情報が得られません。

- DLT法(Direct Linear Transformation technique)が20年前より使われはじめ、フィルムカメラを使った3次元解析からビデオを用いた計測へと手法が変わってきました。

- 日本では東京大学を卒業しアシックスに入社した福田氏(故人)が最初にDLTを使ったバイオメカニクス研究をされた人だと言われています

- Q43. 3次元計測装置VICONはどんな装置? (1999.05)

- ←2006年現在は、かなり進んだシステムになっているようです。

- 情報提供の問題があり1999年のデータをそのまま載せています。(2006.02)

- A43. VICONは、英国Oxford大学モーリス博士とそのグループが開発した3次元画像処理装置です。

- 被写体に反射輝度の高いターゲットマーカを取り付け5〜7台のカメラを同期撮影して注目するターゲットマークを自動追跡し、三次元座標を構築します。三次元計測はとても複雑な処理を経るので、開発当初はDECワークステーションが使われていました。

- パソコンが高速になり安価にもなってきたので、最近のシステムはWinows98/NTを使用しています。

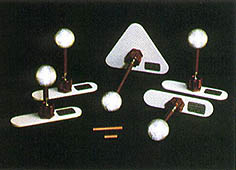

- VICONは、

- 1. データ取得用のCCDカメラ(赤外線LEDストロボ付)

- 2. データステーション370

- 3. パーソナルコンピュータ

- 4. カメラ位置を特定するキャリブレーションユニット(ダイナカル)

- 5. ターゲットマーカキッから構成されます。

- オプションとしては、

- a. フォースプレート

- b. EMG

- c. VTR

- d. VICONクリニカルマネージャ

- e. VICONクリニカルエバリュエーション

- f. キネマティックソフトウェア

- などがあります。

- データステーションは、CCDカメラ制御、画像データのA/D変換、フォースプレート、EMGなどのアナログ信号(64chまで)の収録を行います。アナログ信号のサンプリングは画像データと同期して整数倍で入力できます。データステーションとWindowsパソコンはイーサネットで通信し、ほとんどの操作と解析結果はパソコンの画面で見ることができます。

- VICONシステム。左がマーカ検出素子。

- CCDカメラを用いレンズ前面部には赤外線フィルタが装着され被写体に取り付けたマーカから反射される赤外光源をとらえる。

- カメラレンズ前面部には赤外LED光源が装着されている。

- 左側がデータ収録及びデータ処理を行うデータステーション。(1999年)

- 高速度イメージャ 200コマ/秒のサンプリングを行う。カメラは死角を出さないよう被写体の周りに5台〜7台設置される。(1999年)

- 反射マーカー。通常はφ25mm。

- 3Mのスコッチライト7610、7615が使われる。

- スコッチライトは小さなビーズ玉が埋め込まれ支持体とビーズ樹脂の屈折率の違いにより

- 入射した光と同じ方向に射出する反射輝度が高く、白紙の600〜1600倍の明るさになる。

- カメラと光源はできるだけ同一光軸より被写体に照射する必要がある。(1999年)

- 競走馬にターゲットマークを取り付け3次元計測(提供:中央競馬会)(1999年)

- データは、ASCIIファイルでオープン(XYデータ)なのでこれを使ってMacやその他のパソコンに利用しているお客様もあります。

- カメラの位置を特定するキャリブレーションにはVICONの真骨頂の手法である「DynaCal」と呼ばれるものがあります。

- この手法は、500mmの長さにターゲットマークをつけた棒を振り回すことによりカメラの座標を決定します。

- 撮影エリアをまんべんなく振り回してこれをカメラがとらえCCDの撮影位置を計算します。

- 精度はダイナミックの方が良いという結果が出ています。

- このダイナキャルはやり直しが何度もできます。

- キャリブレーションは固定ポストのマーカを読み込むStaticとダイナキャルのDynamicの2系統で別々に行うことができます。

- VICONのデータの収集時間は、フレーム数で32,000コマ(60コマ/秒で8分)となっています。

- マーカの位置づけは1回行えばよくカメラ毎の位置づけは必要ありません。

- これがVICONの大きな特徴です。得られた複数台からの座標データは、当然のごとくカメラによって見方が違いますから、データ取得後、すべてのカメラにわたって収録したターゲットマーカの座標ポイントの特定をしなければなりません。

- 旧式のVICONでは、この各CCDカメラにためられたターゲットの特定に多くの時間と労力を必要としました。

- VICON370システムでは、三次元化された画面でターゲットに名前を入れていくという作業手順ですべてのカメラからの座標データを特定するという能力を持っています。

- また、画面で見えにくい箇所はズームアップしたり視点を変えたりしながらマーカを特定できる特徴があります。

- この特徴を、お客様はかなり好意的に受け入れてくれVICONへの信頼を厚いものにしています。

- このターゲットマーク識別処理をGSI-?(Geometric Self Identification:マーカの特定作業)と読んでいます。

- この手法は、1993.7月にVICONのユーザが開発しました。

- それまではカメラ毎にマーカの特定を行っていて多大なる時間がかかりました。

- GSI手法で一気に三次元化ができるようになりました。

- VICONのデータの読み込みは520x252画素で取り込み、1024x490でコンピュータ置き換えます。

- ターゲットマーカーの中心座標は重心法で中心を求めています。

- コンピュータのデータファイルはアイコン化されビデオデータ、3次元化データ、アナログデータが有るかどうか確認できます。

- VICONシステムには、以下のオプションソフトが用意されています。

- 【オプションソフト】

- ・VCM 日本国内で作ったソフト、関節中心座標を求めるソフト

- ・VCE (VICON ClinicalEvaluation)簡易ソフト

- ・VICONレポータ 3次元データ出力、ASCII出力。一枚の用紙に他種類のデータを呼び出すことが可能。

- ・ボディビルダ VCMが下肢に対しボディビルダは体表面に対する関節中心を求めるソフト。

- ・DIFF(Data Interchange File Format)臨床歩行分析懇談会が作ったフォーマット

- VICONを使用されているユーザの関西大学 武井秀之、青柳誠司、高野政晴先生の報告(『人間の指の動作解析とロボットハンドへの応用』(第一報)『人間の指の動作解析とロボットハンドへの応用』(第一報)- 概念とVicon370を用いた予備実験 -)によりますと、人間の腕、指の動作の解析結果で、φ9mmのマーカを腕に付け、4台の200HzCCDカメラを使って、計測範囲200x200x200mmで、位置計測誤差0.1mm、標準偏差0.22の結果が出ているそうです。

- Q44. 3次元計測装置VICONでどんなことができるの? (1999年)

- A44. VICONは、Q43で三次元データをアナログ信号と共に収録できることが理解できました。

- VICONはダイナカルにより測定する空間を合理的にキャリブレーションでき、しかもそのキャリブレーション時間は、数十秒〜数分で終了します。

- 得られたデータは、レンズ歪み補正シートを加えてターゲットマーカの追跡、3次元構築を行います。得られたデータから、

- 1. ライブモニタ:マーカの三次元表示

- 2. マーカの軌跡図

- 3. マーカの番号特定及びスティックピクチャ構築

- 4. フォースプレートのベクトルデータとの重ね合わせ表示

- 5. アナログデータの重ね合わせ表示

- 6. 各種グラフ表示、オイラー角、関節角、モーメント、EMG、トルク、パワーデータ表示

- などができ、オプションで、DIFF、CAMARC変換も可能になっています。

- 以下のコンテンツは移動しました。(2000.11.20) (2012.02.01追記)

- 【私の書いた参考文献】(2012.02.01)

- 【ウルトラナック(高速度カメラ)を使った文献】

高速度カメラ入門 Q&Aトップに戻る

Anfoworldに戻ります。